M/S 処理について理解が深まらない理由

はい、最近 「studio one の使い方メモ」通称 unko さん (勝手に呼称) が、M/S 処理に関する情報を頑張って発信しているので、それに便乗したいと思いまして、この記事を書くことにしました。

ちなみに該当の M/S の項目ページは こちらから。

ちなみに私は 20 歳の時に M/S 録音をドラムレコーディングで初めて自分で行ってみて、めちゃくちゃ四苦八苦した記憶があり、その時に猛勉強した記憶があります。実は数学的には単純だし理論的にも LR の亡霊について理解している人からしたらそんなに難しくははないのですが、直感とは反する実例なので「なぜ理解が出来ないのか」を経験的にお話したいと思います。

これは私が多分、みんなこれこれこういう理由で理解が深まらないのではないか、という自分目線の話になるので、全員が参考になるかは未知数です。いつものように、知らなくてもいいけど、知っておくと便利な場合があるよって話です。

今日の朝 10 時くらいに思いつきで記事を書くと決めたので、非常に内容が拙いかもしれませんが、許してください。自分も思い出しながら、手元には 資料無し で記事を書いていますので、間違いがあったら、めちゃくちゃ優しく指摘してください!笑。

我々は LR を誤解している。

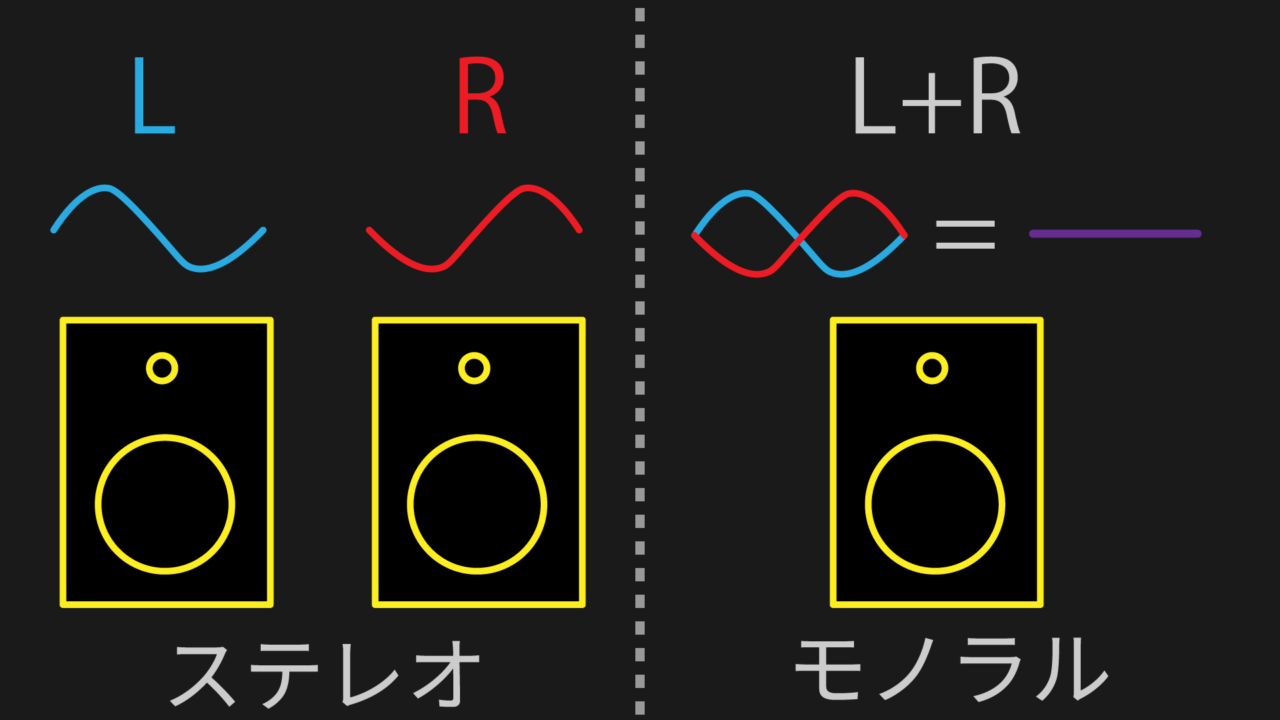

最初に、ほとんど人がステレオの幻想を誤解している。というよりかはあまり深く理解出来ていない気がする、ので 厳密ではないと思うが、ステレオの簡単な合成というか表現を解説していく。ここでは M/S の解説につながる事象だけを説明するので、LR 感の音量差 (Pan のことだと思っていいよ) については基本は考慮しない。

440 Hz の モノラル信号をステレオにするにはどうしたらいいか考える。色々あるが、M/S を理解する上で単純な事象で解説していく。

Center 成分という亡霊

では、皆さんも実際に以下の説明と同じ用に実験をしてみよう。

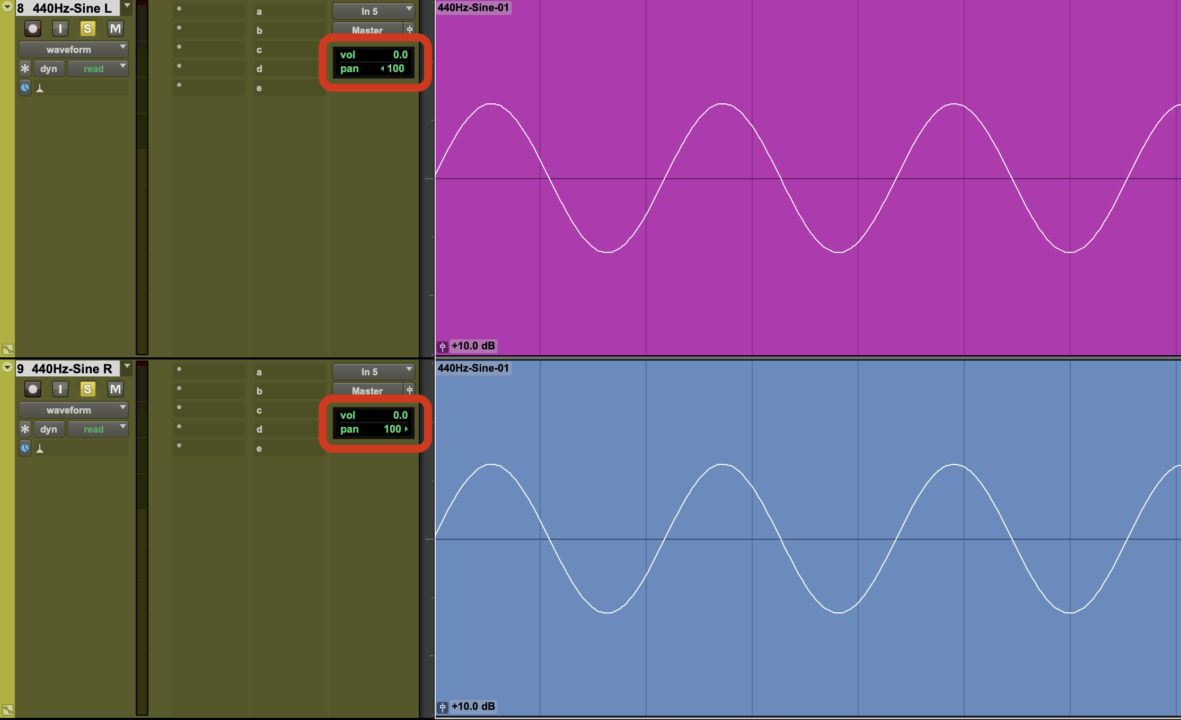

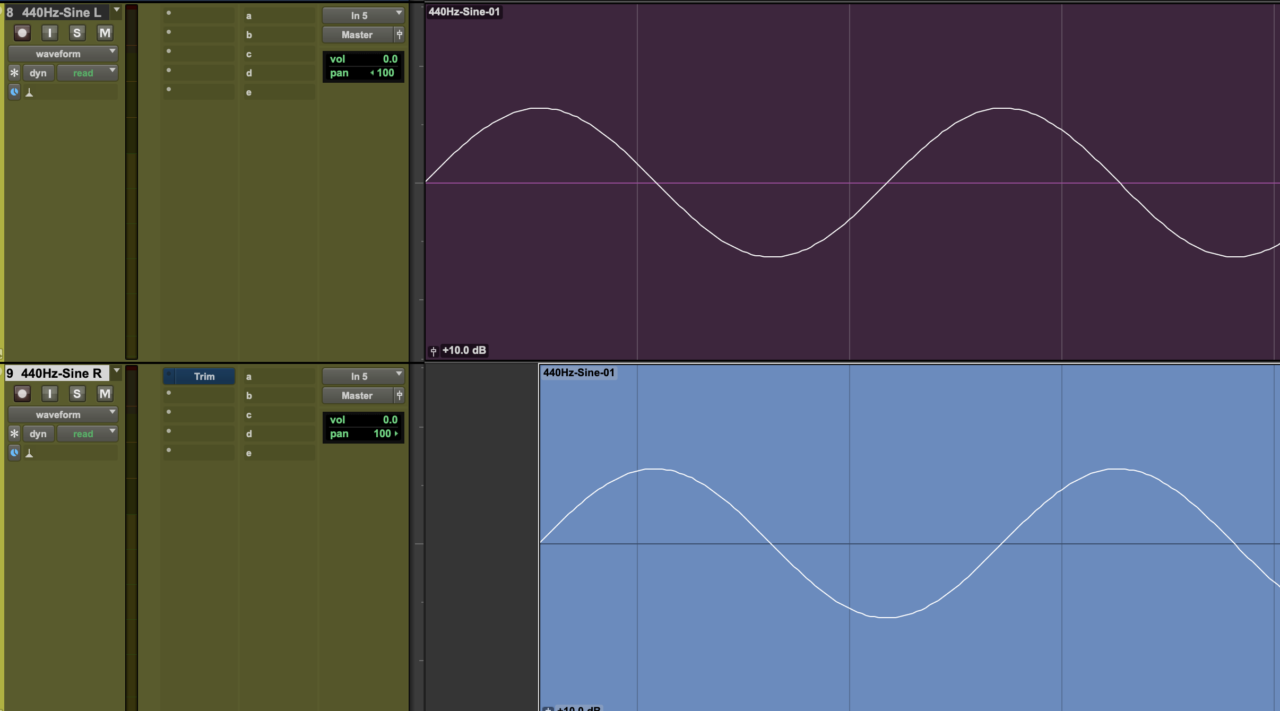

440 Hz の信号を 2 つ用意して、DAW 上でそれぞれを LR に配置してみよう。

みんな、流石にご存知だと思うけど、同じ信号を L と R に Pan で配置してもステレオの音像にはなりませんよね。これは、L と R で全く同じ信号が出力されているので、C (センター) に音があるように聞こえる「亡霊」を聞いています。これが「Phantom Center」なんて言われるやつです。

スターウォーズ・エピソード1 / ファントム・メナス を何故か思い出した。

重要なのは、 LR のスピーカーに於いて、Center と言う音は事実上、実際には存在せず、LR 間の合成で Center の音が成り立っている、ということをまず理解してください。

もちろん、5.1 ch などのサラウンドでは Center スピーカーが存在しますが、それは現在は忘れましょう。

我々の 2ch の LR のステレオは L と C と R の音があるように錯覚します。DAW 上の Pan 表記に Center、または 0 があるせいで、2ch という概念の中に 真ん中と左右 という「間違った固定概念」や常識が、人知れず、生まれてしまいます。これは仕方ありません。

しかし、LR のステレオは「L の音」と「R の音」2 つのモノラル信号でしかありません。この事実を踏まえた上で次の事象を確認していきましょう。

ステレオ (LR) の合成という亡霊

ではどうして我々は LR の 2つの信号間で広がり、ステレオ間を感じるのでしょうか。ここで言うステレオ間とは、ハードパン (音量制御) ではなく、LR の合成によって成り立つ部分に焦点を当てます。

以下の様に DAW 上に 440 Hz の Sine 波を配置してみてください。

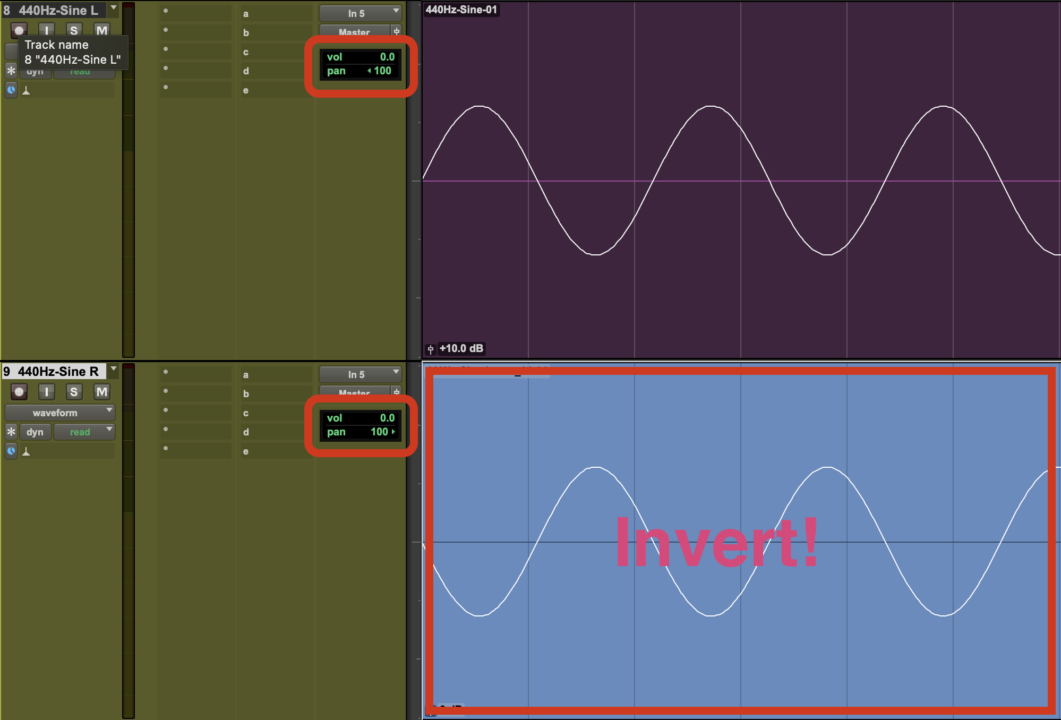

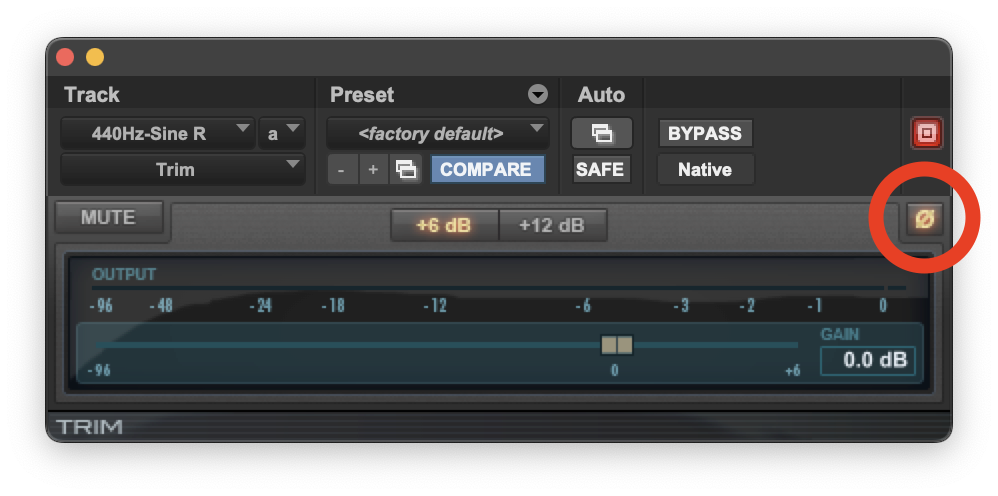

R 側の信号を Invert (反転) させてください。極性反転のやり方が分からない人は、Phase スイッチがついている初歩的なプラグインを立ち上げて、有効にしても同じです。

この状況で音を聞いてみると、よく言う「位相が悪い」的な表現をする音になります。

ちょっと音は不自然ですが、これはステレオとみなしても問題なさそうですよね。

ちょっと余談になりますが「位相が悪い」の定義というか、まぁ、仕事しているとよく聞く「位相が悪いですよね」の意味は未だに各個人でマジでバラバラで、音が OFF 気味なのを位相が悪い、とかいう人もいれば、低域が薄い音を位相が悪い、とか言って、マジで「位相が悪い」の言葉は現場にとって非常に害悪な表現だとは思います。ええ、ただのグチです。気にしないでください。

ここでは 私が思う「位相が悪い」の定義を一つ述べておきます。それは、

です。これはあくまで私個人が「位相が悪い」の言葉を使うときの目安で、別に厳密なものではありません。しかし、なんとなく理解できるように解説していきます。

図2 の状況で音を鳴らしつつ、頭を左右に振ったり、前後に動いてみてください。

これが、よく言う「位相が悪い」という状況です。たぶん、位相が悪いの言葉を乱用している人達はおそらく、低域の見えづらさ、音や抜けの悪さ、音の OFF 感、を位相が悪いと言っている気がします。これは個人的な話で別に同意しなくていいです。

低域の場合は複数の音が反転気味になって低域干渉 (打ち消し合い) をする場合がありますが、これはフェーズシフトやタイムアライメント等で解消出来る問題で、私の位相が悪いの定義からすると モノラルなら 位相は悪くないです。その局面で同じ周波数帯の位相、または時間軸が、対象からずれてるだけです。(位相はある局面のことですし、大体打ち消し合いは知覚はできない、チェックして初めて分かる) ただ、タイミングチェックやフェーズチェックは念入りにしますよ。Phase スイッチぽちぽち。

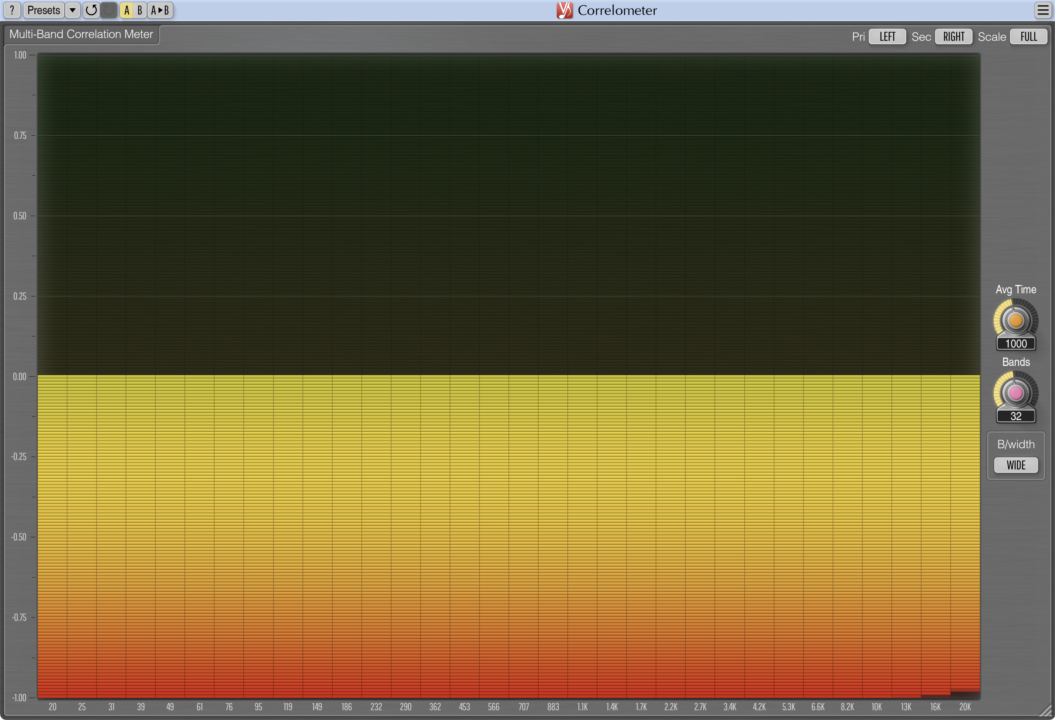

一応、コリレーションメーターを使って簡単に解説しますね。

位相差の亡霊

まずは、図2 のコリレーションメーター画像。

このコラロメータ (Correlometer) のコリレーション (Correlation) とは、位相ズレをメータリングするツール。最初は慣れるまでちょっととっつきにくいけど、+1.00 ならモノラル、それ以降は LR の位相差を 0.99 〜 -1.00 で表現する。使っていく内に理解できるようになると思うので、まずは、自分のセッションのステレオ素材でメーターを見て「よくわかんねぇな〜?」でいいです。

マイナス にふれると LR 間で逆相成分が多いですよって意味。

図4 を解説すると、LR 間の音は完全に逆相ですね、って言ってる。

ちなみに、Pan で モノラルの 440 Hz の信号を左右に振ってもコリレーションは +1.00 のままです。ご自分で試してみてください。これは LR 間をステレオ位相差を見ているので、位相が悪い、的な表現を私がするなら、LR の Pan では位相が悪くなることはありえません。

もちろん、複合的な音が混ざり合うシチュエーションでは異なりますが、モノラル信号を Pan してもモノ互換が保持できるので、エンジニアさんは Mono 信号は 1ch 仕様でデータを送ってくれ、とうるさく言うのだ。モノラル信号をマルチモノデータで送らないほうがいいぞ。多分。たぶん!

また、モノラルにおいての位相差における打ち消し合いはそもそも信号として観測できないので、コリレーションメータは役に立たないことを注意事項として述べておきます。

さて、なぜ、位相の話をしたかというと、実は 位相が悪い と人間は ステレオ感 を感じます。

だって、図2 の音聞いて、ステレオを感じられたでしょ?

そうなんだ、LR におけるステレオ感というのは実は 位相差 が生み出してる 亡霊 なんだ。

実際にはこれは極端の究極系のステレオの体験なので、LR の Pan の位置を狭めたりすると、多少の違和感も減ってくる。この基本形が Stereo Width の正体である、多分。この状態はスコープ等で見ると最悪の状況なので、できるだけ Correlation がマイナスを維持しないようにステレオ素材を調整しようね。

もうすこし、具体的な例を簡単にもう一つ紹介しよう。

それでは、次に「ハース効果」を利用した場合のステレオの表現を見てみよう。

ハース効果とは、同じ信号が左右で時間差で発音したときに、どっちの耳へ音が先に到達するか、っていう効果を利用したステレオの音像効果。Pan とは違う。

みなさんも同じ様に DAW 上でこれを再現してみよう。ちなみに Invert した信号は元に戻そう。

R 側の音を遅らせてみたが、音の定位が左に寄ったのがわかるでしょうか。

これが、ステレオの亡霊です。実際には我々は 2ch 上では LR の位相差を聞いて、ステレオと感じている事実が何となく実感出来たのではないでしょうか。この LR の位相差の亡霊を理解していないと、M/S の理解が全然深まりません。

これで我々が感じている ステレオ感 というのは、LR の 位相差 である と理解できたのではないしょうか。念押ししておきますが、我々は L の音と R の音しか聞いてないことを再度説明しておきます。Center というのは亡霊で、ステレオ感というのも、L 側のモノラル信号と R 側のモノラル信号の合成で感じているだけです。もう一つ念押ししますが、モノラル信号は Pan だけではステレオ感は演出できません。

モノラルの亡霊

最近は結構 モノラルでチェックしましょう、的なことを言います。

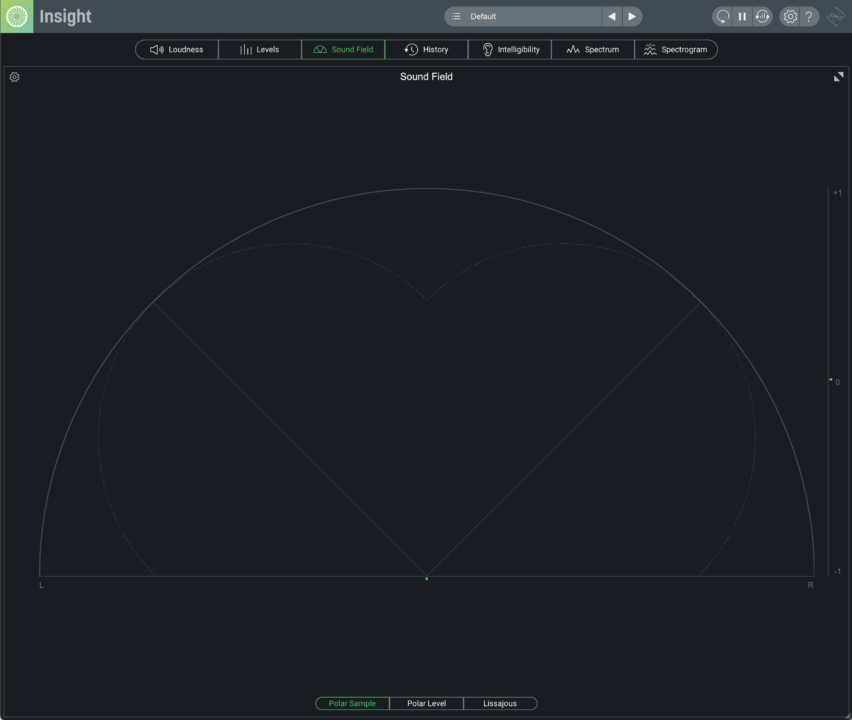

また、図2 の状況に戻ってみてください。この状況でモニターをモノラルで聞いてみる。例えばオーディオインターフェースのモニター機能に Mono があれば、それを利用したり、Master の Pan を LR ともにハードセンターにしてみたり。あとは モニタープラグインの モノラルモード なのか Mid モードで聞いてみる。

実際にはモノラルが Only L ch なのか LR Summed なのか、で聞こえ方は全然ちがうので、なんだかなぁ…って思いますが、通常は LR の合成が 1ch で出力というものであると踏まえ、チェックしてみる。

Panipulator はフリーのモニタープラグインで真ん中にでかく モノラルで聞く ってボタンがあるのでそれでチェックする。

すると、どうだろう。DAW 上ではしっかりメーターは振れているだろうが、スピーカーから音がでないでしょう!

完全な逆相成分が LR で発生していると、LR の合成モノラルの場合、合算した時に信号の打ち消し合いが発生してスピーカーで再生すらしない状況となる。この現象が発生する音源は事故音源だのなんだの言われる場合がありますが、まぁ正直覚悟の上だったのは…? とは思ったりもしますが、まぁ他人のことはどうでもいいです。

だから、意図的に狙う以外は、しっかりモノラルで確認しておきましょう、という話で、別にモノ互換がない音源がクソ、という評価には直結はしないとは思います、が、ただ確認はしとけよ? って話です。

ちょっとした豆知識

最近 Low End を Center に寄せましょう、的なものをよく言われる原因は、低域に LR の位相差があると周期が長いので非常に人間は敏感に違和感を感じ、かつ現実世界でフォーカスが合いにくいので Low End にエネルギーがあっても実際に人間の耳で知覚しづらくなる、だから LR 感で位相差をなくして Low End にフォーカスしませんか? というもの。だから Bass Center、Mono Make しましょうって言われてる。別に、低域のコリレーションを気にしない、Low のフォーカスよりも演出的に必要、であればじゃんじゃん Low End もステレオ化しよう。強迫観念のように Low End を Mono Make しなくてもいい。左右の端から低域飛んでくるのすげえ好きだし。

さて、ここまではずっとステレオと LR の話をしましたが、次に M/S の話をしましょう。

M/S の理解自体はそんなに難しくない

何度も言いますが、ステレオは L と R の 2ch の合成です。決して、L と C と R の 3ch の合成ではありません。L ch のモノラル信号と R ch のモノラル信号が別々のスピーカーから出力されることによって、ステレオ感が再現されています。この事実を頭に常に浮かべた状態で、M/S、Mid/Side の話をしましょう。

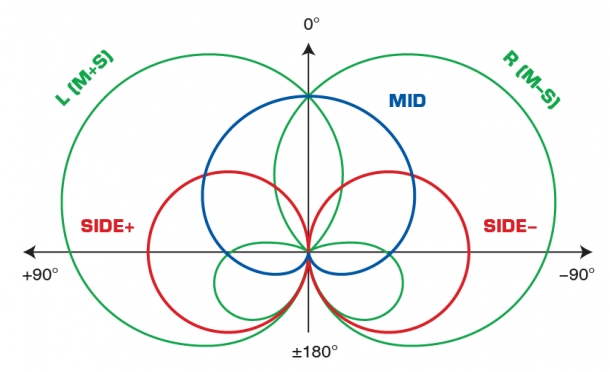

一応、前置きとして、数ある DTM のページや普通にプロのエンジニア、プロのレッスン講師 でもで M/S 処理について、

- M はステレオ LR の C センター成分

- S はステレオ LR の両サイド成分

というものを平然と言い放っており、これらは すべて間違い であることを踏まえて、それを頭に入れた上で以下を読んでください。

よく説明される M/S の数式ですが、

L + R = Mid

L - R = Sideこの意味を考えましょう。

図8 の状況を思い浮かべてみてください。

L + R してますよね。つまり、Mid は逆相成分が打ち消しあったモノラル信号と同位であるといえます。

ここでちょっと躓いてしまう方は、おそらく「L + R = Mid (Stereo)」と思い浮かべてしまって「???」になる方もいると思いますが、これは 間違い で、L も R もモノラル信号であり、 もちろん Mid も 1ch モノラル信号です。

そして同様に「L – R = Side」もモノラル信号です。結構な方がおそらく Side 信号を ステレオ だと漠然と勘違いしている場合があります。Mid も Side もモノラル信号です。念押ししますが、L も R もモノラル信号です。

Side 成分とは LR 間の逆相成分の 1ch モノラル信号

であることが、ここで理解できましたか?

⚠ M/S における Mid は センターの音でもなく、Side が スピーカサイド、LR の (端の) 音でも無いこと を理解できたと思います。

そして、この合成が理解できると「Pan したモノラル信号は 例え ハードレフトやハードライト、LR どちらかの端に追いやっても、Mid 成分であり、モノラル互換がある。」という事実がわかってもらえれば、すげぇ嬉しいです。ここも重要だと思うよ。複雑な周波数体系になれば、Pan した信号も多少消えるだろうけども。

studio one の使い方メモ、長いので unko さんと略しますが、unko さんが言いたかったことがここで理解は出来たのではないでしょうか。

M/S の合成について考える

では M/S がどの様な状況を生み出すのかを考えてみましょう。

(Mid + Side)/2 = L

(Mid - Side)/2 = Rこれが、M/S を LR に変換するための合成式です。DAW 上で表現してみました。

まず、LR を M/S に変換して再度 LR に戻します。音量は適当です。すみません。

さぁ、みんなもステレオの素材を LR Split して、同じ様に DAW 上でこの Matrix を再現してみよう。

M/S Matrix を DAW 上で再現するとこんなにも面倒なルーティングになります。全然関係のないグチですが Pro Tools には Send ch に Phase Invert 機能がないので -Side に Plugin を Insert して Phase Invert している、マジで Send に Phase Invert つけてお願い Pro Tools!

Track 上では +Side と -Side のトラックがありますが、Send に Phase スイッチがあれば、別に M/S に +Side と -Side のトラックは必要ない。ただの合成チャンネルになる。ただ、ここでは +Side と -Side が別々のチェーンとして見える。

ここで、ん? って思ってもらえる方いたら、優秀だ。M+S と M-S で合成できるなら +Side と -Side ってチャンネル必要なのか?って。

そう、ただの M/S 合成式 (M+S, M-S) と、この M/S 処理 (や M/S マイキング) を同じものと捉えると エライコッチャ になる。問題はモノラルだったはずの S が +Side と -Side で別々の処理ができてしまう。つまりは M と S は +Side と -Side で LR 間のステレオの処理ができてしまうことになる。

いつの間に 3 ch (DAW 上では Send で送っているので本当は 4 ch) の処理になったんや!

実は…

L + (+R) = M

L + (-R) = Sという表記が厳密には正しく、この変換式の時点で、実際には R の信号は 2ch 存在することになり、計算上は 3ch を式上で扱っている。

DAW 上のトラックでは -R だけ準備すればいいが、同じ L ch をわかりやすいように用意して 4 ch となっている。計算式上 L も分岐する必要性があるから物理的には 4ch は必要になる。シグナルフローの理解は難しいのでお勉強は多少必要である…

M/S の場合も…

Mid + (+Side) = L

Mid + (-Side) = R※ 1/2 のエネルギー計算は省略

と厳密にはなるので、Side の信号は 2ch に分岐する。もちろん Mid もモノラルだが、DAW の物理上は Mid も分岐する必要があるので合計 4ch のプロセスとなる。あれれ〜、モノラル 2ch だけあればよかったはずなのに…

そしてここで Side 信号が 図2 と 全く同じ状況のステレオ処理 になっているのがわかるだろうか?

同じモノラル信号の正相と逆相の信号同士が L と R に配置されているので、全く同じですよね。図2 の状況ってすごく基礎的な状況だって理解できた?

そう、これが諸悪根源だ。M/S がなかなか理解できなかったり、勘違いしてしまうのは、M/S の合成式は M と S はそれぞれ、モノラルの合成なのに対して、実際の M/S プロセッシング (LR 合成直前) は最初の 図2 と同じ正相 L と逆相 R の合成からなるので、+Side と -Side では合成時はステレオの処理になるのだ!

ただし、元信号はモノラルであることを忘れてはいけないぞ!

もう一度念押ししておくが、M も S もモノラル信号。そして +Side と -Side の合成は 図2 の様な合成ステレオと同条件であり、確かに処理的にはステレオとみなすことができ、合成時にステレオ出力となる。

で、通常の M/S (や M/S マイキング) の解説を見ると、こんな解説図になっている。

この図を素直に読み解こうとしたら、Mid 成分は L C R の「Center 成分」で Side 成分が L C R の「L 成分と R 成分である」、「Side 成分はステレオ信号」というような 勘違いは誰でもしてしまうぞ。ホンマに。だから「みんな M/S 理解できなくても悪くない」と思う。

LR のステレオ空間は モノラル L とモノラル R の位相差で表現されていることを知らなきゃ、M/S ≒ LCR の誤解はしちゃうのはホントに仕方ないと思う、ましてや、ちゃーんと説明している Web ページは多分 日本語 じゃここだけだと思うから、みんな間違えてそれが広まるのは別になんていうか、みんなもっと真剣に音楽やれってだけじゃないかな笑。

というか英語サイトでもここまで丁寧に解説してないぞ、自分は見たこと無い。しかも、基本的なステレオマイク収録素材の場合、M がセンター成分、S が LR 成分っぽい挙動するし (実際には極端なステレオサイド成分は M に集中するんだけど)、その場合の素材の M/S 挙動の説明としては直感的には間違ってないんだよ、M が C、S が LR っぽいよねって説明。もちろん、M/S マイクテクニックを人から教わった経験上、そう教えられたし… だからタチが悪いんだろうね。

あくまで、数学上は M はモノラル互換成分、例えモノラル信号を Pan で L や R に振っても Mid 成分であり、逆相成分を含まない音。で S は LR 間の逆相成分 (差分) であることを忘れてはいけない。これらを合成すると、LR 感の位相差により、ステレオが表現される。

以上の説明が厳密には間違ってたらすいません。S はステレオ差分って解説されていたりするからややこしい。この当たりは諸先輩方に怒られたて、またクソ無知野郎がクソな事言ってるっていわれたら、多分、修正入ります。

モノラル互換の再確認

さて、皆さん、私と同じ様 (図9) に合成 Matrix を DAW 上に再現出来たと思います。

では、Panipulator で MONO にして、Mid (L+R) のフェーダーを下げてみましょう。Mid はモノラル成分と同義なので、どんどん音が小さくなっていき、最終的には音が聞こえなくなると思います。

でも Side の音は信号出力されていますよね?

これがよく言う モノ互換 の話です。モノで聞くと音が消える現象の原因。

MONO 視聴をやめて、Mid を下げつつ、Side と -Side だけ聞いてみてください。もちろん、Side は LR 間で正相と逆相を聞いているので、図2 と全く同じ状況であるわけで、どんどん音が気持ち悪く聞こえてきます。これが俗に言う「位相が悪い」ってやつですね。定位感が全くわからず、音がふわふわしている感じのやつ。

つまり、M/S のいい塩梅値、あるバランスを超える (Correlation がマイナスに振れまくる) と非常に最悪な処理に発展するということは理解できるだろう? だって S 成分が増えれば位相が悪い音になるし、モノラル再生されるシチュエーションで音が聞こえない原因になるし、とぶっちゃけいいことがない。

そう、M/S プロセッシングを理解せずに利用してしまうと、結構ヤバめな落とし穴が待っているぞ、と警告しているのが、unko さんです。ブリブリです。

これで、

- Mid 成分がステレオのセンター成分の音ではない事

- Side 成分がステレオの両端成分と言う意味の音ではない事

が 99 % は理解できたと思います。

M/S の概念としては、Mid が軸であり、Mid がしっかりエネルギーとして存在しているからこそ、S の合成でステレオ感の亡霊の表現ができるということである。M/S 処理で M のエネルギーが少なくなると、LR の位相差が酷く発生することになり、結果的に私が定義した「位相が悪い音」になる。

だから、Mid がどっしり構えていて、そこに S のさじ加減で「位相差」が生まれると考えて欲しい。実は重要なのは Mid である。

ただ、重く考えても仕方ないので基本は Mid、S は M の逆相成分ということを頭に入れていれば、大丈夫なんじゃないかな? ぶっちゃけ、普通の LR 素材だったら全然 M/S のバランスを変更しても大丈夫、多分。一定のコリレーションを超えなければバンバンやってもいいと思う。

正直、実務で M/S レコーディングを実際に行っている人以外、数学的な知見と音響物理的な知見がないとかなり理解に悩むシロモノではあるし、しかも Fader 側で M/S のバランス調整しようとするとマジで事故る原因だったりするし、1 dB の差でも十分ステレオが崩壊してくる場合があるから、調整するならスコープやコリレーション、モノ互換をチェックしつつ、ほんの少しですよ。

知識が無く、特に考えずに利用するとかなりヤケドしそうな匂いがするプロセスであることは理解してくれたと思います。M/S は数学的な合成の結果で、M/S 自体が悪いわけではないです。あくまで理論的に LR を M と S に分けることが出来て、それを上手く調整すると、ステレオの Width 調整ができるっていう数学的なものです。

これらは LR と M/S で見え方が違うそれぞれのモノラル信号であるだけで、本質的には全く同じ信号です。これらは少し応用数学や物理学的な視点が無いとちょっと厳しい部分もあるかもしれませんが、理解すると便利だよってシロモノです。

M/S 処理は基本やめろってこと…?

「違う、そうじゃない」(by 鈴木雅之)

簡単にいうと、モノラル互換を保ちつつ利用するか、メリットデメリット全部理解して、わかった上で無視して使うか、です。

みんな、M/S って聞くと Side ばかりフォーカスしたりフューチャーすると思うのですが、ステレオ素材でも、広がりすぎぃ! とかなんか違和感感じるステレオ素材だな〜、みたいな素材があったら、M/S 処理で Side を下げてやれば、多少は改善する場合もあるでしょう。

だから、多少は Correlometer を見たり、スコープを見たりして相関を確認しつつ、こいつ Stereo のコリレーションやべぇな? っ的な素材見つけたら M/S のバランスで修正してやるとか。

重要なのは「M/S が悪である」ということではなく「毒にも薬にもなる」的な視点であり、ステレオの位相差が “ある許容” 例えばモノ互換であったり、音の違和感等を与えない程度に積極的に利用していくことは決して悪いことじゃない。重要なのはさじ加減の許容をどう設定できるか、である。

もちろん、FX 的な意味で Side 側のレベルを上げて気持ち悪さを演出したりもできるでしょう。モノ互換は多少諦める覚悟で。

ダブリング

ダブリング録音における、LR の問題は非常に根深い。

ダブリングは同じ様に演奏したトラックの僅かな位相差を利用して LR で配置することが多いが、演奏がかなり再現性が左右で高いと、逆に「位相が悪い」言い換えると定位がふらつき安定しない音になる場合もある。そこが狙い目でもあるが。

そこで、もっとダブリングの効果を明確に出すために、みんな Chorus かけたりちょっと Delay かけたり、ピッチモジュレーションしたり、なんかするわけで。

そんなトラックにおいて、ギターバッキングのダブリングについて多少話をしようと思う。

ギターの場合、コード進行等の場合は周波数が複雑になったり、多少のストローク違いでステレオ感は十分に発揮する場合があるのですが、ことバッキングの場合、低域に音のカタマリが寄りますよね、例えば 6 弦単音ブリッジミュート刻みとか。

この場合、演奏者が再現性が高いと、バッキングの定位がかなりセンターに寄ります。悪いことじゃないんですが、バッキングのときだけセンターの音にやたら干渉して、せっかく Pan で LR に配置した意味が多少薄れます。

この場合、M/S 処理で Side 成分を多少持ち上げることで LR のステレオ互換性を保ちつつ調整、ということが出来ます。もちろん、元々 Mid 成分が多いので多少 M/S のバランスをイジってもモノラルで気持ち悪いことにはなりにくいです。結構イジっても許容から逸脱しづらいです。

Mid が強い場合には積極的に使える場合がある

もちろん、M/S でコンプレッションできるコンプレッサーを利用すれば、Mid 成分が増えた時に Threshold に達するように設定し、音を圧縮、もといゲインが下がりさえすれば、特定のフレーズに Mid コンプが動作し、センターへの干渉を抑えるなど、出来ます。

センターとか言ってますが、あくまで Mid 成分が多い LR の素材に対して多少の Width 制御やサイドチェーンを考えているだけで、これらは極端なモノ互換を崩壊させるものではない素材に対して行っていることに注意。

コリレーションの数値を見ながら M/S の比を変えていき、マイナスに振れ幅が大きくならない程度であれば、全然利用していいものかと思います。元から、LR のコリレーション数値が低い素材に対して S の比を上げることは悪手であることはほぼ間違いないです。しかし、コリレーションや実際聞いてみて許容を超えない限りは M/S の比を変えることは別に悪いことではありません。

もちろん、Side 側だけに Saturation をかけたり、Ducking で Mid、もしくは Side の音だけをリダクションしたり、Mid 側に HPF をかけて低域の干渉を抑えたり、もちろん低域のコリレーションを考えて Side の不要な低域をカットする、などなど、M/S は LR では決して実現しなかったシグナルフローを実現させます。

要は発想と応用次第です。

Dynamic Stereo Imager

もちろん、M/S 系のなかには面白い効果を演出するプラグインもあります。

たとえば、このプラグインは入力された信号レベルに対してフレキシブルに Stereo の Width を広げてくれるというもの。Maximizer と名前がついているが、ちょっとした小技にも使える。現状は MONO 互換を維持したままステレオイメージを広げてくれる、Master Chain 用って感じがするが、もちろん Zero Latency Version もあって、普通に Mix でも使える。

まぁ、工夫次第、応用次第であるが、ダイナミクスレンジが広い素材には結構行ける。

スネアとかハードヒットのときは、広がりを感じるけど、通常のセンターヒット時はセンターを維持、みたいな感じとか、たまにやるぞい。

EQ

普通に Side 側の主に 1kHz 以上だが位相差をもっと作り出して Stereo 感の強化 (ダブリング系やステレオマイク素材が主) や Side 側の Low End をカットして、Low End への不要な干渉を裂ける目的とか、全然ある。

あと、M と S をそれぞれ Solo で聞いたほうが 共振周波数 や不要な一定周波数の確認が楽なことが多い。だいたい問題のある共振周波数は Mid に多いような気がする。あまり Side EQ を積極的には私はあまり行ってきてないけど、ハイゲインギター系は M と S の EQ は結構上手くいく気がする。

あと、私は Cymbals 系は位相が多少悪くてもステレオの端に配置したい場合がある。センターにあんな超高音周波数の音を集中させたくないっていう、よくわからんポリシーがあるのだが、そのために結構 Cymbals 系の配置を M/S でイジってあげることがある、というかほぼ毎回やってる気がする。

ステレオのシンバル音の素材は Panning は変えられないので、LR のこの位置! っていう調整に M/S を利用する場合はある。ただ、Cymbals 系の Top のステレオ素材はスネアやキックの Mid 成分も十分に多いし、音がどんどん外側に音が配置していくような感覚で、外側外側みたいな感覚で万能というわけでもない。だから外科的に S の信号を EQ して、それっぽい位置に配置させるみたいなことはする。なかなかうまくは行かないけど。

M と S の微妙なバランス感覚の調整もしくは、Stereo Imager 系のプラグインをパラレルで混ぜていきつつ、モノラル互換を確認しつつ、と言う感じが実用的。実際 M/S プロセッシングの % をイジるとしても、150 % 〜 200 % 以上イジることは稀で、賞味微々たる変化である。

まぁ、結構音が変でも、モノラル確認で、全然許容範囲じゃね?って思ったら全然 M/S 処理やります。

まとめ

M/S はたしかに、初心者が触ると大怪我する筆頭みたいな技術ですが、何事も、理解とさじ加減で自分で上手くコントロールできれば強い味方になります。

おそらく、マスターセクションで M/S を調整する利点はほぼ無いです。マスター自体がやばい場合はその限りではないと思いますが…まぁ、M/S の EQ や Comp はあり得るのかな? マスタリングエンジニアではないので、詳しくはそちらへ…

ただ、ステレオ素材、各トラックごとで M/S の比を調整することは別に悪いことではありません。どうせ Master セクションでどんどん周波数は複雑化していくので 2mix で聞く頃には普通はコリレーションがまぁまぁ安定してきますし。

要は、理解すればそれなりに利用価値は頭の回転が早い人だったらいくらでも出てくるぞ、っていうモノで、歪みの記事 でも語ったようなことが根底にあるということです。全ては己の音楽的感性に左右されるぞい、的な。

利用する場合、その素材がどんな状況かをスコープ、またはコリレーションのメーターで確認し、実際の音像やメーターの数値、自分の価値視点と数学的なメーターの両方の意見を尊重しつつ、利用していくことが大事かと思います。

たまに、メーターやアナライザーをバカにしたような意見を言う人や、数値と実際の感じ方に乖離があるからメーターを見るのをやめろ、とか、測定メーターはエビデンスにならない、なんて言うことを言う人がいますが、本当に実務的にトッププロとして活動している人は、数値やメーターを自分の耳以上に信用しています。数値 (これは数学波形としての測定値) 的には問題なさそうだが、実際の出音はなぜ、数値と乖離するのか、という判断基準に利用できるからです。問題があると認識するためにはメーターはめちゃくちゃ重要です。

まずは、ステレオとはなんぞや、LR は それぞれモノラル信号だぞ、M/S もそれぞれはモノラル信号だぞ、我々はモノラル合成の音「ステレオの亡霊」を見ているんだぞ、そんなことを理解すると信号処理に関してもう少し深い理解が得られると思います。

この場で、studio one の使い方メモ、もとい unko ちゃんに敬礼。