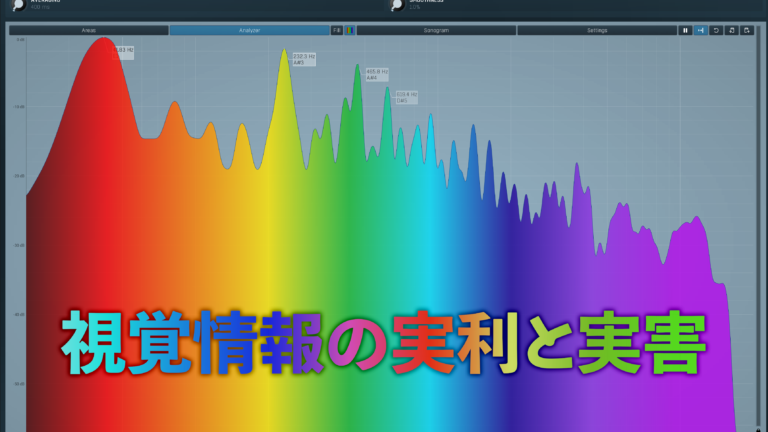

究極の選択・アナログかデジタルか

実機を買うべきなのか、プラグインで済ませるべきなのか、非常に悩むことが多いと思います。この手の解説ページもゴマンとありますが、素直に納得できる記事がないので、一つ今日思ったことをわかりやすいように、まとめたいと思います。

この記事はどちらがいいか、ではなく、選択する理由について、つまりどちらを使うべきなのかを、そのシチュエーションも交えてわかりやすく考えています。

アナログとデジタルどちらが有利なのか

この話をしたら、永遠に決着が付きません。ですから、まずは勝負させることがいいと思います。それぞれ 利点、欠点 ありますから。

1. コストパフォーマンス (値段)

圧倒的プラグイン。実機が 100万円 するとしたら、プラグインは高いもので 30,000円。

また、実機はメンテナンスが必要です。これが高いんだ。また電気代もかかる。ケーブルだって必要だし、場所も取る。熱い。温度湿度管理も非常に大切。

ただし、Vitage モノは価値が下がりにくく、資産価値としてみなすこともできる。買ったときと同じ値段で売れるものあるし、高く付くこともある。しかし諸経費含むとやはりプラグインに比べては割高。

2. 音の良さ

一概に「良い」と言えないアナログ。

なぜかと言うと、いい音というのが、歪が少ない音なのか、ノイズが少ないことなのか、基準が非常に曖昧 だからです。工学的なお話をすると、歪みとノイズは悪であります。しかし、音楽的に言うと 歪みとノイズがいい結果を生む場合もある のです。

特にアナログ機材の音がいい、と言われる理由は、歪み です。

既に解析されていますが、歪みが音に与える影響は計り知れません。実機の良さは歪みであり、古い機材ほどノイズフロアが大きい傾向にあります。「サー」とか言っている音ね。

プラグインも音の評価は難しい。

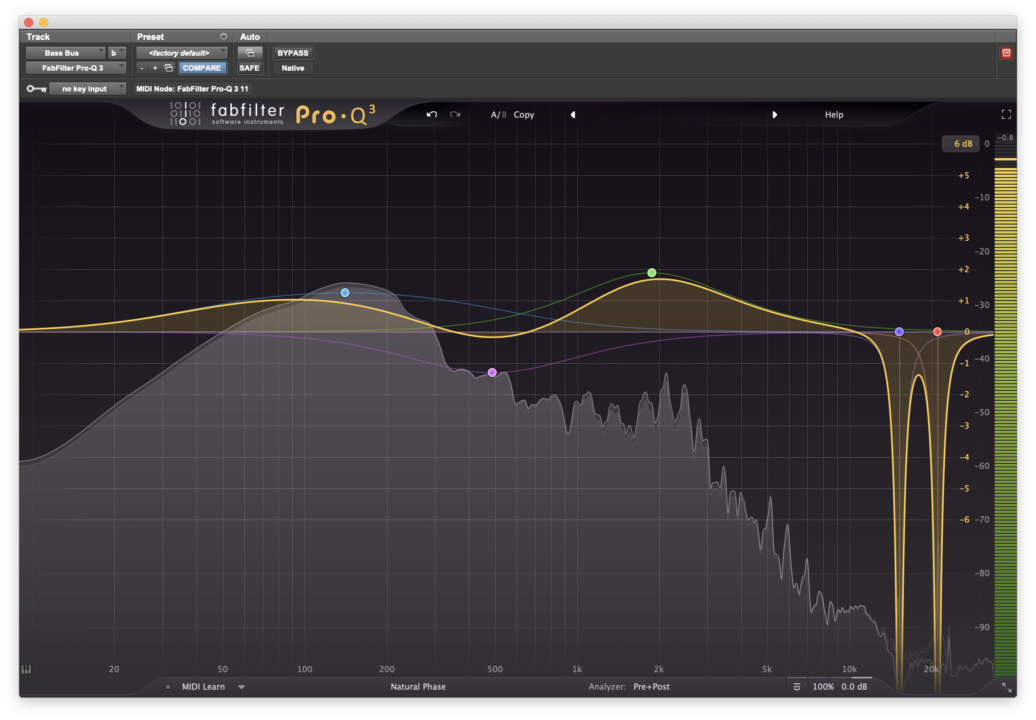

例えば、EQ の場合は Q カーブ がリニア的にそっくりなだけで、歪みが再現されていないと、EQ の掛かり具合や音が似る、ということが起きにくいです。ただ最近のは非常に似ているので、モデリングすごいです。

ただし、正直、実機をまともに知らないのにモデリングに手を出すのは少々悪手だとは思います。しかし最近はソフトウェアはデモが簡単に可能なので、デモしてみることが大事で、ついでにアナログをある程度触れると、なお良いと思います。

ただし、プラグイン上の歪みというのは、デジタル領域では非常に害悪な存在です。リニアな歪みになりやすく、また、折返しノイズの原因となります。強烈な音作りをしない限り、そこまで影響を与えるものではないですが、気にする必要はあるものだと思います。

折返しノイズについては別途解説されているページがゴマンとありますので、そちらをご参照ください。

3. 利便性

圧倒的にプラグインが勝る、と思う方は 実機をほとんど触ったことない人 だと思います。直感的に目的のツマミに到達できるスピード、両手でツマミをイジれるフレキシブルさ、微細なツマミの調整、どれをとっても実機に勝るものはありません。

コンピューター上に2つマウスが表示されて独立して動かせるようになっても、実機のほうが、自分の作りたい音に到達するスピード は 1/3 くらいではないでしょうか。

ただし、リコールはできません。プリセットもありません。ガリがでます。プラグインは面倒なルーティングも必要ありません。レベルマッチングについて知識も入りません。多チャンネル I/O も必要ありません。とにかく低コスト。

比較を踏まえて

他にも比べる的部分はあると思いますが、大まかに3種上げました。

結果は プラグインが 1勝2分 と、コスト面で大幅なリードだとは思います。

ただし、このような勝負をしても、絶対にアナログデジタル戦争は終わりません。

アナログ機材の使われ方の変化

まず、これを説明しないことにはなぜ、アナログ機材を使うのか? を理解できない。

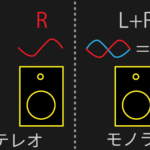

大まかに説明すると、1960年代初期 はまだ、2トラックレコーディングが主流です。つまり、レコーディングした 2ch ステレオないしマルチモノ信号がその場で完パケの状態になります。

つまり、

と同等の状態であったわけです。そのためレコーディングする時に音作りは完了する必要がありました。アナログ機材本来の利用用途としては、その場での音決めです。

1960年代後半に 8 トラックレコーダが主流になり始め、1970年代にはすぐに、16 トラック、そして1970年代なかばで 24 トラック仕様になります。

そして奇跡の 1975年 がやってきます。

「1975年」という転換期

1975年といえば、Game-Changer が登場します。Harrison のコンソールです。

MixBus 32C という Harrison のコンソールモデルの DAW があることをご存知だろうか?

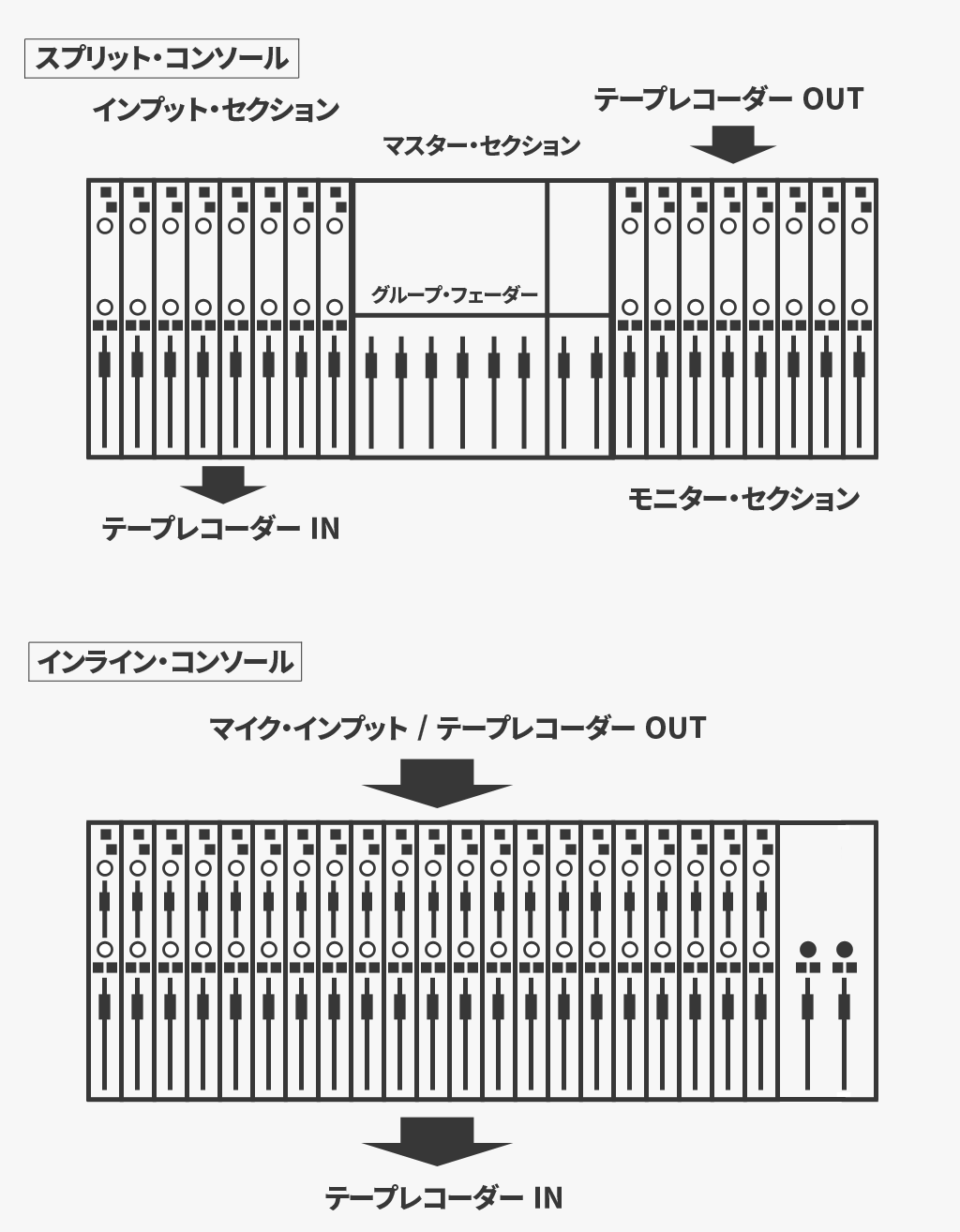

この年、米国 Harrison 社から発表された「Harrison MCI 3232」は、世界初のインライン式コンソール として、それまで主流だったスプリット式に対する転換点となりました。

インライン・コンソールが登場する以前、インプットチャンネルとテープモニターチャンネルは、それぞれ左右に独立した二つのミキサー部として、構造的に完全に「分かれて」存在していました。「スプリット」という単語は、そうした物理的な信号の分離が由来になっています。

それに対して、インライン式の構造では、両信号はひとつのチャンネルストリップ内に流れ込み、共存しています。そのおかげで、バウンスの度に必要だった外部パッチングが不要になったり、テープアウトやインプットボリュームの調整が、一つのチャンネル上で完結できるようになったのです。

音楽の専門学校でも実は、ちゃんと スプリットコンソール と インラインコンソール について教えるはずなんですが、このスプリットとインラインがアナログ機材のあり方を大きく変えてしまいます。

これの何がすごいのか、理解できない人は、少々置いてきぼりになるかもしません。ここでお話しているのは、ライブ現場でよく見かける、ミキサーとは異なります。あれはスプリット型です。詳しくは別ページをご参照ください。こちら

インラインコンソール

従来のスプリット型コンソールはレコーディングチャンネルとモニターチャンネルは別々に立ち上げる必要でしたが、インラインコンソールの登場により、レコードチャンネルとモニターチャンネルの共存が可能になり、チャンネルストリップをレコードチャンネルかモニターチャンネルどちらかに適応することが選べ得るようになり、とりあえず、モニター側にエフェクトを掛けていく手法が主流になりました。

つまり録音される音はドライ、モニターしている音はプロセッシング後、というようにです。レコードされる信号にはアナログエフェクトは適応されない信号経路が同じチャンネル上で可能になったこと、複雑、煩雑なルーティングが解消され、これが後々のプロダクションに大いに関わってくる。

もちろん、当時のエンジニアたちは、その場で音を仕上げる技術に長けていたと思います。レコーディング最中にレコードチャンネルにチャンネルストリップを有効にしてレコードしていた方も多かったと思います。

しかし、柔軟性を求める制作現場の要望により、レコードされる信号はなるべくドライで、後の ポストプロダクションで音を作り込んでいく、そんな制作スタイルがどんどん確立されていきます。

1979年 SSL 4000E 登場

おそらく、日本国内に現存する SSL の中でも 4000E は一番多いのではないかと思います。4000G もありますが、1987年登場です。EQ カーブ が違うため G より E のほうが人気で、色合いも 4000E のほうが個人的に好き。ただ、G はマスターコンプが大人気。

この頃になると、オートメーションやトータルリコール機能が付き、ポストプロダクションの重要性が増します。つまり、後々の編集に自由度が増す、ドライデータを録音する現場が増えてきたということです。

コンソールに標準装備されるチャンネルストリップはレコーディング中にもある程度は使われることはありましたが、後のポストプロダクションに大いに利用されるように、Filter、Dynamics、EQ などは過激な音作りに利用されていきます。

また、有名な話として、Cue 専用の Talkback Mic 回線には過度なコンプレッションが採用されていたのですが、その回線経由で聞こえるドラムの音が非常によく、ハードコンプレッションとゲートリバーブの元ネタになったというエピソードもあります。

デジタルレコーダーの登場

デジタルデータは劣化しない (磁気テープは劣化する) という特性上、更にレコードデータはアナログ機材のエフェクトを通ることが減ってきました。後々のポストプロダクションに更に後掛けエフェクトは加速していきます。

1983年 3324、89年 3348 登場

磁気テープの登場により、1980年代半ばあたりからデジタルレコーディングが普及し始めます。ちなみに CD は 1982年 10月1日 に世界初の CD 作品が発売されています。

そしてデジタルレコーディングのスタンダード、Sony PCM 3348 が 1989年 にリリースされます。彼のおかけで業界はデジタルレコーディングへの転換が進みました。

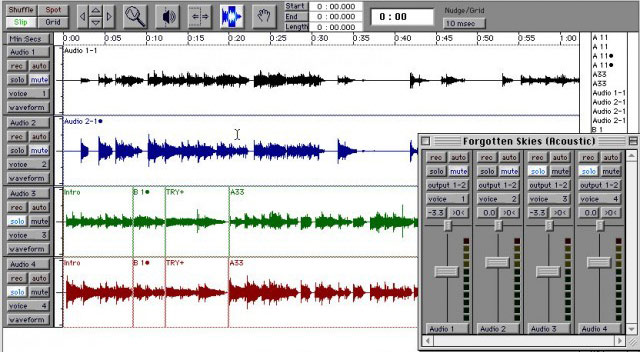

Pro Tools の登場

1984年時点で、Pro Tools の全身、Sound Designer は既に登場していますが、まだ、スタジオにはコンピューターオーディオは導入されません。当時のシンセサイザー・マニピュレーターの方々はコンピューターオーディオに詳しく、導入を始めた人も少なくはなかったと聞きました。

しかし、3348 のサポート終了と共に、Pro Tools は爆発的に普及。プロスタジオでは 100% の普及率だったと聞きます。ついに DAW 上で プラグインを操作する時代が到来しました。今でも業務用スタジオは Pro Tools です。それ以外の DAW の場合、商業プロスタジオとは言えないかも。

1996年には Steinberg が VST を発表し、同年、Antares が Auto-tune を発表します。プラグイン時代到来の幕開けでした。

TDM プラグインはモニターにリアルタイムにエフェクトが掛けられるようになりました。プラグインにはレイテンシーがありますが、徐々に徐々にアナログエフェクトと同じ様に動作するために メーカーは努力し、現代ではモニター側ではほとんどアナログモニターセクションと同等の感覚でプラグインを使用できます。

DAW とコンソールの類似性

先程から インライン について、ちょっと酸っぱく説明してきました。

なぜかと言うと、現代の DAW の大部分はこのインラインコンソールの基本設計を踏まえているからです。

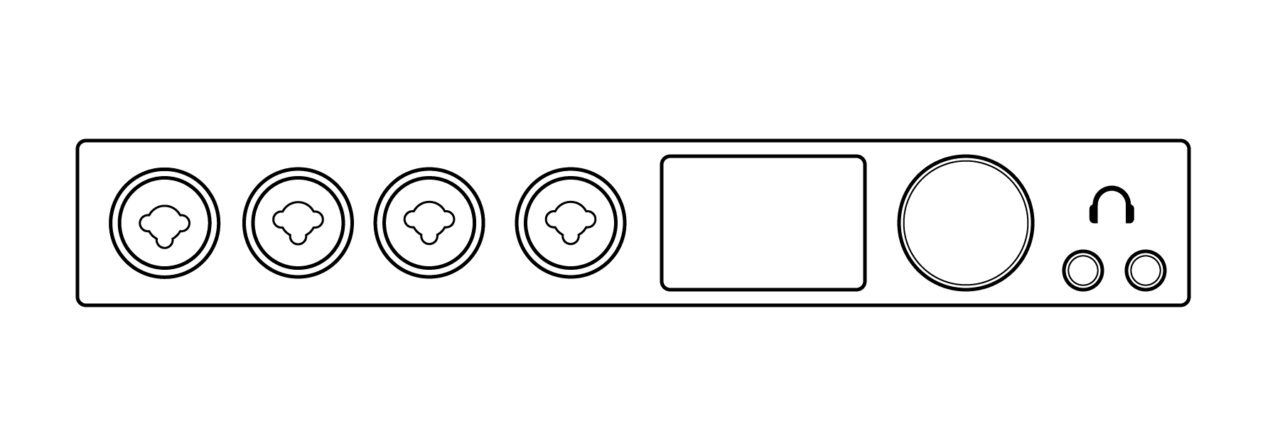

現在の皆さんのよくある DTM の環境を思い浮かべると、最低限のマイクとマイクプリ付きのオーディオインターフェイス、コンピュータ、DAW、スピーカ、またはヘッドフォンで構成されます。

コンソールにおける Preamp 部のみが有効になっており、そのままレコーダ (つまり DAW) に信号が記録され、モニターへの出力アウトプットに信号が流れる、という構造をしています。基本的にインラインのインプットセクションを構成する。モニター出力はコンソールにおけるマスターセクション部分の機能と解釈できる。

普通に信号を扱う分には、ドライシグナルしかレコードしません。現在はオフライン編集、ノンリニア編集が大前提となっているので、エフェクトは後で掛けるもの、という間違った 固定概念 が浸透してしまっています。

DAW はモニターセクションしかない

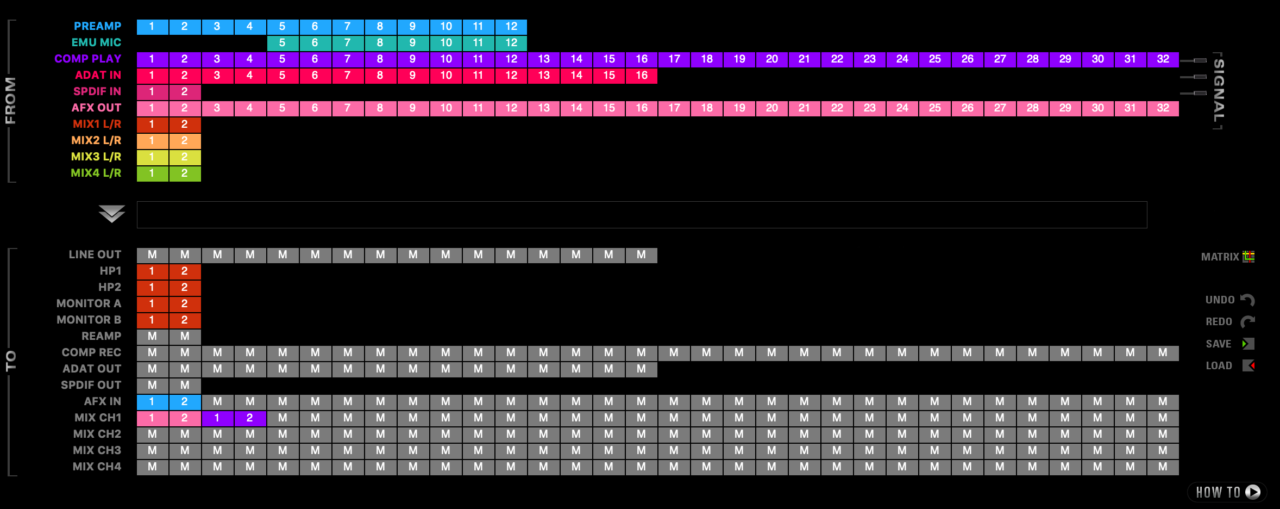

ご存知の通り、DAW 自体がレコーダの役割を果たしているので、DAW は インプットセクションがなく、モニターセクションしかない。インプットセクションを補うのは各インターフェイスのソフトウェアコントロールに該当する。

例えば UAD のコンソールソフトはここで従来のコンソールインプットセクションの項目を操作する。HA → Insert で外部エフェクトにアクセスすることをヴィジュアル的にも表示している。

大型コンソールの基本的な構造概念がわかる人にとっては非常に直感的なのだか、現代にはスタジオ勤務がある人以外、正直こんなの直感的には理解できない可能性のほうが高い。特にスプリット型は見たことある人は多いだろうが、インラインコンソールはプライベートな環境でしか普通はお目にかかれない。

インプットセクションはインターフェイス側

インターフェイスにはコントロール用のソフトウェアが使えます。ついていないものはアナログのツマミから以外、コントロールできませんが、この入力コントロール部が、DAW におけるインプットセクション です。

「ははん、なるほど、理解してきたぞ。」

と、読者全員が思っていることを願います。つまり各メーカーはこのインプットセクションにインラインコンソールに備わっていた、各エフェクトを実装したい、と思うわけです。そこで、各メーカー DSP エフェクト等 を開発しているわけ。

DSP (FPGA 含む) の概念

Pro Tools HDX の DSP は完全にモニター用途向け、というか DAW 側の プラグイン DSP しか作用しないので完全に省きますが、よくあるデバイス内部の DSP というは インプットセクションにおけるエフェクター なのである。

つまり、デバイス自体に付属する DSP エフェクトは DAW Plug-ins と同じではない。同じ用に考えてはいけない。これ重要。

内部 DSP 処理の鉄則

インターフェイス内部の DSP 処理の信号はプラグインと同じ様に考えてはいけない。インラインコンソールにおけるインプットセクションのエフェクトと同義で考えないといけない。

そうしないと、何故インターフェイスには内蔵 DSP エフェクトが実装されているのか、何故、内蔵 DSP エフェクトが必要なのか、が理解できない。これらのエフェクトの根底にあるのはインラインコンソールのインプットセクションである。

補足として、内蔵 DSP はモニター用途に使うのかレコード用途に使うのかの選択はユーザー側で指定できるので、少しだけ自由度がある。

ただし UAD-2 プラグインの場合、インプットセクションにソフトウェアコンソールを介してプラグインを動かしてる、ので非常に認識が曖昧になりやすく、よく引き合いに出される Antelope Audio の AFX も AFX2DAW というブリッジプラグインが存在するために非常にややこしくなる。とにかく、プラグインは DAW のモニター側のモノとして話す。

内部 DSP 処理はプラグインと同列ではない

非常に大切なポイントです。内部 DSP 処理のエフェクトはアナログ機材より自由度が高いですが、プラグインのような DAW と連携するものではありません。オートメーションも掛けないし、DAW のセッション情報にセットされるようなものでもありません。明らかに別モノと認識する必要があります。

その最たるものの一つとして、Antelope Audio の AFX がある。製品自体がコンソールのインプットセクションとモニターセクションの役目まで果たしてしまうので、インラインコンソールの前提を知らない人からしたら、理解が難しい。

Universal Audio の Apollo 製品群の場合、インプットセクションはコンソールソフトウェア上で、モニターセクションは DAW 上のプラグインに基本は任せているので、現在のユーザーは理解が難しいかもしれない。

AFX は FPGA で処理されるが、この FPGA はソフトウェアエフェクトとは全く異なる概念、構造、処理体系を持つ、ハードウェアエフェクトだ。もちろんプラグインのように使用することも可能であるが、基本はインラインコンソールの Insert Section と似ている。またハードウェアインサートが利用できるため、モニター用エフェクトとしても DAW 上で利用できてしまうから難易度が高い。

これを DAW と連携してしようする場合は、インラインコンソールと DAW を連携して使用したことのある層ではないと、初めは非常に難解に思うだろし、なぜこのような設計なのか理解に苦しむだろう。それは単純に言うとスタジオワークフローを知らないだけである。

また、Steinberg のインターフェイスでは dspMixFX というソフトウェアから内部 DSP を使用したエフェクトが利用できる。これらは内蔵 DSP 処理であるが、UAD-2 のようなプラグインを処理させるような構造は持たない。ここまでの説明でこの dspMixFX は完全にインプットセクションの機能を補うために、開発設計されていることがわかる。

何故、アナログ機材が必要なのか

やっと核心へとたどり着いた。

必要あるのかこの説明は? というような長い序章を終え、核心を話すと理解が深まる。もう読者の大体は感づいていると思うが、

現代にアナログ機材が必要なのは、インプットセクション なのだ。

ほとんどのユーザーがアナログ機材を通してミックスするとかマスタリングする用途を説明しているが、大前提はここ なんだ。

声を大にして言いたい。違うわ、と。プラグインがアナログの延長にいるんだよ。この認識がいつの間にか曖昧になっている。

全部違うというと、こいつ何もわかってねぇやつって言われちゃいますが、とにかく、現代のメーカーがユーザーに対して、何故、内部 DSP 製品を提供しているのかを、ちょっと考えるだけで、

「ああ、これは足りないインプットセクションの機能を補うためか」

と理解できなければ本来はいけないし、それくらいの知識を有していないといけない、とは思う。特に最近は中堅クラスのインターフェイスで内部 FX の需要が増えている。いろんなメーカーがソフトウェアプラグインや DSP 製品を出しているので、買い物する前にたくさん調べて失敗しない準備も必要だと思う。

メーカーは闇雲に機能を提供しているわけではない。いろいろな機能があるけど、一つ一つにちゃんとしたバックグランドがある。

アナログ機材のあるべき姿とは

当たり前ですが、音質とか利便性とかそこで、アナログ機材を買うべきではなく、用途や背景で選ぶべき。アナログ機材が音が良いとは限りません。

例えば自分は歌い手であるので、マイクとプリアンプ (できればチャンネルストリップ) にはこだわって揃えるとか、ギタリストなので足元を充実させて、揃えるとか。作家であれば、いい音で聞きたいということであれば、スピーカーとかインターフェイスの方が大事だと思うし、ミックスで使いたいのであれば、ミックスで使用する前提のアナログ機材 を使うべきだとは思います。用途を絞ることが結構大事。後から編集で、ではなく、入り口からこだわるというのがアナログの醍醐味である。

エンジニアであれば、録りの段階でアナログ機材を使いたいことが多いと思うので、録りに特化したアナログ機材を揃えることが大事だと思います。レコーディングしてしまえば後はプラグインでもいいのではないでしょうか。だってアナログ機材を使ってレコーディングしたのですから。録りの段階で追い込むことが個人的にはエンジニアっぽいとは思います。

アナログ信号に対して、特殊な処理をするエフェクターはまず存在しませんが、デジタルデータに変換された後であれば、非常に過激な処理もプラグイン上で可能になります。要は、アナログ信号に対してエフェクトしたいのか、データ上でエフェクトしたいのか、を考えると非常にスマートな選択が可能かと思います。

実機には答えが少ない分、正解に到達する時間は極めて速いです。ただし、実機の選択を間違えると、正解にはたどり着けない可能性があります。その点デジタルエフェクトはある程度なんでも対応できるという利点もあります。

ぶっちゃけ言えば、いいところも悪いところも両方愛せない とアナログの良さは理解できないと思います。

プラグインのあるべき姿

価格。これに尽きる。実機買えないもん。

それとは別に、プラグインとはモニターセクションのエフェクトなんだ、と言うことを完全に理解してほしい。

ソフトウェア音源が既に実際のレコーディングを駆逐している現代では、プラグインで音を作ること、特に実機エミュレーションを使用することに対する感覚が非常に難しい塩梅に来ています。

例えば、シンセサイザーモデリングはその、シンセサイザーにしか出せなかった音を求めている人が多いと思います。その感覚を EQ であったりコンプレッサーのエミュレーションにも持ち込んでください。

EQ のプラグインで SSL のチャンネルストリップ使っているんだろうって単純に、SSL が使いやすいからなんです。日本のエンジニアさんで SSL 以外で育った人は NEVE V Series の人くらいじゃないですかね。

ですから、実機プラグインを買うときは実機を知っている、触ったことある前提で買うほうが良いとは思います。プラグインはプラグインでしか得られない効果を求めるほうが圧倒的に良いとは思います。

結局モデリングというのは実機そのものを求めているわけではなく、実機と同じような操作性や、感覚を求めているのがエンジニアで、個人的にモデリング元とヴィジュアルが全く違うエミュレーションプラグインが非常に使いづらい。だから見た目とか大事。直感的にツマミにアクセスできるかできないかは非常に大切。

アナログ実機とプラグインの選択

実機に求める部分

実機には特定のパラメータが割り振られていたり、周波数が決まっていたり、各パラメータの値が固定になっていることが、多いです。これが実機に求められる部分です。

個人的に好きなのが API 550B です。この EQ ポイントが好き。

特定の楽器には必ず、行う EQ があるエンジニアの場合、アナログ機材をもう録りの段階で掛けたいのです。だからアナログ機材使いたいんです。モニターに EQ してもいいですが、毎回 EQ 用意して噛ますの面倒じゃないですか? この感覚は実機をスタジオで利用してきた人しかわからないとは思いますが…

とりあえず、録りでドライで録ったものをアナログ出しして、再度コンプレッサーや EQ に送ることは、レコーディング現場でできなかったアナログ処理を後々に行っているに過ぎない、と解釈すると非常に納得いくかと思います。

なるほど、エンジニア達がアナログ機材に求める部分とはそこなんだ、と。

あと、ハッタリに使えます。いっぱい機材持ってるだけですごい人って感じするでしょ? あと安心への先行投資ですかね? スタジオにビンテージマイクと 1073 と 1176 が置いてあるだけで、おそらくレンタルされる率が 100% 伸びます。

プラグインのあるべき姿

基本は実機にはない処理を求めたい時に使いましょう。

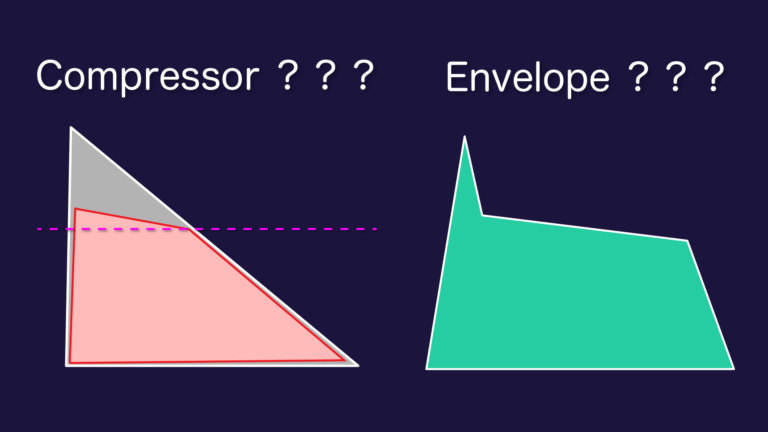

例えば、素早い Attack Speed を求めたい場合、0ms が可能なコンプレッサーがありますし、実機の PEQ では再現できない、ナローな Q 設定も可能です。

あとは、実機を買えない時にモデリング買いましょう。プラグインのほうが実機より良い場合も非常に多いです。そういう時代ですから。

さらに実機とプラグインの堺が曖昧に。

知っている人は知っているだろうが、McDSP がアナログプラグインを開発しました。その名もAnalog Proseccing Box 略して APB-16。

Programable Analog Processer を可能にしている製品が出ました。

アナログ回路をプログラム制御するよっていうハイブリッド製品で、値段が思ったよりかなり高い。しかし、IoT が進む現代、スマフォ端末からプリセットを呼び出すような、アナログ機材が今後は増えてくる可能性が高い。

選択とは解釈である

DAW における、インプットセクションにアナログを使用することが一番意味があると思います。もちろん、コンソールがあるスタジオでレコーディングできれば、録りの段階である程度のプロセッシングしてしまったほうが、後々の処理は楽です。

ただし、現代はそんな現場が減りつつあり、ほとんどありません。だから DSP 製品で補おうとするメーカー達の努力があります。これはプラグインではないので、どちらかといえば、ハードウェア上で制御するエフェクト と考えるべきです。

非常にエンジニアライクにエフェクトについて設計されているのが、Antelope Audio の AFX。製品はエンジニア寄りの設計がされている。FPGA FX のハードウェアインサート

インプットセクションもデジタルに置き換えたいと考えているのが、Universal Audio の Unison テクノロジー等であろう。デバイス内部で完結するエフェクトはプラグインではない。プラグインとは DAW 上のプラグインインサートに使用するもので、それ以外はプラグインとは言わない。

すべてのデジタルエフェクトをプラグインと捉えるから今まで漠然とアナログ機材への理解に深みがなかった人たちが多いと思いますが、設計の背景を説明させられると、アナログを使っている人の感覚や利点、欠点までもある程度は理解できたと思います。あくまでここで語っていることは私が勝手に想像していることでもありますが…。

理解してほしいのは プラグインはあくまでも DAW 上のモニター用エフェクト である。それ以外はプラグインではないし呼ばないほうがいい。そうしないと色々ごちゃまぜになって、プラグインだから DAW 上で操作できると勘違いするし、アナログ機材の必要性に関してイマイチ理解できない感覚に陥るはずだ。

最終的に理解して欲しいのは、実機はインプットセクションとモニターセクション両方に利用できる のに対して、プラグインはモニターセクションだけにしか作用できない。その制限を越えるために各メーカーは内蔵 DSP エフェクトでその制限を DAW から独立せざるを得ない状況で構築してる。見方を変えるとプラグインよりアナログの方が実は自由度が高い。

アナログ機材を使う理由というのは、どちらかというと、まだプラグインでは再現できない、ワークフローがあるからこそ、利用されており、インプットセクションにこそ、まだまだアナログ機材は必要であったり、そこにはオカルトと言われても仕方のない不思議な魅力があります。