トランジェントとインパルスの近似性質【有料分あり】

なぜ、トランジェントについて語ろうと思ったか、については以下、

での IR 制作が発端となっています。独自に IR を研究、制作するにつれて IR や FIR フィルターの基礎知識を学び直した結果、Transient 制御に関連する仮説や推論が出来上がったためです。

今回の内容は正直、音楽制作の話、というレベルを超えて、個人的な「音楽的な視点を内包するトランジェント制御に関する考察論文」みたいな内容を以下に記載します。音楽の話を確認しに来たつもりがよくわからない物理の話をされて、読みづらいし、つまらないし、何を言っているの理解が難しい、もしくは「全く何を言っているのかわからない」の状態の人も多いと思います。おそらく半数以上の方、九割以上の方が最後まで読むことができないと思います。

それでいいのです。この内容はただの個人的な研究論文を公開する、という内容に等しく、非常に上級者向けというか、業務的に音を扱っている人や、本気で理解しようと思う一部の方のみが理解できればいい内容となります。別に同意して貰う必要はありません、客観的な事象と内容を記載しているだけです。

前半は基礎的な知識を語るだけで、正直、一回だけ読んでも理解できない内容でしょう。もちろん元々のバックグランドの知識がある人にとっては、読むだけ蛇足になります。

もちろん、ネット上の情報に対するアンチテーゼ的な内容も多分に含まれます。

トランジェントの定義

トランジェント (Transient) の定義というものは現在でも話をする人それぞれで曖昧です。

色々な人が「トランジェント (Transient)」という言葉を発するようになりましたが、全く要領を得ない言葉ですよね。「アタックとは違う」と説明されますが、具体的な例を厳密に紹介して説明しているものは日本語情報で存在しないのではないか、と思うほど Transient の言葉の定義を明確に説明している人はいません。

もちろん、工学的な書籍でも研究者によって幅広い区別があるので音楽的には曖昧な言葉で特に支障はありません。プラグインでもその検知の感じから各々特徴があったり、別に普通に会話する部分において Transient という名称になんら意味はありません。重要なのは自分がどうしかいか、だけです。

ただし、ここでは共通の議題について互いに認識をすり合わせる、という意味で定義づけは重要になります。これが面倒。

ネット上で得られる情報で定義付けを厳密にしているのはここくらいでしょうし、普段の会話での定義付けにそこまでの意味はありません。この場所では「共通の話をしているよ」っていう前提条件を作りたくて言葉の定義をするのであって、普段の会話でそこまで厳密に定義する必要性は薄い、ただの会話なら。

もちろん、オーディオ的な Transient の意味は「電圧または負荷の突然の変化により回路内で発生する一時的な発振」と定義されたり、あとは「音声波形のピークを形成するエネルギーバースト」とか「波形先端の高振幅で持続時間の短い音」とか。

私個人が人に説明するときに簡単に利用する例えとして「Transient を制御できるプラグイン、またはハードウェアが制御できるインパルス波形要素」というような言葉の定義ができます。ここでのインパルスは突発的、衝動的な信号という意味で、私はこれ以外で表現ができません。

「アタックとは違う」とよく言われますが、明確にアタック音と違うと説明が上記の言葉以外で説明が私はできません。Transient を捉える構造がプラグインやハードウェアによって異なるとは思いますが、厳密な意味としては「僕たちが制御できるインパルス要素を有する波形」でいいでしょう。

私と議論する時以外に Transient の定義はどうでもいいので、この話を私とリアルで議論する以外はどうでもいい話であることを念押ししておきます。

もちろん、英語で Transient について調べると普通にたくさんの情報が出てきます。iZotope の公式では非常に初歩的な Transient についての解説があります。コンプで制御しようね、っていう解説までみられるので非常に有用です。

What is a Transient in Audio Production?

もちろん他にも Transient について触れている内容の記事は簡単に見つけることができます。

What Are Transients & Why Do They Matter to Your Mix?

しかし、これらの解説を読んでも「Transient は重要な要素だよ」とは教えてくれますが、具体的にどのような効果をトランジェント制御で得られるか、みたいな話はほとんどアタック制御と変わらない話しか見えてきません。

当たり前に、Transient が豊富であればダイナミクスを強調できるよ、とか、Transient を引っ込めて楽曲やジャンルによりそうミックスを心がけようとか、制御を誤れば、歪みしか産まないし、再生機のトランジェント特性ゆえの再生精度の低下や、デジタルデータ的に問題が発生したり、プリエコーの問題が指摘されたり、と非常に当たり前のことしか見えてきません。

もちろん、具体的な用途は各自で、という話ではあるのですが、あまりにも Transient に対する視点が主観的すぎる内容しか得られないのが自分は非常にもどかしく、私自身が長年研究してきた部分でもあります。

またはプラグインベンダー側でそれはもう念入りに Transient 検知のアルゴリズムを作っていると思うので、我々が厳密な Transient の定義みたいなものは、実はツールを使うときに気にしなくていいのです。プラグインを信じるだけです。もちろん、ちゃんと視聴して変な Detector を見逃さない集中力も必要だと思います。

ここでのトランジェントの話と定義

そして、ここでの Transient を指す具体的な例は「初期トランジェント」が主となります。

そして、この「初期トランジェント」について語っている日本語の情報はネットにおそらく存在していません。英語の資料には「Initial Transients」なる単語が出てくることがありますが、日本のネット上で「初期トランジェント」という単語を目にした経験は実は自分の発言以外でありません。

もしかすると私の知らない日本語の書籍資料等では頻出している可能性がありますが、自分は一応音楽業界にもう十数年いますが一度も聞いたことがないので多分誰も口にしていない言葉でしょう。

現在の Digital Audio はほとんど電気の話なので、実はこの初期トランジェントは電気的な特性を理解していると、非常に理解は速いです。というのも、ほとんどが物理の話なので Impulse Response、過渡応答についての知識がある場合は非常に優位に働くでしょう。

初期 トランジェント とは

残念ながら「Initial Transient」に関する情報は海外の論文などでは普通に語り尽くされている定義上の言葉で、初期トランジェントは 聴覚的な質に非常に重要である ことが示される、もしくは聴覚知覚に非常に関連するものであると結論づけている論文がたくさん出てきます。

特に音響心理学では「音のアタック特性が音楽楽器の人間による認識に重要な役割を果たす」と言い切っています。(Transient とは言ってはないがアタック特性とは Initial Transient も内包すると考えて良いだろう)

もちろん、海外の有名エンジニアがそれについて知識があるか、と言われたら全員がそうでもないでしょうし、初期トランジェントの話は実はあまりミックス的な視点で簡単に利用できるものではなく、演奏者や録音時のキャプチャに対する心構え的な要素が強いです。もちろん、論文が割りと簡単に見つかる関係上、海外の大学ではそれとなく教える人はいることは明白でしょう。

しかしながら「初期トランジェントが聴覚的な指標にとって重要である」という言葉を日本語の情報で得られたことは残念ながら私は経験がありません。

もちろん、詳しい楽器解析の翻訳本などを探せば日本語でも記載があるとは思いますが、残念ながら私はこの業界で働いていて日本の方から初期トランジェントなる言葉を聞いたことがないのです。日本ではアタックという言葉が一般的なのかもしれません。あともしかしたらアタックに関する意識が低いのかもしれません。

ちなみに翻訳記事ですが普通に有能な記事はそこら中にあります。

ラウドネスプロセシングのベストプラクティス (外部) (Jie Yang)

日本の方から初期トランジェントについて聞いたことはありませんが「トランジェントが重要だ」と言う人は増えました。ただ「なぜ重要なのか」を具体的に説明した人を知りませんし、Transient を制御し結果を論理的に予測する思考やメソッド、セオリーなどを説明している人は皆無です。アタックという言葉で説明している人や秘密にしているだけかもしれませんが。

皆「増やす、減らす」ということしか言えません、もちろん、よくある Transient Designer は増減しか制御できません。つまり、頭でしっかり考えなければ体系的な「制御方法」はなかなか説明できません。もちろん、初期トランジェントを制御したからといってすべてが上手くいくわけではありませんし、重要なのはサウンドデザイン的な視点であり、初期トランジェントを闇雲に制御したからといって楽曲が自分の思い描く方向へ変化することもほとんど無いと思います。

ほとんどが演奏や認識に於いて重要であってミックスで最重要か、と言われると「別にそうでもない」と思う、けど、知らないとそのミックスの全体のパッケージ力みたいなものが薄れるかもしれないし、キリがない。

ちなみに過去に「意味もなくトランジェント制御を行うと楽曲が崩壊するよ」という話はしております。必ずしも Transient がトーンの周波数に直接依存するわけではなく、高度な非周期成分と、その音の倍音成分よりも大きな高周波が含まれていることが多いためです。

もちろん、肌感覚で分かっている人はいると思いますが、あらゆる媒体で日本語で説明されているものを見たことがないのは皆さんも同意してくれると思います。

では、私と一緒に「初期トランジェント」について考えてみましょう。

少し難しい 初期トランジェント の話

言葉の定義的には「ある波形フェーズの最初の Impluse 要素を含む波形」とでもいいましょうか。これは私が以下説明するための方便で、初期トランジェントを私の説明で理解するための言い方で万人の定義ではありません。

これを理解するために私達は「Impluse」の基礎知識が必須になってきます。

少々蛇足になりますが、初期トランジェントに着目した研究資料はかなり昔から存在します。手元にある資料によると…

とあります。

また 1979 年の研究論文では…

この用に初期トランジェントとその後のアタックを明確に分けるような記述が論文で出てきます。もちろんこの情報は全てに応用できるものではありません。主にリード楽器、金管管楽器、弦楽器の相互作用に関連する事象として説明され、ほとんどが楽器の音がどの用に発声し決まるのか、的な視点の研究が多く、ミックスに利用できるような記述はありません。

インパルスの話

IR、Impulse Response という言葉を聞いたことがある人は多いと思います。

でも「つまり IR ってなによ」的な人は多いと思います。

この IR、もとい「インパルス」について「FIR」という単語を使って説明していきたいと思います。

おそらくここで八割以上の方が脱落すると思いますが、ついてこれる人だけついてきてください。もしくはこの 3 のセクションはすべて読み飛ばしてもいいと思います。

別に難しい内容ではないのですが、だるい話なので離脱者が増えるだろうと予測しています。

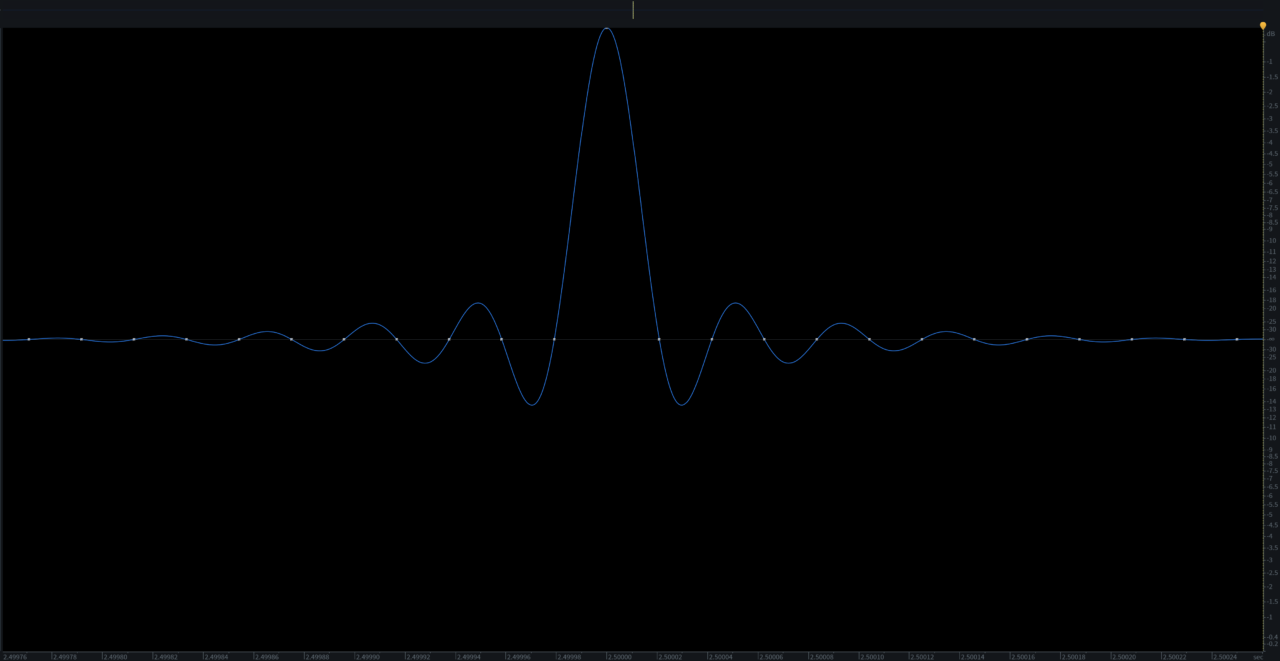

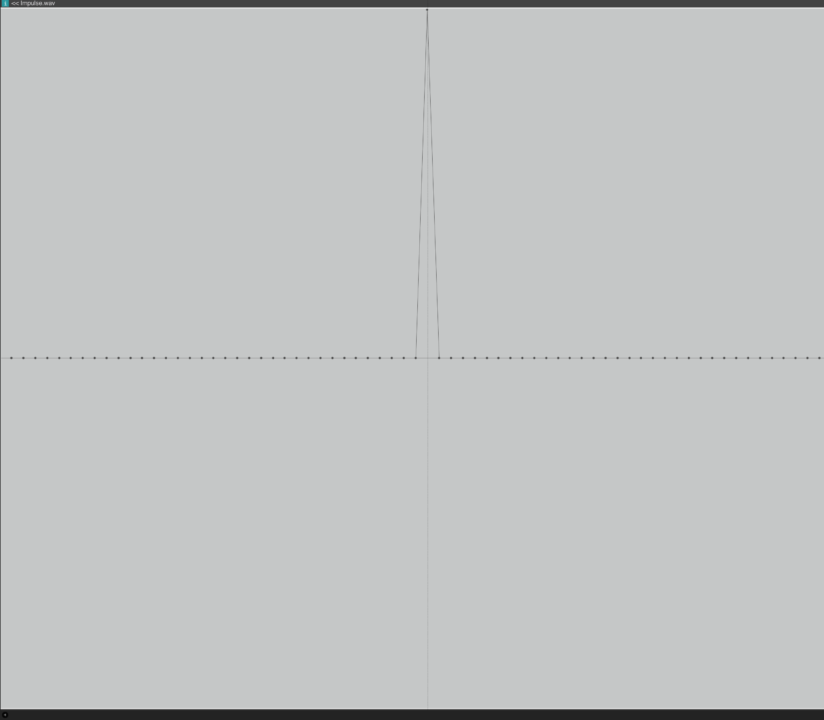

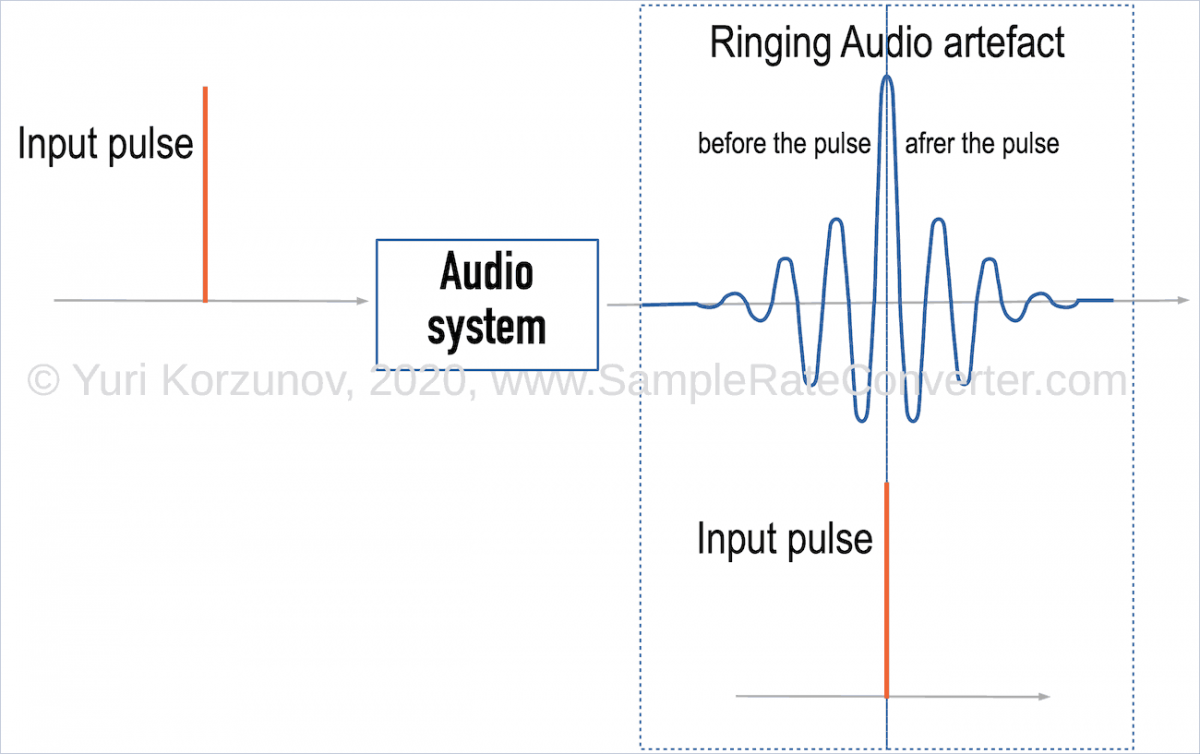

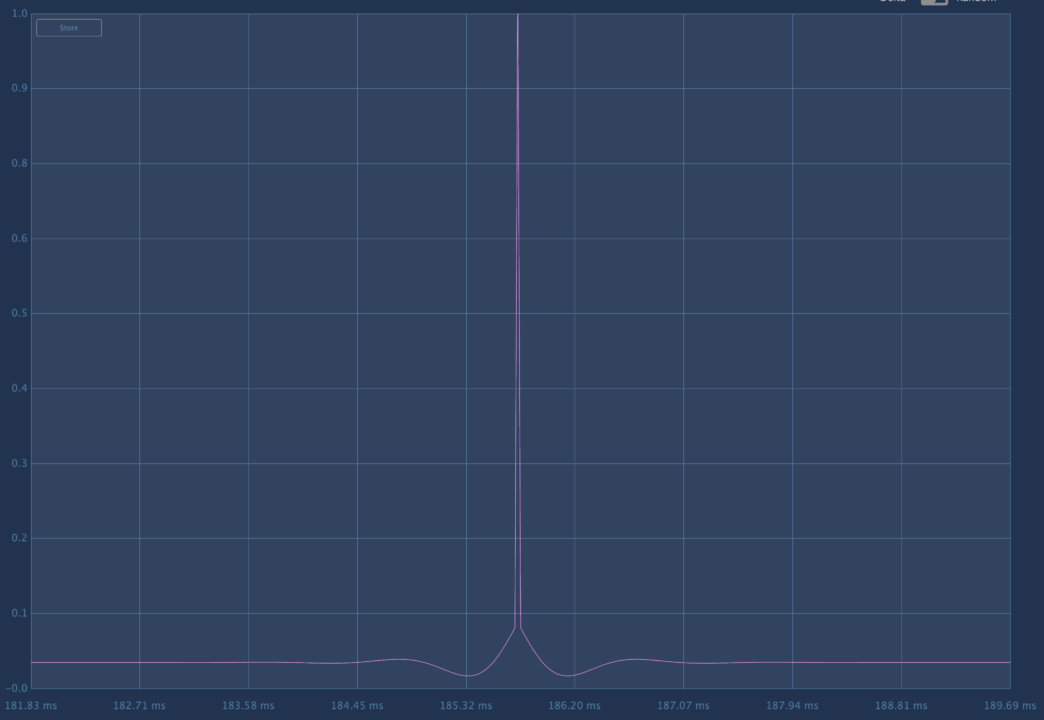

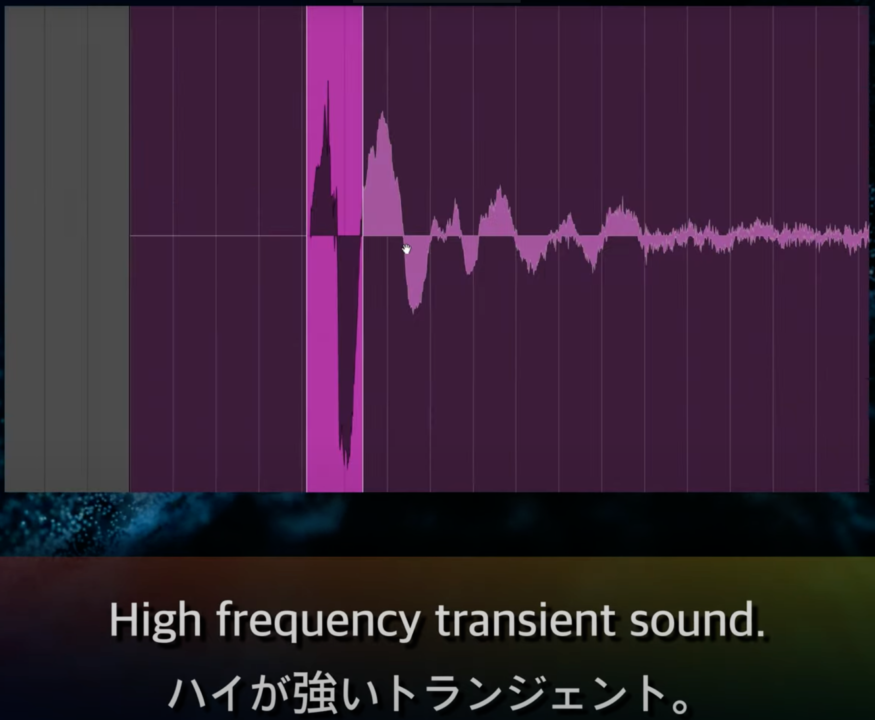

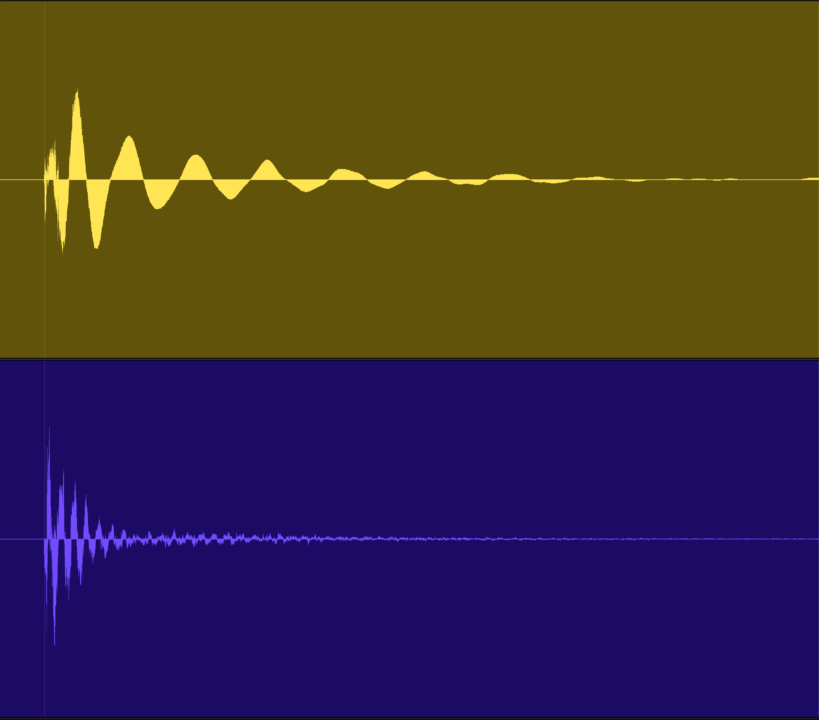

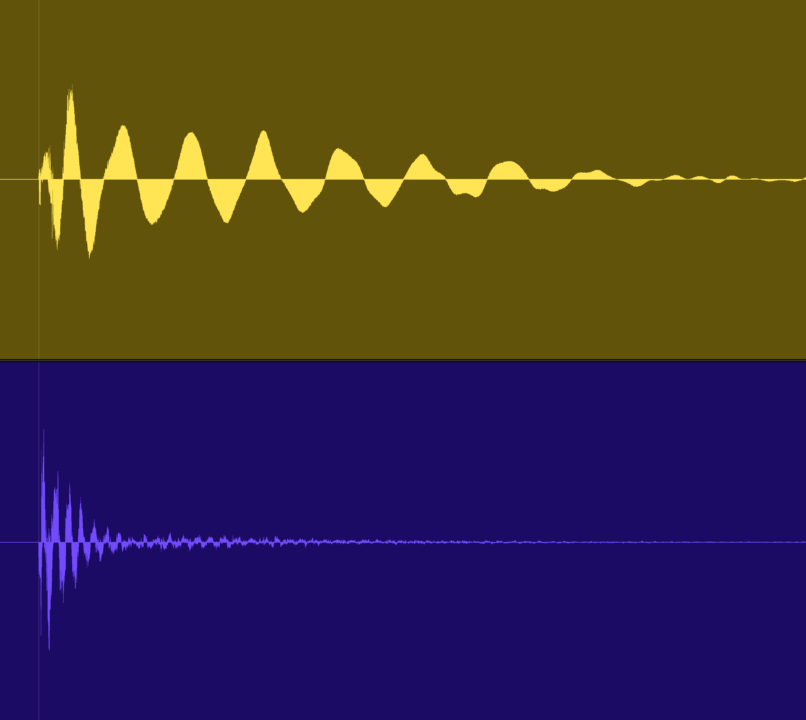

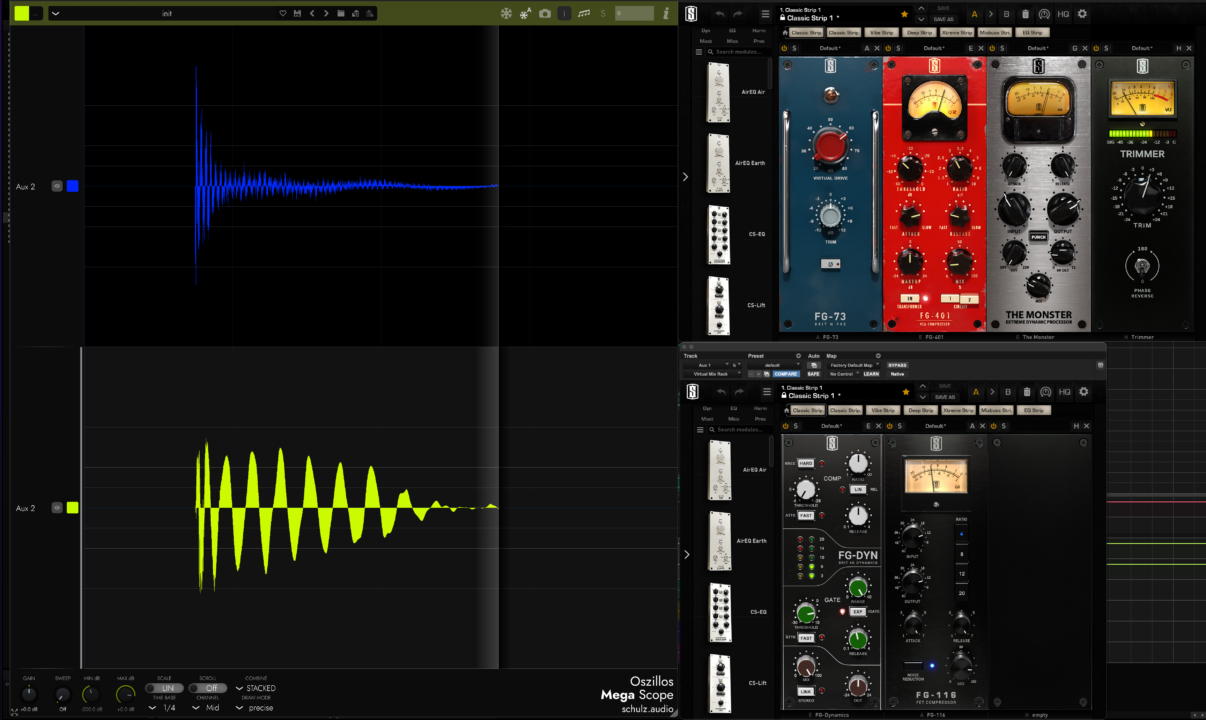

インパルスとはこういう波形を言います。

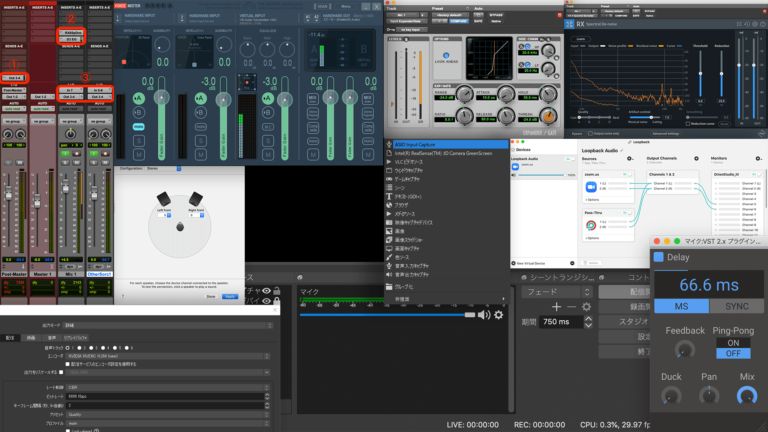

iZotope の RX はサンプルデータの表示ではなく復元波形を表示するので別のソフトを使ってみます。

こういうデータ波形がインパルスです。0 Point to Maximum Point to 0 Point 波形です。

0 は電圧 0 V なので無音ですが、1 サンプルだけ最大値を示している波形です。

このインパルス、非常に大事な特性を持っています。それは…

インパルスとは「すべての周波数成分を持つ波形」なのです。

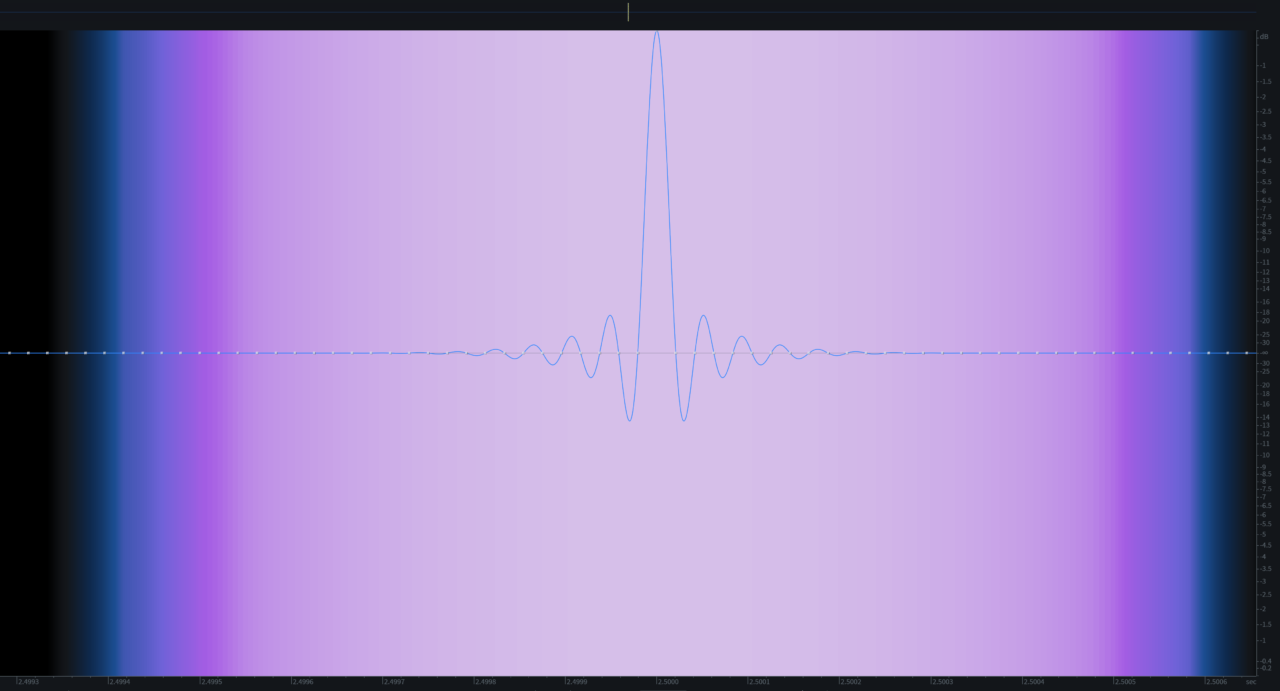

サンプルレート、ナイキスト周波数で表現できるすべての周波数の合体波形、集合波形なのです。この話を具体的に説明すると積分 (デルタ関数の面積) の話になるのでここでは割愛します。

この信号の場合、48 kHz のサンプルレートなので 24 kHz までの音が瞬間的にすべて内包されています。(同じ振幅で無限に周波数が重なると、中央だけが加算されて無限のエネルギーになり、それ以外は干渉して 0 となる) これがインパルス波形の重要な特性です。全ての周波数成分を持っている、すべての周波数成分の集合体がインパルスとなります。

この特性を利用することで、IR (インパルスレスポンス) を利用することができます。簡単に言うとすべての周波数成分を内包する信号を通過させてその変化を観測できれば、その信号通過における周波数特性を理論上、測定できるわけです。

意味わかるよね?

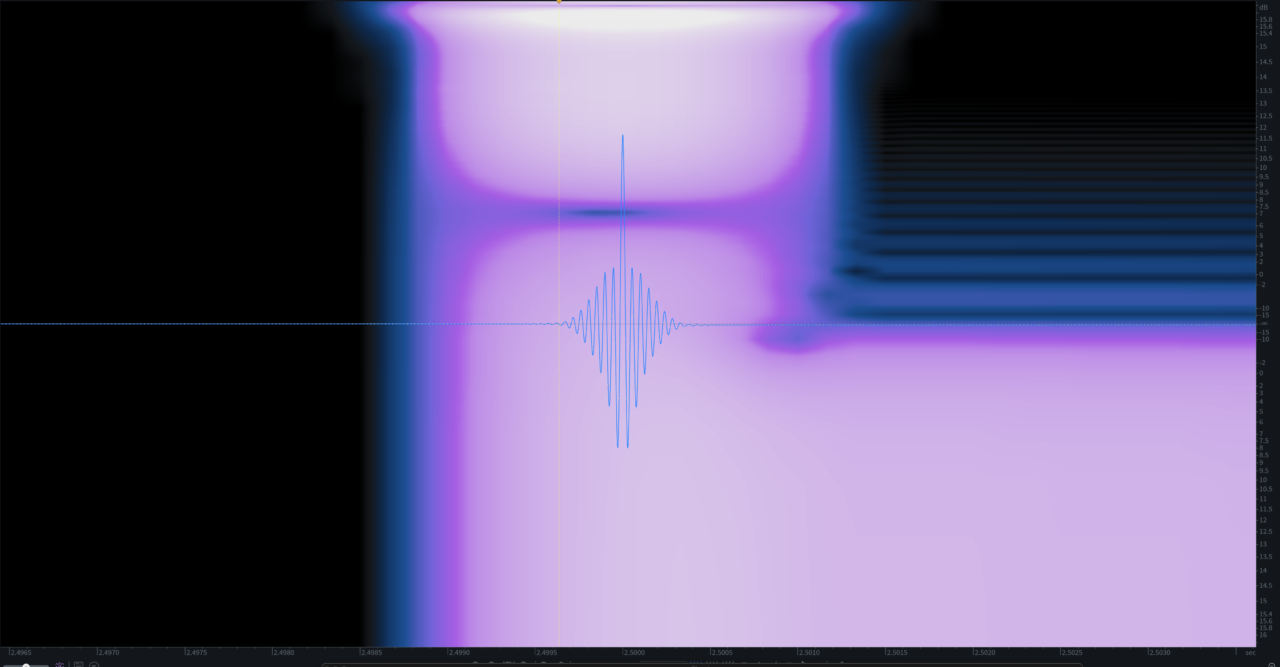

IR (Impulse Response) の話

もちろん、ループに利用するケーブや AD/DA 等の特性に必ず引っ張られるので厳密な IR はなかなか再現は難しい。しかし、現代では実用レベルでは問題がないと思われる。

下の伸びている周波数は DC の具合が表示されている。

Plugin Doctor を使わなくても周波数特性の測定はできますが、面倒ですよね、瞬間かつ継続的に IR を測定し続けてくれるのが Plugin Doctor の Linear Analysis のモードです。

つまり IR を利用すれば限りなく自分のアナログ機材の周波数特性をキャプチャでき、それを利用すれば周波数特性をいつでも利用できるということなのだ。もちろん、ここでは周波数特性のみをキャプチャしていることをお忘れなく。

IR の読み込みは非常に簡単だ IR Loader を利用すればいいだけ。例えば以下を利用することが自分多い。

もちろん、この特性を利用したのが Convolution IR Reverb や Guitar Cabinet IR だ。IR Reverb や Cabinet IR は周波数特性 (と Steady State 応答、定常状態に戻ること) を理論的には完全に擬似的に表現できるという代物で、実際の部屋なりやアンプ挙動を正確に再現するものではない。現状、世の中のアンプシミュレーターはスピーカー挙動をリアルタイムで再現するようなものは私の知る限り知らないので、アンプ録音とアンプシミュレーターでまだまだ生アンプが強いと言われます。が、利用するエンジニアの腕次第だとは思いますがね。

今に Machine Learning とか Deep Learning でアンプ挙動を入力信号から再現するなんてものができるかもね?

めちゃくちゃ大変な作業と計算が必要そうだけど。

スピーカー挙動の実情は IR のほうが良い場合もあったりするため、全ては時と場合と適材適所で IR を利用したほうが生アンプより特性が良い、なんてこともあるので、既にシミュレーターは生アンプに勝てない、というのはポストプロダクション的な視点から言うと、そうでもない。

それた話はさておき、重要なことは「インパルスはすべての周波数成分を内包する」という言葉だ。

ここでは上級者向けにもう少しこのインパルスについて解説していく。もちろん読み飛ばしたい人は無視で良いが、深い深い理解のための基礎知識であるため、理解することをオススメはしておく。

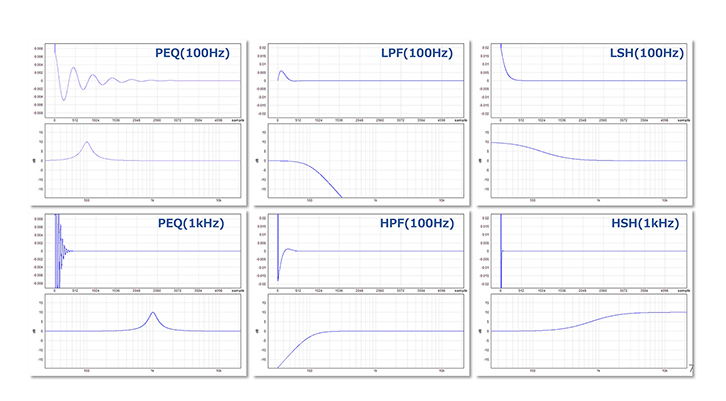

FIR (Finite Impulse Response) の話

Impulse を理解して、IR の基礎概論というか基礎理論を理解したら、FIR も理解すべきなのです。

僕らのようなエンジニアにとって、FIR という単語は基本的には Linear Phase EQ の説明以外でほとんど聞くことはありません。あとはあれか、スピーカーマネジメントでちょろっと聞く場合があるか。

という概念が付き纏います。実際の基礎概論、基礎理論は伝達関数、FIR フィルターを利用しているだけです。

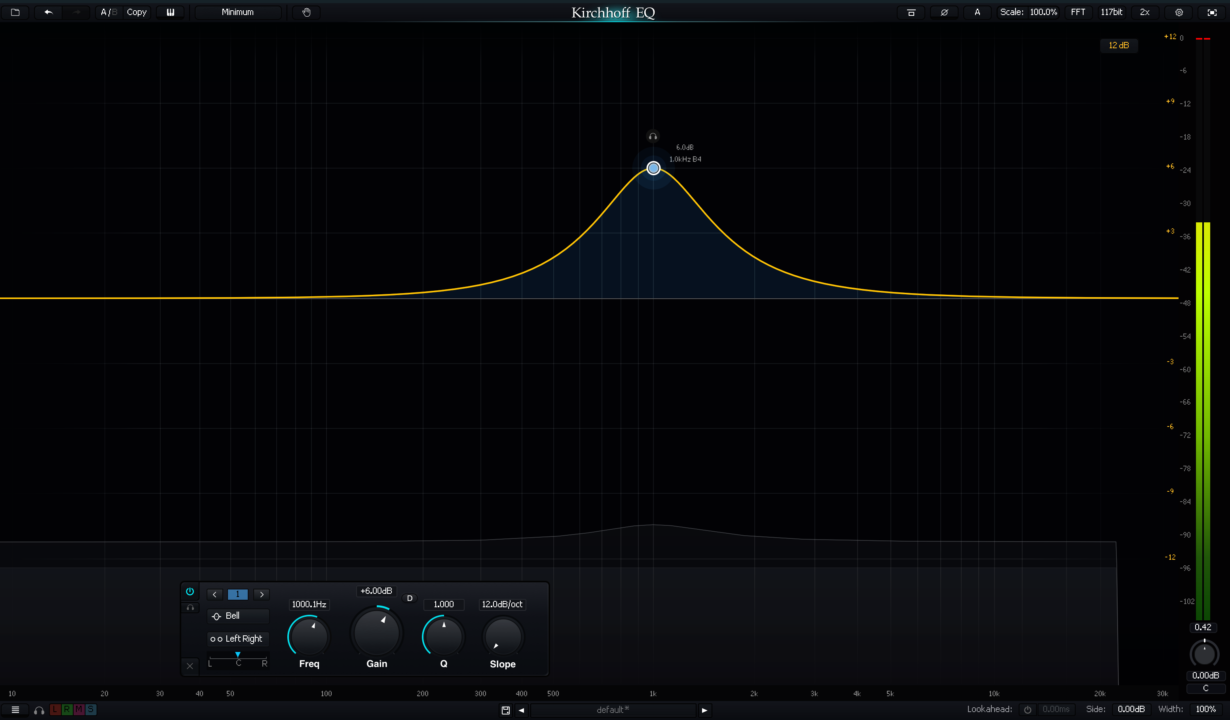

Linear Phase EQ というか FIR フィルターを利用した EQ というのは「IR」の特性を利用して EQ の特性を表現しているのです。もちろん IIR フィルター EQ も同様ですが、FIR というは IR のイチ種類のことで、広義には F「IR」でインパルスレスポンスの仲間です。

別に Finite の意味を詳しく理解する必要はない。有限インパルスレスポンスという言葉が直感的ではないし、IIR − Infinity Impulse Response も無限インパルスレスポンスという言葉も何を言っているのか直感的ではない。有限だから無限だからですっと頭に概要が入ってこないので FIR や Linear Phase EQ の基礎概論だけ知っておこう。

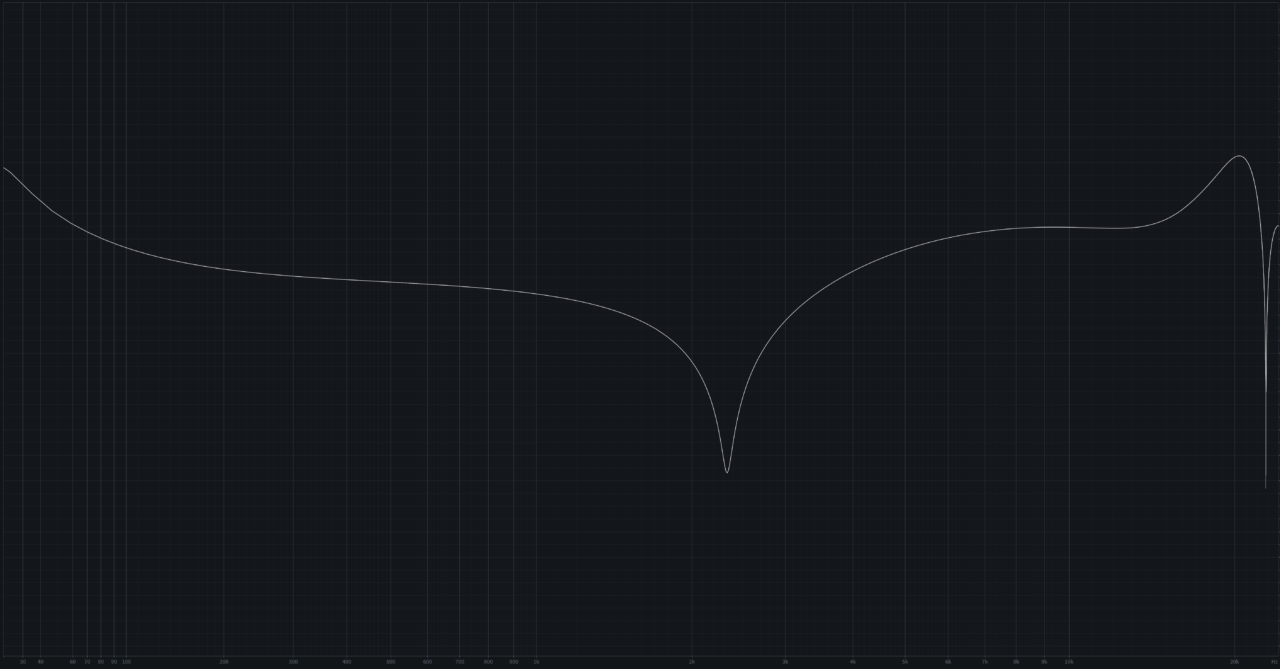

我々は先程 Impulse を使って周波数特性を知ることができました。そしてその IR を利用すれば周波数特性を素材に適応することを理解しました。つまり「求める EQ カーブを IR でつくっちゃえばいいんじゃね?」という発想になると、FIR の理解がグッとできます。

そして FIR つまり インパルスレスポンス を利用すれば任意の EQ カーブを再現できるのです。FIR を利用した EQ の基礎概論に「Band」「Q」「Gain」という概念がないのはそのためです。IR でその特性を再現してしまえば理論上、無限のバンド数の EQ カーブを作ることができます。

つまり FIR フィルター EQ の中身は「計算結果によって生成されたインパルスレスポンス」なのです。

以下、非常に有用な情報が日本語で YAMAHA さんが公開されているので、引用させていただきます。

デジタルフィルターのインパルス応答

実際のインパルス応答と周波数特性の関連を見てみましょう。図からインパルス応答が周波数特性のカーブになることが分かりますが、別の見方をすると、周波数特性 = EQカーブを作りたければそのインパルス応答波形を作ってやれば良いのです。実はデジタル EQ はそれをやっているのです!

ですからデジタルフィルターについての考察は、いかにして目的のインパルス応答波形を作るかに繋がるお話なのです。

引用の図の説明としては、Impulse は周波数特性で変化するし、周波数特性は Impulse で変化するということを表しています。

もう一度確認ですが、Impulse Response と周波数特性と伝達関数、位相特性はすべて同じもので、データの見方を変えただけのものです。LR と MS も見方が違う同一ステレオの一種で同じものだけど、数学的に変形して見え方が変わっているだけで、IR とは周波数特性である、ということを理解してください。

要領を得ない人は YAMAHA さんのページも合わせて読んで理解してください。

あとは非常に有用なページが以下にあります。

遅延と Pre-Ringing (プリ・リンギング)

おそらく皆さんもご存知であると思いますが Linear Phase EQ は万能 EQ に見えて欠点が 2 つほどあります。それを数学的に理解することができるので紹介しておきます。

- 直線位相を維持するために遅延時間が必要

- Pre-Ringing が発生する

なぜ Pre-Ringing が発生するのでしょうか。それは直線位相 (リニアフェーズ) を維持する場合に発生します。これは数学的なものなので、そうなるとしか説明がつきませんが、以下の情報を見ます。

線形位相を維持しようとするためには IR が必ず対称を維持する必要があります。

これは難しい話を理解するより、そういうものであると割り切って覚えよう。

Linear Phase EQ の遅延の原因は IR の対称性の維持のため

線形位相を維持するためには IR は左右対称でなくていけない、そして左右対称ということは IR においてマイナス時間が必要となる。これは実時間では計算処理できないため、必ず遅延が発生する。もちろん、最近の Linear Phase EQ には遅延に関する補助的な機能として、LOW とか 1kHz とかのオプションがあるけど、あれは周期が長い低域の位相特性を維持するためにはそれだけ低域の周期の遅延が必要になるから低周期の周波数の Linear Phase は無視する、というような機能になる。

対称的に IR 処理を実行するため Pre-Ringing が発生する

IR を対称的に処理する必要があるため本来存在しない処理前の IR の挙動処理が必要になる。

例えば「IR Reverb を直線位相で処理させる」なんて事があった場合、リバースリバーブのような処理が必要になるということだ。

これは Linear Phase EQ を使う人ならよく分かっていると思うけど、Transient を重視したい音に対して Linear Phase EQ は使わない方がいい、っていう話が工学的な視点でも理解できるよねって話です。

特にダイナミクスを持つ素材に Linear Phase EQ を利用していくと音が鈍るというか、Pre-Ringing のアーティファクトが非常に良く観測でき、実音に影響を及ぼしたりするので、特にドラムやピアノ、弦などで低域を Linear Phase EQ でグリグリすんなって話を聞いたことがある人はいるでしょう。

こういう知識を知っておく無駄な選択肢が減るという素晴らしい側面もある。

もちろん周期が長い周波数、つまり低域の処理をすればするほど Pre-Ringing は顕著に現れます。数学的に理解できてきましたか?

もちろん、このような数学的な知見を持つと「マスタリング時の Linear Phase EQ の場合は超高サンプルレートのほうが遅延と数学的な出力結果は有利なのでは?」というような超業務的な話ができるようになる。もちろん、低サンプルレートでもアナログに変換したとき理論的には完全に復元されるけど、精神衛生上の話になったりする。

ただし、超高サンプルレート (例えば 384kHz) の場合は実は AD/DA の挙動が変化するため低サンプルレート 44.1kHz/48kHz で AD/DA させたほうが理論的には良い、という客観的な情報意見やクロックの精度の話になったりと、もっと複雑な高度な知識が必要になってくる。

全ては自己満の世界とメリットデメリットのトレードオフの関係性を理解して柔軟に対応してくことが業務的には望まれる。

ちなみに既に時間軸上の反転を利用して IIR Filter EQ を擬似的に FIR Filter EQ にしちゃう方法を説明されているページが以下にあります。

アナログモデリング系EQをリニアフェイズEQにしてみよう!(外部)

上記は IR 特性の時間軸の左右対称を作り出して 擬似的に FIR EQ を作り出してる。内容を理解してしまえば非常に簡単な数理物理的な内容だ。

初期トランジェントとインパルスの類似性質

ではなぜ、私が Impulse と周波数特性と Ringing (Steady State、定常状態) の話をしたのか、というと、この基礎知識があれば、Transient が音像にどのように影響するのかの理解が早くなるからだ。

ここでは Transient をなぜ重視する必要があるのか、レコーディングの観点から見ていこう。

⚠ Post-Production 的な Transient 制御とレコーディング時の Transient 制御は別物であると考えなくてはいけません。

私は最初に「初期トランジェントとは制御できるインパルス波形要素」と定義しました。これはあくまで個人的な定義です。

補足的に Steady State とは IR の状態が 0 になる過程の時間の話。Post-Ringing、After pulse のことです。信号が 0 になるまでの過程時間。IR Reverb でいうところの余韻の部分。物理の世界を理解している人ならわかると思うけど低エネルギー状態の安定に移行する話。音楽の場合は Release 音が無音になるまでっていう感覚でいいと思います。

楽器の場合

レコーディング時に初期トランジェント要素をエンジニアが制御できるか、と言われるとほぼ無理なのですが、楽器側や演奏者に初期トランジェントを制御できる筐体や演奏方法がある場合、音色変化が極端に起きることは想像に固くありません。

初めの方にも語りましたが、楽器の初期トランジェントもしくは二次トランジェントがどうもその後の倍音形成に関係しているのでは、という研究論文が簡単に見つかります。全てに適応できるものでもありませんが。ネット上で論文を探すと簡単に Initial Transient が楽器に与える影響について語っている論文はすぐに見つかります。

それらは例えばクラリネットの初期トランジェントはどのように形成されるのか、リードの研究や口の形、空力学的な側面で研究してあるものなど、いろいろ見つかります。

管楽器の Transient に関連する論文を読むと「聴衆は、異なる楽器の音を区別する際に Transient に大きく依存しています。」という文言を簡単に見つけることができます。もちろん管楽器の Transient についても研究の情報は割と豊富で「スラートランジェント」なる別の言葉も登場します。

私が以前マスキング対策で Transient を制御することで、聞かせる人への認識のさせ方、つまりマスキング対策に利用できる可能性があると、発言していますが、難しいというか深い理解がないとダメなので「辞めて、おけ怪我するぞ」と発言しています。

今回はそれらを深く、主観的な意見ではなく、実例を交えて紹介したいと思います。

トランジェント制御をしてのマスキング対策は難しい

また、EVERTONE PICKUP なるギターピックアップがございますが、開発者の門垣さんはトランジェントについて熱い研究の成果をこのピックアップから垣間見ることができます。マジで音がすんごい変わるのよ。

ギターを利用した思考実験

以前、ドラムのサウンドクリエイトで要素を分けて処理をしよう、という内容で記事を書きました。

それを例に今度はギターという楽器で思考的なお話をしたいと思います。

ギターは弦とボディとピックアップなどの電子部品で大まかに構成されています。

ではここでの要素を分解して考えてみましょう。

- 弦の初期トランジェント (インパルスと仮置き)

- 弦の振動 (定常状態への移行期間と仮置き)

- ボディの振動 (インパルスレスポンス要素と仮置き)

- 電子部品 (追加のインパルス要素)

この用に要素を分けて考えることができます。もちろんピックアップが Impulse 要素を正確にキャプチャできるのか的な問題は現実的には存在しますが、思考実験なので無視しましょう。

今日、ここで Impulse と IR と周波数特性の話を十分に理解している人なら、弦のインパルス要素、つまり「初期トランジェント」がどれだけ大事になるのかを理解できると思います。

- Impulse はすべての周波数成分を持つ波形でした。

- Impulse Response はすべての周波数成分を持つ波形の過渡応答を見ています。

- 過渡応答を測定すれば周波数特性がわかります。

- 過渡応答は定常状態へ移行する反応もわかります。

このように思考実験上では「ギターの音というのは弦の初期トランジェントで決まる」と言い換えることができます。

もちろん、これは極端な思考実験の産物であり、もっと複雑な要素が絡み合いますし、初期トランジェントが逆に楽器の正常な発音の妨げになる事象もあるでしょう (初期トランジェントばかりにとらわれるとよくない場合も存在するし、演奏が下手な場合とかさ…)。

ただ、Transient 自体が楽器に於いて 非常に重要であることは明白である ことは理解できたかと思います。

今まで Transient という言葉がひとり歩きしている状況であった方にとって、Transient が重要な要素であるという客観的な知見は得られたかと思います。もちろん、これらは思考実験であり、私の誘導尋問的な書き順があります。

トランジェントのみを解析してみる

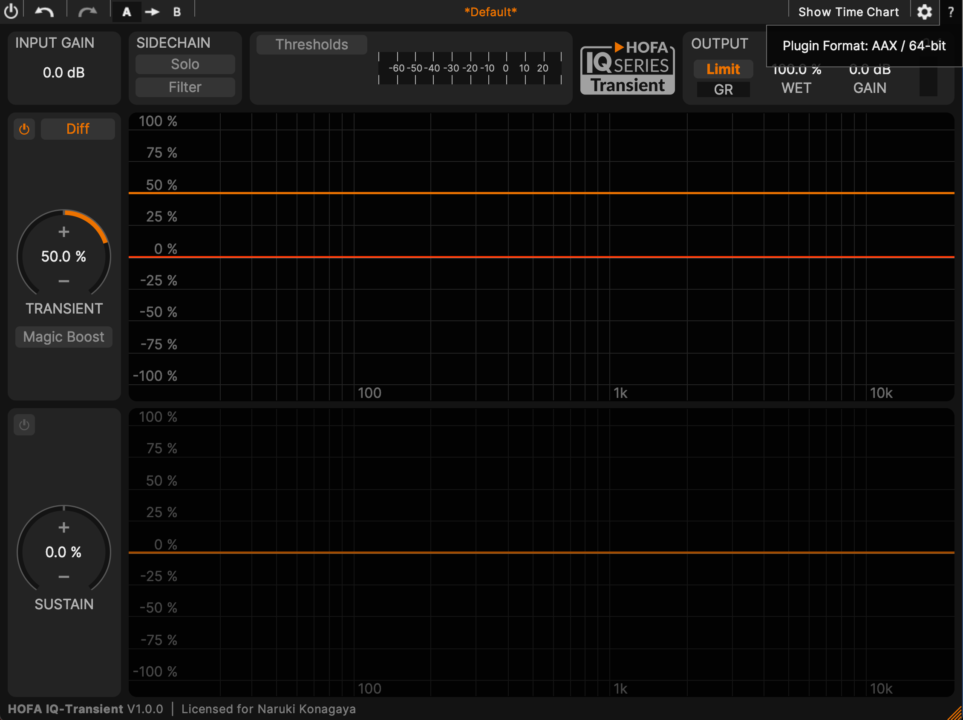

現状通常の Transient を制御できるプラグインはトランジェント成分の増減の挙動を主に操るものです。もちろん、高度なプラグインになるとトランジェント成分の周波数特性を EQ できます。

いくつかのプラグインで Transient を抜いてみましょう。 (といっても Delta で抜けるのは数限られますが。)

ちなみに こちら の論文で Transient 検知に関する研究情報が得られます。

初期のトランジェント成分だけを抜くのは実はプラグインでも難しいため、大体が Transient 要素を抜き出します。初期はだいたい基音の 5.5 倍の関係のない周波数になりがち、らしい。

ということはこの初期トランジェントの音量や周波数特性を極端に変化させていくと音の認識についてどんどん変化するのは言うまでもない。

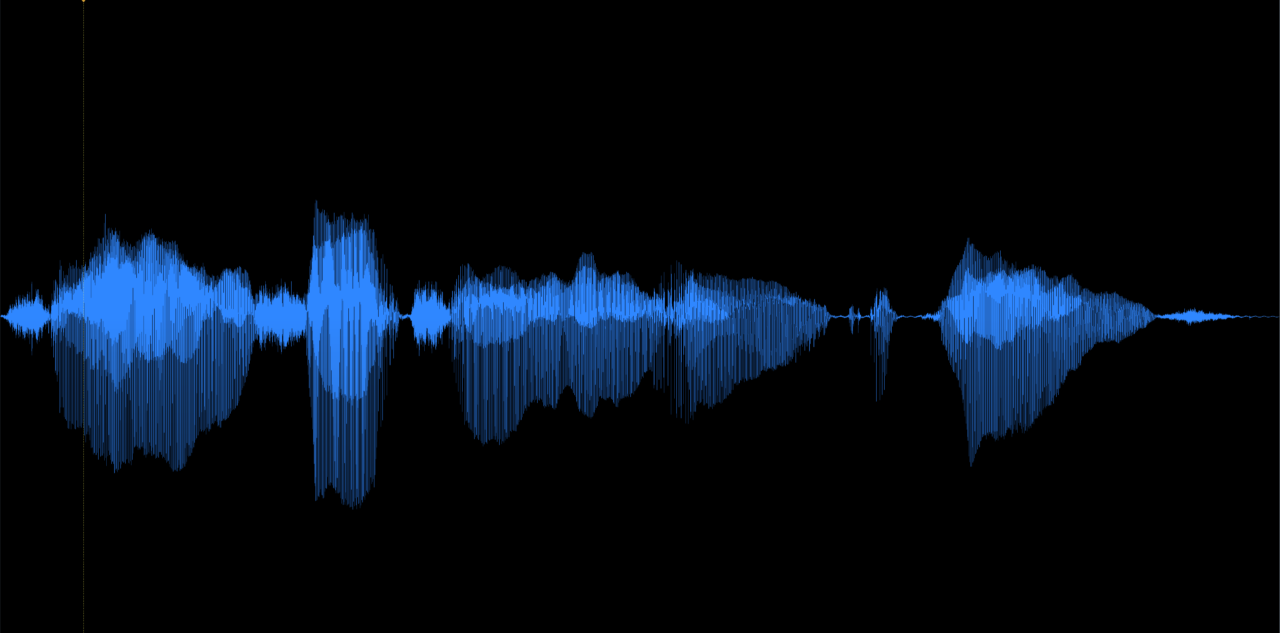

オリジナルのスネアサウンド

上記はオリジナルのスネアサウンドで特に変哲もない音。

Transient 要素のみのスネアサウンド

今回は HOFA IQ-Transient というプラグインを利用して Transient のみを抜き出しました。

Kick は特に面白い。

オリジナルのキックサウンド

上記はオリジナルの Kick、こちらも特に変哲もない音。

キックの Transient 要素のみを抜き出し

オリジナルのアコースティックベースサウンド

変哲もないベースの音ですよね。常に気にしていないと Transient の音が聴こえてきませんので、常に意識をもって聴くことが大事だと思います。僕は既に Transient とそれ以外が勝手に耳と脳が捕らえてしまいます。

IQ-Transient の Delta サウンド

Spiff の Delta サウンド

⚠ 実は現代ではここが重要

初期トランジェントや二次トランジェント合わせて上記では「Transient」と定義していますね。

ここ重要です。初期トランジェントと自分が制御したいトランジェント要素はちょっと違う。だから初期トランジェントや二次トランジェントって言葉を利用してきた。

以降は初期トランジェントというよりは私が制御したトランジェント要素、成分、そんな見立てで記事を見てください。

サックスのオリジナルサウンド

こちらも変哲もないサックスサウンド。

サックスのトランジェントをブーストした音

サックスのトランジェントをカットした音

その問いには後に答えることになるでしょう。

一応 IQ-Transient は Magic Boost という機能と Threshold 値を指定できるので、あなたの思う音楽的な範囲の初期トランジェント制御はできる。ただ難しいよ。すべてを動的に処理させてもどこかでミスはある。

ボーカルのトランジェント

表現が強い素材、Transient 常にはっきりと存在する素材と、演奏方法で Transient が友好的に働く時と働かない時が入り交じる素材では非常に制御が難しいため、何でもかんでも Transient を制御すればいいってものでもない、という話が理解できると嬉しいです。

中には音量は大きいけど Transient の音は小さいほうがいい、なんていう表現が必要なときはかなりあるのです。

マスキングの記事で語った「なんでもかんでも Transient を制御すればいいってものでもないぞ」の具体例とはなります。

オリジナルの素材。歌を聴くと言語の認識には Transient が重要な場合もある、ということが顕著に理解できる。それらを不自然に変形させていくと、やはり「認識」の問題に発展していく。

ボーカルのトランジェントブースト

ボーカルのトランジェントカット

そこにエンベロープが存在するか否か

ここでは最初に答えを出しておきますが、初期トランジェントを積極的に制御し、ミックスで利用できる素材は「立ち上がりの素早いエンベロープが形成されているか」で判断できます。

全ては「楽器による」というより「全ては演奏表現による」です。あと打楽器なのか、撥弦楽器なのか、とかですね。ただ、撥弦楽器だろうが打楽器だろうが、演奏方法で初期トランジェントが全く関与しない演奏方法があるので「全ては演奏表現による」です。

重要なのは本当に演奏表現なのです、ミックスしているとかなり忘れがちになることではありますが、常に忘れないようにしたいことです。

それは、多分ここまで読んでくださった方ならほとんどの方が気づいていたことでしょう。 ただ、人に言われて再認識することも大事なことだとは思います。

ボーカルの波形を見るとそこには立ち上がりの早い瞬間的な音と立ち上がりの遅い音が混じっています。

このような場合に Transient を制御できるプラグインは特に音楽的な挙動を見いだせません。だからボーカルに立ち上がり制御のボリュームオートメーションを書く場合が多いのです。

もちろん演奏方法にもよりますが、表現が多彩な楽器に対して常に Transient を制御してもあまり音楽的なものにはならないでしょう。もちろん、逆を狙う必要な場合もあるでしょうが、それはすべての挙動を理解しているからこそできるアプローチであって、通常は回避するべきものでしょう。

ピアノのエンベロープ変化とステレオイメージの変化

さてはて、具体的な話になります。では「なぜエンベロープ形成が大事なのか」に迫ります。

今までの例では「意図がない Transient 制御はダメだよ」とぶっちゃけミックスの心構え的な話をしました。分かってるわそんなこと、ってレベルですよね。でも忘れがちです。

では、Transient を制御して「どのような効果を得ていくのか」具体的な話をします。

ピアノのオリジナルサウンド

オリジナルのピアノの音、いい音ですね。好きです。

トランジェントをカットしたピアノサウンド

う〜ん? なにが変わったのかわからない…なんて方はいないだろう。

この続きは有料版で

空間表現とはなにか

空間表現というものをミックス的な視点で具体的に解説されているものはないですが、Reverb や Delay、Chorus といったエフェクターを使ったもの、というような感覚を日本語情報では得られます。

実際には高度なステレオリバーブや空間のシミュレートをしてしまえば、手っ取り早く「空間の響き」は再現できます。しかし、私が表現したい空間表現とは異なります。「空間の響き」と「空間表現」は似て非なるものです。

スネア全体を Reverb に送った場合

以下はスネアのトラックにリバーブを適応した場合の音。

スネアのトランジェントをスプリットして Reverb に送った音

以下の画像の感じ。オリジナルの素材はそのまま、Transient だけを抜き出したチャンネルに Reverb を適応した。

Transient のチャンネルには Reverb 乗りが良くなるように少しだけ手を加えてはいますが、測定上は音量は同じです。全然 Reverb の乗りが変わってしまいます。音量が違うという人は数値を信用して。

この続きは有料版で

空間表現とは 広い (近い) → 狭い (遠い)

距離感の作り方は 近い→遠い

この続きは有料版で

私の認識している空間と距離

この続きは有料版で

空間表現は実は Reverb だけで片付けることができない

音の立体感の正体

⚠ 注釈

この話は空間表現の Transient の部分にフォーカスした内容なので、Reverb や空間表現についてはもっともっと、深いパラメータへの理解が必要であったり、ステレオフィールドの錯覚アプローチや M/S への深い理解、または Modulation への理解だったり、Delay の効果的な使い方や、Reverb そのものへの理解が必要です。

Reverb はパラメーターの勉強がマジで難しくて、そしてとても面倒なので、これでおしまいにしたいです。

トランジェントの認識基準

はい、もちろん Transient がなぜ重要なのかについては空間表現についてだけではありません。もっと重要な部分に取り組まなくていけません。

マスキング対策に Transient 制御を利用するとえらいこっちゃになると話をしたと思います。

わかりやすい例を用意しました。

オリジナルのタムとフロアサウンド

一応、音階になっています。

ドラムの場合、こういう感じよくあると思います。

2番目のヘッドダウンサウンドの Sustain 調整と調和取れてれば完璧だね。

トランジェントのみのタムとフロアサウンド

あれピッチが…

もちろん基音は音階そのままですが、Transient の出方一つで 2つ目がピッチが低く 3つ目のタムのトランジェント成分がかなり音程が (オクターブ上) 高く聞こえますよね。

というか、全部同じに聴こえてきません?

1つ目と3つ目のタムの支配的な倍音のトランジェントサウンド

1つ目は E 、3つ目は A のチューニングです。

この Transient の倍音というか周波数特性だけではほとんど楽器の聴き分けができずらい状態になります。もちろんそこに音程感はありますが、既に Tom であるという認識は調整した本人以外無理な領域でしょう。

これは Tom と Floor の Transient の音を聞いています。前に戻って、Snare と Kick の Transient の音も聞いてみてください。ほぼ同じような音じゃないですか。これを聴衆に聞き分けさせるのはもはやありえないわけです。

容易に想像がつくと思いますが、似たような楽器、特に発音構造が同じような楽器の Transient 特性はほとんど一緒になります。つまり似通った音の Transient をすべて調整しだすと、途端に 誰が誰だか分からなく なります。

もちろん、アンサンブルとして聞かせる場合にパートごとにフューチャーする必要性はありませんが、 同じフレーズを演奏している場合、それぞれちゃんと聞かせたいな、と考えた時、Transient 制御は逆に楽器別の識別や認識が極端に難しくなる原因となります。だからマスキングには使いづらいという話をしました。

でも最初に楽器を認識する上で Transient は重要な要素であると語っているではないか。

ではなぜ、最近は良く「Transient が重要だ」と言うのでしょうか。

それは楽器の発声に於いて重要であって、ミックスでは Transient が邪魔になる場合も多いから、なのです。

トランジェント「だけ」が重要ではない

Transient ばかりフォーカスされるので、Transient の増強視点や、強調的な視野しか見えなくなるのは当然の話ですが、重要なのは Transient の周波数特性と以降の周波数特性なんですよ。

この話は時間制御の記事で語っているのですが、結局は時間軸の問題に発展してきます。

散々 Reverb の認知の影響を話ましたが、結局 Transient を制御すると「リリース挙動の制御も大事だよね」に発展するのです。

ADSR、エンベロープ…またこの話か…って感じ。

曲のテンポでも認知のさせ方は異なるのですが、自分がミックスをやっている デスメタル みたいなテンポが 200 を超える楽曲の場合、もはやリリース表現が (8分で 220 くらい超えると) 譜面上も物理的にも難しくなるので Transient を優先せざる負えない、みたいな側面はあると思いますが、皆さんはそうではないと思いますので、Release 表現や譜面上の表現を大事にしていきましょう。

トランジェントが制御できるのは ADSR の A もしくは AD だけだが

Release 表現が大事なのはわかりました。しかし、この記事の内容は Transient であるため、Release に触れる処理ついては語りません。Transient についてフォーカスはします。が、面白いので是非理解しましょう。

Transient にフォーカスするとなぜ Sustain や Release 表現に干渉できるのでしょうか。Reverb のときはなんとなく、そうだろ、って思えたと思いますが、通常の Dry 素材においては、そんなこと言われてもわからないので実演していきます。

ドラムのキットサウンド

もう説明は不要だと思いますが、Transient っていうのは同じタイミングで複数の発声があった場合、最終的にはただのノイズにしか聴こえません。最近「エンベロープを調整しろ」って言う人の言葉は「時間制御ちゃんとやれ」と同義で「立ち上がりの制御」をちゃんと関係性を持ってやりましょう。って意味だと思います。

これは Kick と Snare が同時で叩くときを想定した素材。

同時発声する時が一番問題が起きる。

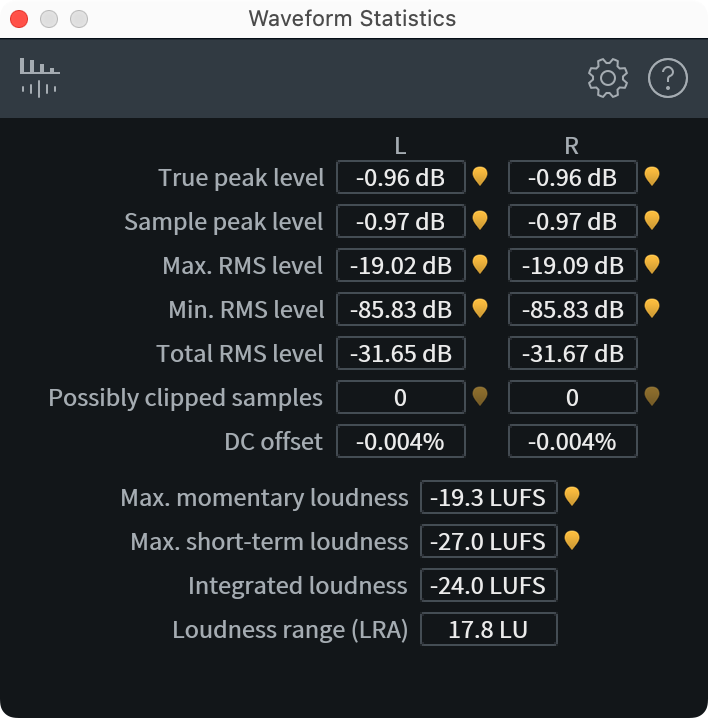

キックもスネアもトランジェント増強

可もなく不可もなく…強いて言うならオリジナルと比べて若干 Kick の Transient が不明瞭で Low サウンドがガサつく…?

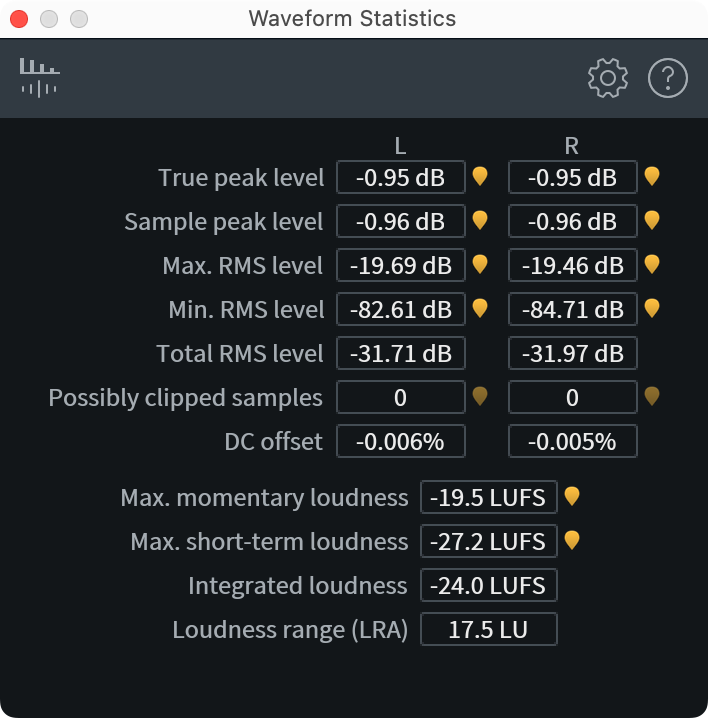

スネアはトランジェント増強し、キックはトランジェントを減少

あっれ「Kick の音量変えたやろ! 比較にならんやろがい!」

って怒ってる人いそ〜。そういう人、よくここまで読んだな。これが Transient 制御の醍醐味。

残念ながら Peak 値では Kick は同じ値なんですよね〜。

音量上げたら普通は Peak 値って上昇しちゃいますけど、瞬間的な制御をすることでここまでできるんですねぇ。

これはちょっとしたミックスハックみたいなことなんですが、今のっていうか一昔前はミックスっていうのはどれだけ 0dBFS の中にデータを詰め込めるか、みたいな競技じみた側面もあって、各トラックの関係性を丁寧に対処していき、常に 0 dBFS を超えないようにかつデータを入れ込むために音量制御をするんですよ。

海外のミックスがかっこいいのはコンプレッサーのリダクション動作然り、サイドチェーン然り、こういう瞬間的な音量制御をちゃんと行っていることなんですよね。実際にはここに上モノも入ってきたらもっと大変な音量制御を行うための処理をしているんですよ。

重要なのはどこまで行っても音量制御。

トランジェントを増した素材に追加でコンプ処理した音

ドラムってコンプレッション必須ですよね!

ち〜ん。

Kick どっかいっちゃったね…なんか邦楽でよく聞くサウンドってこんな感じしてきた。

日本の楽曲は LOW END がどうたらこうたら、洋楽はかっこいいのに邦楽はウンタラカンタラ言う人の気持ちもわからんでもない。エンベロープの関係性も精査せずに、適当な設定ででコンプしてみました! ビンテージコンプ通したらいい音になりました! というようにエンベロープの関係性がコンプで容易に崩壊するのですよ。

ここまで極端な楽曲は流石に最近はあまりないと思うけど、たまに洋楽と邦楽の違いについて憤慨している人を見かけます。が、諦めましょう。音楽に対する向き合い方やそもそもの音楽のルーツが違うし、楽曲の解釈がまるで違うので違う音になるのです。

当たり前のこと説明してて、うんざりするされる人もいるとは思いますが、日本の楽曲と海外楽曲の一番の違いが Transient の時間制御に見られることなんてよくあることです。あとアレンジの違い、アレンジャーは海外アレンジの細かい部分をもっと研究してほしいです。僕は研究しましたよ。EDM では普通にみんな素材ごとのリレイションを確認するとは思いますが、こと生楽器になると途端にこれができないできない。

重要なのは「どの時間軸でどの音を聞かせるか」です。

結局はエンベロープの制御です

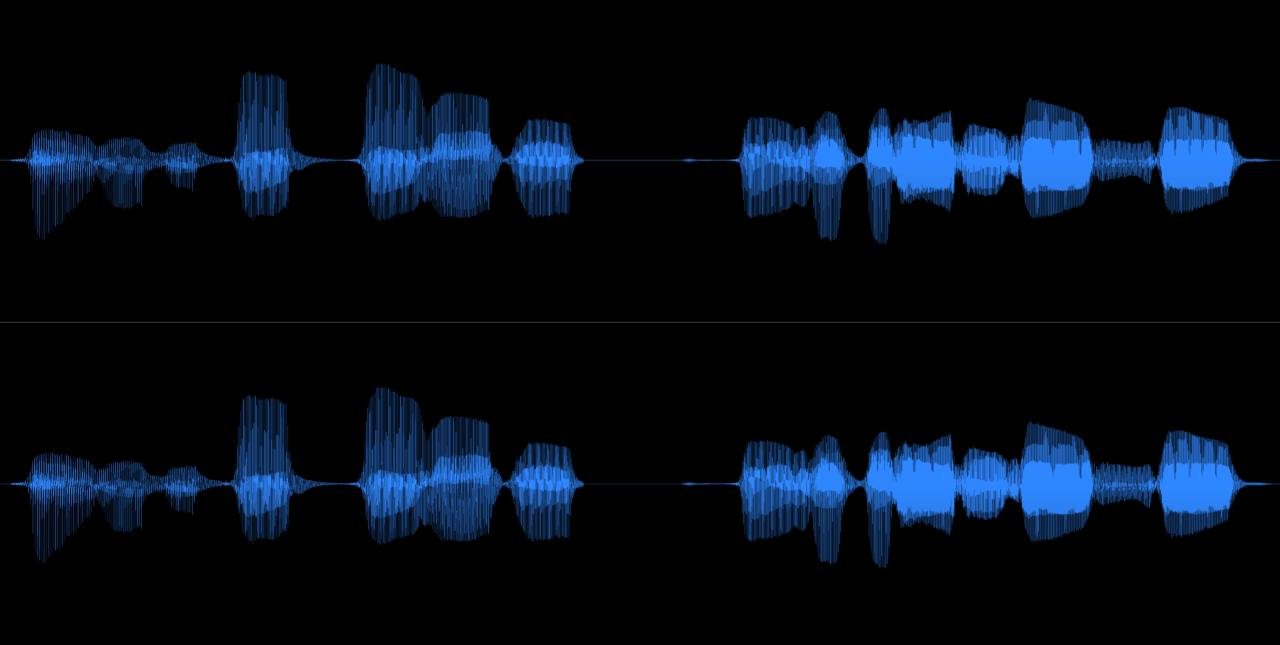

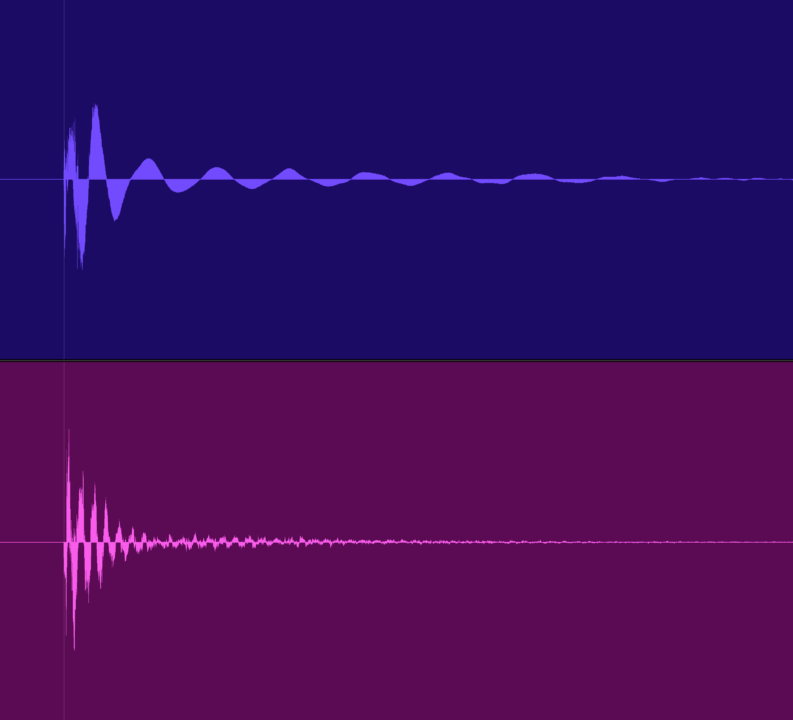

ではどのような時間関係にあるのか波形を見ていきましょう。

上の波形が Kick、下の波形が Snare です。

ギリギリ Transient の同時発生は免れています。しかし、Snare の Release 音、つまりはスナッピーサウンドと低周波の Transient が同時に当たるため、少し低域が濁ったように聴こえます。別に悪くはないと思いますが Low-End に Focus したい人にとってはまだまだの領域。

続いては Kick は Transient を削り Peak 値で同じ数値になるところまでブースト。

波形自体ではあまりインパクトを得られないけど、音聞くと、急に「これで俺も海外プロデューサーと肩を並べたぜ」みたいな音になる。行ったことは Kick の Transient 削って元の Peak 値にまで戻しただけ。ただ、Snare の Release は Kick に負ける。

ただし、認識の上では Snare の Release が脳内補完されてしまうので全く違和感を感じない。これは生ドラムを近くで聞いてもこんな感じになる。なぜかというと人間の耳や脳にもコンプレッションがあり、結局一番大きい音が他の音をかき消すため、生ドラムのサウンド感覚には近づくのだ。

あんまり大きな声で言えないけど、同じ LUFS なのに海外のほうが音が大きく聞こえるのなんでだろう…的な問題はだいたいこれ。あと、コンプレッションのさせ方と歪みの上手な使い方、そしてフェーダーワーク。

最後にドラムはコンプ必須みたいな固定概念でコンプしちゃった系

もちろん、これは設定が下手なときの例で、上手な人はこうなりませんし、まずコンプ使わないんじゃないかな…

あとは Bass と Kick を同じ Bus に送ってコンプしちゃった場合とか、コンプ設定によっては両方の Transient が失われ、Release 表現が Bass と Kick でチグハグになってやばい場合もある。たぶん最近は誰もやってないアプローチ。

Snare の Transient と Kick の Transient が干渉し、Kick のリリース表現が失われたため、これは明確に間違った方向性のドラムサウンドだとは思う。

ただし、ここからエンペローブの再形成ができる人がいるからこそ、間違いでもない。ひぇ。難しい。

エンベロープに対するアプローチを持っている、知っていれば、元々の素材が楽曲合わせたエンベロープを保持していないとしても調整はできる。もちろんエンジニアがどこまで介入するかは、案件によるとは思いますが、曲を作る人やアレンジャーなどができる範囲でそれらを調整する技術があるとエンジニアにとっては「このミックスめっちゃ楽だわ〜」になる。

エンベロープ制御はモダンミックスの見え方の話

現状説明している制御はかなりモダンアプローチの話をしているので、名盤の Jazz ミックスに完全応用できるか、みたいな話とは異なる。もちろんモダンな Jazz をというのなら、そういうアプローチもありかもしれないという考えはできますが、重要なのは Transient を制御することではなく、どのような音楽の方向性にもっていきたいのか、そのためには Transient が必要な場合もある、という話をしている。

重要なのはミックスの見え方で、重要なのはその正しい感覚である。

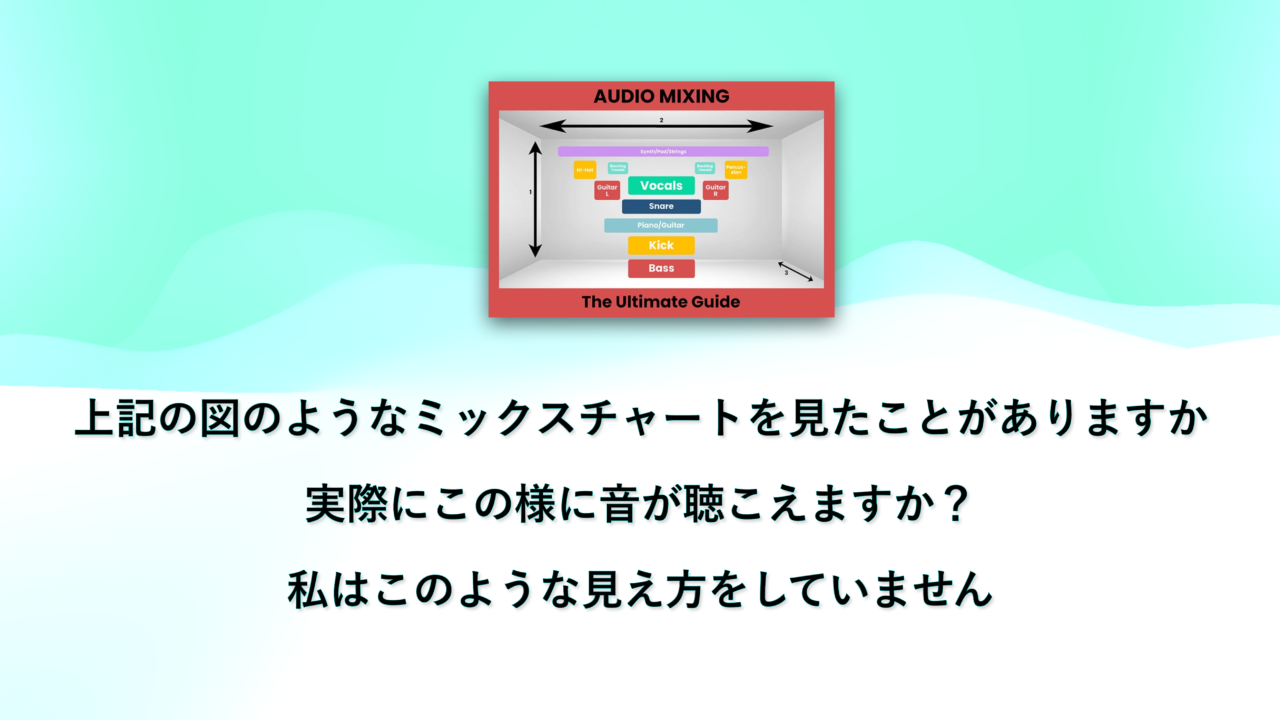

ミックスチャートはあくまでチャートであり、このような配置は 2Mix 上では不可能であることは容易に理解できるだろう。上下定位なんて 2Mix 上で完全制御するなんてマジで無理なんで。

残念ながら最近のモダンアプローチのミックスというは既に上記の様なよくあるチャートのイメージはほぼ役に立ちません。だってスネアが聞こえた瞬間ボーカルは瞬間的には聞こえなくなるだろうし、キックが支配的になったときベースの音が聞こえることはほとんど無いだろうし、この感覚わかりますか?

エンベロープを調整するというのはほんの数ミリ秒の波形関係を全部調整していくということなんだ。

難しいというより、関係性を聞いた瞬間に判断でき、どことどこの素材が干渉しているか耳と目で瞬間的に判断し、そして微調整や素材の関係性を洗い出すことで、単純に、聞き取れるか、その作業をできるだけの時間的猶予はあるのか、という現実的な問題へ発展していく。

問題は制作時間と全員の意識的な理解レベルの問題へ発展していくのであと 10 年は様子を見よう。

今までの常識的な視点を覆せ

これらはすべてが私個人の疑問から発展し、気づいたことであり、誰かの受け売りではありません。

これは自分が信用できない、という根源的な問題から発展しています。

みんなはああ言っているけど、全く同意できないし、共感もできない、これは俺がおかしいんか?

というようなところから発展しています。

ミックスというのは常識を打ち破ったときに新しい世界が見えてくるのかもしれません。

上記は私が 10 数年かけて到達した領域であり、これを公表するのに勇気が必要だったことを察してください。ちなみに自分のモダンなアプローチミックスを持っていくと大体ダメ出しくらいます、そういうことです笑

トランジェントが重要であってプラグインが重要ではない

この問には常に答えて行かなくてはいけない。

プラグインがあなたのミックスを悪くすることはありません。

そのプラグインを使ってあなたが間違った方向性のミックスをしているからミックスが悪くなります。

Transient を制御するプラグインがあなたのミックスを良くすることもありません。

あなたが思い描いた通りの制御をプラグインが行った時、あなたのミックスが良くなります。

ここ間違えている人が多すぎます。

トランジェントを直接制御するプラグイン以外を利用したサウンド

以下は Slate Digital の VMR だけで作ったサウンド。

同じこと、ドラムの有料動画で語ってたわ…

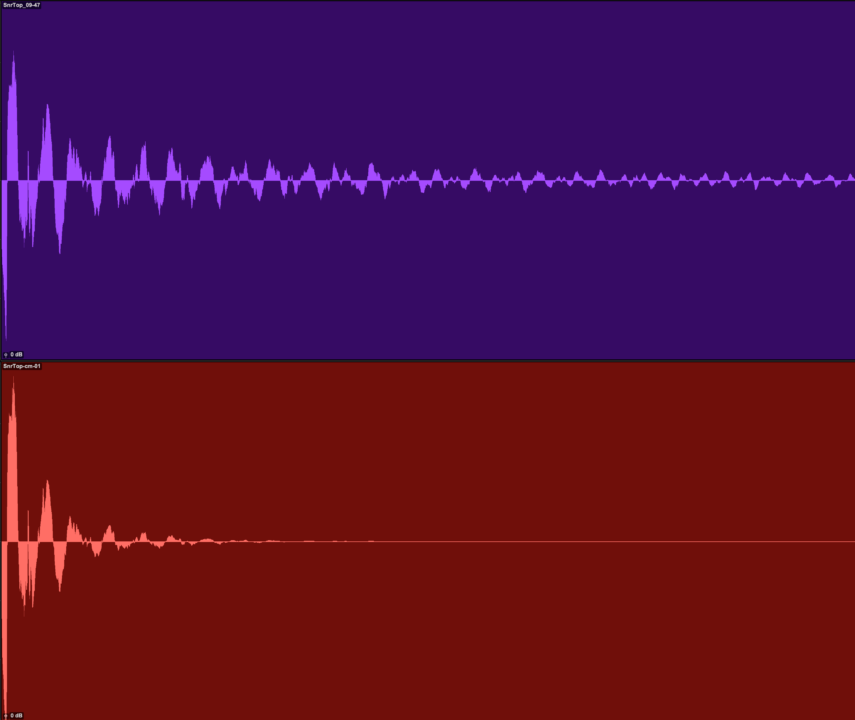

画像すみません。これは上が Snare で下が Kick。

歪み系とダイナミクスをいかんなく利用した。往年の Rock サウンドを求める場合には 1176 が活躍するのは、このエンベロープの形成に役に立つことが多いシチュエーションがあるためだ。ただ、闇雲に使ってもこの挙動は得られない。

だから Compressor って難しいのよ。

特に重要なのは SSL の Dynamic 系統のモデリングで初期トランジェントを殺してること。これは Expander の重要な機能。ボーカルコンプレッションでも初期トランジェントを殺してからコンプすることで、最初の立ち上がり方だけは制御できる。これは既に動画で語っているね。アナログコンプでのこの処理は割りと私はやります。

日本では Expander の重要性と Compressor とのセット論は一切語られてきていないけど、Expander は初期トランジェントの制御のための重要なツールで昔の設計者はこのことを分かっていたと思う。

ここでは EQ が全く登場していないのがわかると思うけど、EQ はエンベロープに干渉しちゃう ので、また別のお話。ただし、既に解説済みではある。基本的に EQ はエンベロープ形成前に行おう。Pre-EQ が基本になります。日本では Post-EQ が基本になるのでエンベロープへの概念が存在しない。

そして Reverb はエンベロープの形成に利用するもの。

Snare だけ Room Reverb の感じを付け足した。

Reverb の掛け方がよくわからないって人はエンベロープを意識してリズムに合わせたり、波形を見たりして、決めていこう。

もちろん、Reverb の特性は Transient の周波数特性によって変動することも忘れてはいけないぞ!

もうここまでの解説でいいかな…

最重要課題、ダイナミクス制御

重要なのはダイナミクスを制御するとエンベロープがどの用に変化するのか、を深く理解することです。

特に忘れがちになるのが、Gate/Expander の話です。

なぜ Expander (Gate) が重要になるのか

そして Compressor

サイドチェーンと相性いい気がしてきた

逆のアプローチだって考えられる

もちろん立ち上がりの制御ができるんだ、Kick が先、Snare が後だってできる。

ただし、立ち上がり方が変わると、音色の変化とグルーヴの変化があるので、これをどちらを採用するか、がマジで重要。演奏の感じ方めっちゃ変わる。ただ、演奏者が作ったグルーヴというのもあると思うので、ここまで介入することはほどんど無いけど、若干あたりを調整することはよくある。

スネアの Transient というか立ち上がりが後ろに移動した関係で周波数特性が変化、スネアの音がなんかビンテージサウンドっぽくなる。

Transient の立ち上がりが遅い音はなんとなく Vintage 感を感じることがある。これは憶測の話ですが、昔は初期トランジェントのキャプチャと録音、そして再生が難しかった影響ではないかと。

なんとな〜く Jazz とか合いそうですよね。もう少し Kick や Snare の余韻を Room マイクとか Amb マイクで足していけばそれっぽくなりそうだなぁって感じれれば、あなたは優秀。もちろんこの後 Reverb 等を追加すると、また Reverb の乗りが違うので、想像する方向性へ向かうだろう。

つまりは録音技術や再生技術で新たなジャンルが生まれてきたというのは非常に的を得た指摘である。

ビンテージサウンドの根源はおそらく「音の立ち上がりの遅さ」が関与しているのでは、と思ったりました。あくまで個人的な仮説です。

グルーヴ形成の話 (蛇足)

幾度となくグルーヴについてその認識については度々語られてきた。

グルーヴは人間独特の揺らぎだと言う人もいますし、微妙なタイミングのズレだという言う人もいます。グルーヴの言語化は非常に難しいです。ただし、一発で解決する言葉はあります。

エンジニアが介入できるグルーヴとは「エンベロープと音量の揺らぎで決まる」ということです。残念ながら Grid バチバチの素材でも立ち上がりの制御とリズム周期における音量制御でリズムグルーヴは創造できます。

既に Compressor の動画で、ダイナミクスを制御していくとグルーヴも変化するという話をしているので今更突っ込んだ話はしません。

あとで多分理解できます。

トランジェントを利用した具体的なアプローチ

Transient の制御が上手くできないと結構よく起こる問題について。

ピッチの認識範囲

以下は素のスネアサウンド。

ピッチ自体は A#3 で 233 Hz が基音かな、ただ、銅のスネアっぽい音、Copper サウンドかな、で倍音も割りと支配的なのでちょっと軽いスネアに聞こえる。

アンプ経由の極端なピッキングニュアンス

まだまだ、どうしてもピッキングのニュアンスというものが潰れがちなギターアンプシミュレーションを使う場合、IR への橋渡しも考えて、Transient 挙動を極端にしてから送ってみます。

こちらは普通にアンプに送った場合。

以下は Transient を極端に整形して、ピッキングニュアンスをもう少し歪みアンプ挙動に上乗せしたもの。普通に Lead Ch と IR Cabinet なので音はバリバリに潰れちゃうのでニュアンスがなかなか出せないのですが、結構いい感じにピッキングニュアンスが残る通じるくらいには音が形成されます。

アンプの設定は一緒です。入力する Transient を整形しただけです。従来ではなかなか不可能でしょって言われた、ピッキングニュアンスですが、頑張ればここまで表現できます。

海外のギターレコーディングでギターと音がガンガン 0 dBFS 超えて録音しているものとかあって、あれは完全にレベルオーバーの波形をギターに入力させていて、あれもアプローチとしてはありだけど、私は真似できないよ…って思いました。あれは音がガンガンにつぶれてギターの壁みたいな音にはなります。

いや、そういうデータもらったこと結構あるんですけどね。

エレキベースの場合

キックとベースをトランジェントブースト

ベースはトランジェントブースト、キックはカット

ベースはトランジェントカット、キックはブースト

音楽的なトランジェントの使い方とは

簡単なヒント

例えばボーカルで Transient 制御したい場合

最後に

この記事を公開するかどうか、非常に悩みました。

どうせまた色々言われるのだろうと。あと焼き増しの情報が拡散されるのだろうと。

ただ、もういいかなって思いました。

あと作るの非常に面倒であったので、有料記事 にしました。

購入は以下からお願いいたします。

この続きを読むには

この続き: 43,502 文字 / 画像43枚 / 音声36個

記事を購入する

この記事の内容は Engineering Alliance (EA) でも販売を開始いたしました。決算方法がスムースに行え、過去に購入したものをログイン画面で管理が可能です。