アナログコンソール (チャンネルストリップ) の概念と DAW (モニター環境) の統合

最近、話が通じない理由に「アナログコンソールへの理解の壁」があるのだと勝手に個人的に思ったので、今回は「如何にアナログコンソールが偉大であるか」を自分なりに解説したいと思います。

実際には「アナログコンソールの音がどうのこうの」っていう話ではなくて、アナログコンソールのパッチワークやシグナルフローが重要であって、それ以外の機能というか信号処理はおまけに語ります。

以下で語ることを理解することは実務経験がないと確かに難しいものですし、その重要度がご自身で実感できるかどうか、というのはかなり個人差があると思います。

アナログ機材への理解は今回はどうでもいい

アナログ機材への理解と今回のアナログコンソール (チャンネルストリップ) の話は全然違うことを話します。大体アナログコンソールの良さを語るとき「アナログ」な挙動について語る人しか基本いません。

当たり前です。だって話す内容が簡単なんですもん。アナログは音がいい!とか言っておけば通ぶれるし。

私が今回する話はめちゃくちゃ面白くもなく、深く理解していなくても商業の方以外は実務的には問題がないものです。ただ、知っている人と知らない人ではかなり音源におけるアプローチの差がでることは間違いありません。

重要なのはアナログかデジタルなのか、とか、アナログ機材のフレバーみたいな話とかと全く異なります。

後半につれて理解度が深まるように説明できればいいですが、重要なのは信号経路 (シグナルルーティング) であります。

以前に アナログとデジタルの選択 について、全く理解されないであろう、自分が過去最高に力を入れて書いた記事が以下にありますが、この記事が理解できるようになることを前提で今回は話を進めていきます。

この記事が深く理解できるように

DAW 全盛期だからこそ、知らなければいけないルーティング

現代の DAW は配置されている音声データをマルチで発音するものであり、レコーダー機能やマルチ出力は最早サブ機能みたいな扱われ方をします。

なぜかというと、DAW で拡張できる機能がご自身が利用している Audio Interface に強く依存して、制作環境に制限が構築されてしまうからです。これはトレードオフ的なもので、良い悪いのものではないと思っています。

Mastering Engineer と Recording Engineer で利用する機材が違うのと大差ないもので、要は使いどころで 2ch が最大出力のデバイスを使う人もいれば、32ch のマルチインターフェイスが必要だって言う人もいるだけ。

基本的にご自身で積極的に録音を行う人以外にマルチチャンネルオーディオインターフェイスは必要ありません。なので、アナログコンソールも「アナログのミックスに必要だから利用するんでしょ」みたいな感覚で思われているでしょうし、ITB 制作の中にアナログ機材を追加する人はわざわざコンソールストリップを利用せずに別のアナログギアを選ぶでしょう。そちらのほうが自由度が高い場合も多いですし、コストのかけ方や機材自体の価値みたいなものもわかりやすいです。

ここではアナログコンソールが如何に有能であるか、を語り、それら有能な機能は全部 DAW に置き換えできる、という話をします。アナログだからコンソールが有能である、という話ではなく、DAW は元々アナログコンソールの基本設計に準じて作られているという話を順番にできたらと思っています。

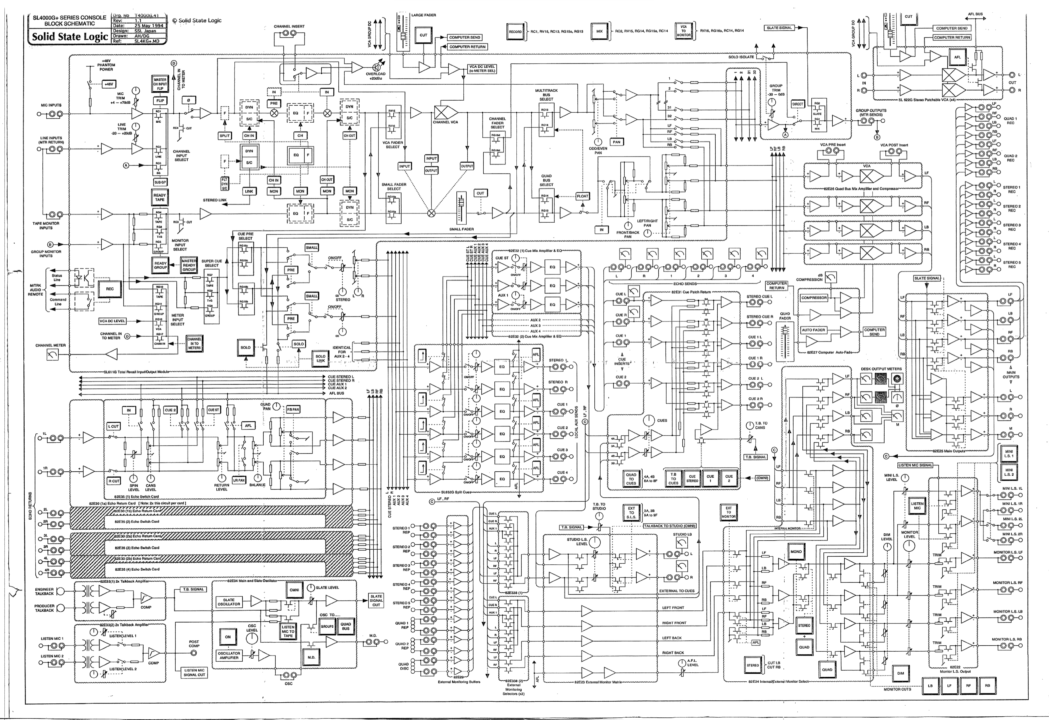

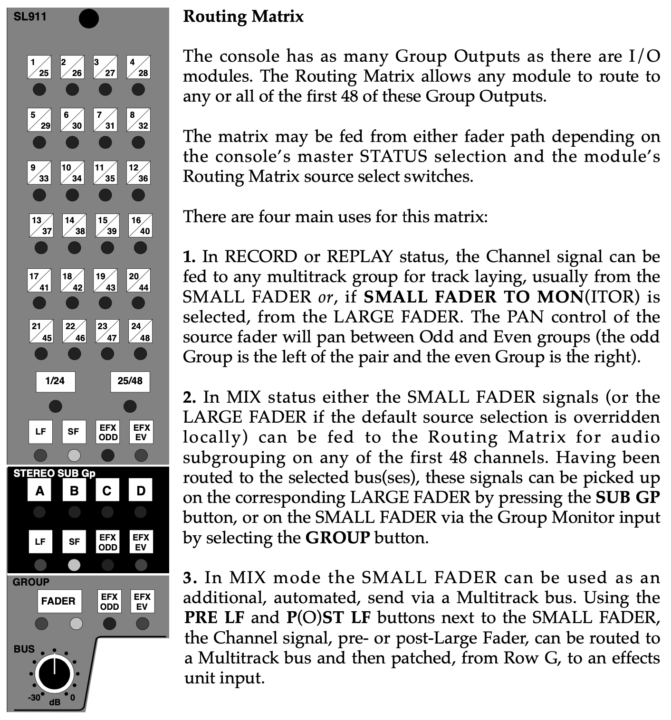

上記はアナログコンソールのブロックダイヤグラムの一例で、アシスタントエンジニアやハウスエンジニアは基本これが頭に入っている。頭に入っていると行っても「コンソールの各機能を理解している」と言う意味でダイヤグラム自体はそれの再確認するために利用するものであり、現代のアシスタントが丸暗記しているか、というとそういうものでもない。大体僕は年に数回しかコンソール触らないのでほとんど忘れましたし。

ただ、信号経路の理解と確認は非常に大事で、コンソールのモニターセクションに音が立ち上がらない理由は 99% ルーティングミスだからアシスタントはこれら信号経路の分岐を完璧に把握しておく必要はある。現状 Input Section と Monitor Section と Insert Return 以外はほぼ使わないし、VCA Control とかは基本はやらないので実際に覚えることは Mix Bus Section、Routing Matrix が主でダイヤグラム画像だとかなり煩雑に見えるが意外と覚えることは少ない。

重要なのはアナログコンソールでは信号経路をコンソールが備えている機能分だけ自由に扱えるということだ。

痒いところに手が届かない Pro Tools っていう DAW もあるけど、基本的にはこれ以上のルーティングダイヤグラムを構築することが現代の DAW では可能です。

ただ、最近の DAW は Send などを作ると勝手に Track を割り当て、そしてそれを自由に変更できなかったりするので、Pro Tools はそういう意味で AUX の自由度は高い。コンソールの不自由な自由度を理解していると、Pro Tools の AUX はわりと無理やりな信号経路を構築できる。

ただ、I/O の出力設定の自由度がクソなのは Pro Tools の悪いところです。

インラインコンソールの本当の素晴らしい利点

まず、SSL 4000 Series や NEVE V Series 以降のインラインコンソールの素晴らしさ、というのは実際に実務的にコンソールを利用してレコーディングしてきた人ではないとぶっちゃけ理解できない。

だから全てが伝わると思っていないが、アナログコンソール、チャンネルストリップを含めて解説してく。

良く「いいマイクプリ、EQ だ」と話題に上がるのは 5000 Series とか 8000 Series の NEVE コンソールのモジュールであるが、あの時代のコンソールはスプリット型といって、日本でスプリット型でこのコンソールでミックスするようなことは現代ではおそらくまず無い。サミング用途などではあると思うけど、商用スタジオには中野にある VoltaStudio くらいしか扱ってないし、リズム録りはとりわけ難しい。

インラインコンソールは Harrison MCI 3232 というコンソールが 1975 年にリリースたのが最初で、これは非常に画期的なコンソールとなりました。のちに SSL が 4000 E を量産化し、1979 年以降、世界的にコンソールといえば Solid State Logic (または Neve の V Series) という感じになりましたが、そのインラインコンソールの良さというのを説明できれば。

レコードチャンネルとモニターチャンネル概念

インラインコンソールには一つのモジュールにフェーダーが 2 つある。

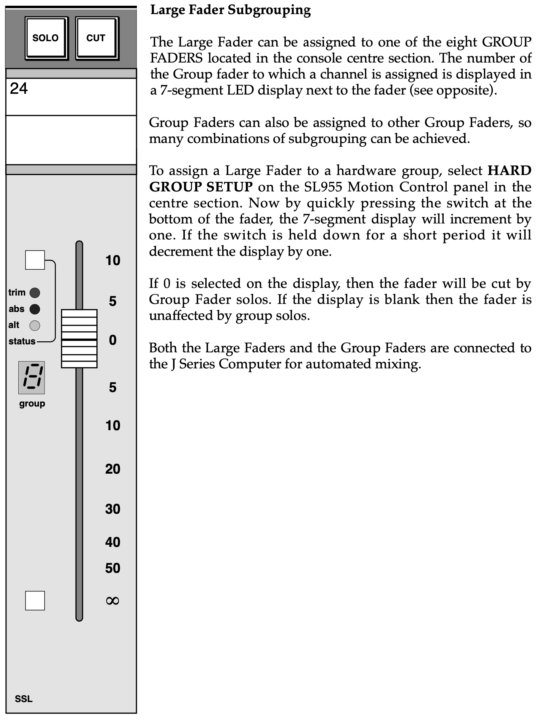

そう、Small Fader と Large (VCA) Fader 。

多分、このポストを読んでる人の 99% の人は Plugin の Console UI しか見たこと無いから アナログコンソールには Fader が 2 つある ことを知らないでしょう。というか、見たことあるとか存在自体は知ってても何故 Fader が 2 つあるのかを理解してない人が多いかとは思います。だってこういう情報はネット上では誰もわざわざ解説してないし。実際にコンソールを触る人がこうやってネット上で手の内みたいなもの明かさないし。

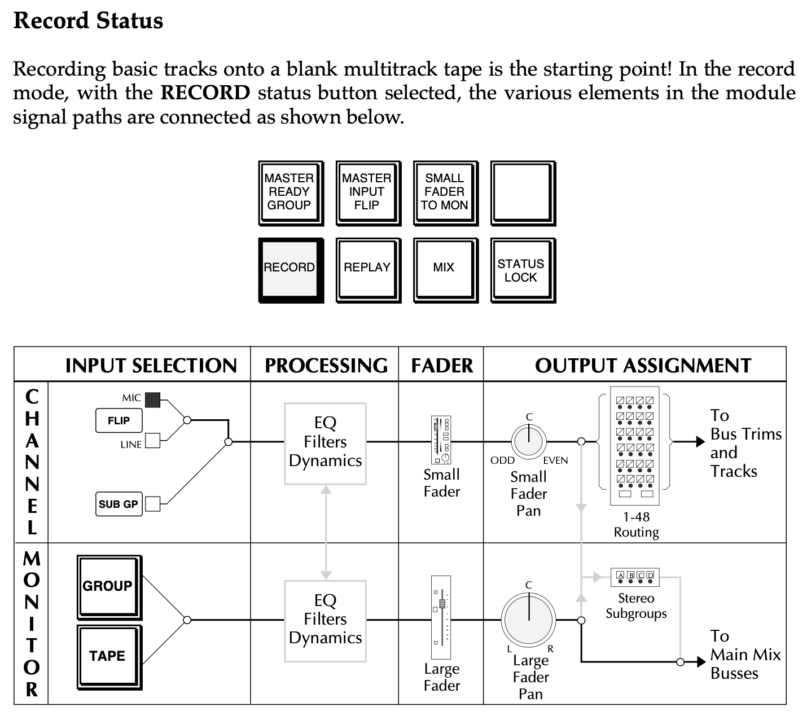

実際には各モードの信号ルールみたいな機能、ボタン一つで大まかな機能というか内部ルーティングが切替えれる Status の切り替えのボタンがあって、ぶっちゃけ現代では「Record」モードか「Mix」モード以外使わないんですが、その切替えで多少異なることが出来て…

まぁ、ある程度のマルチチャンネルレコーディングにおいて大変便利なんですよ。アナログコンソールって。詳しくは知らなくて大丈夫です。

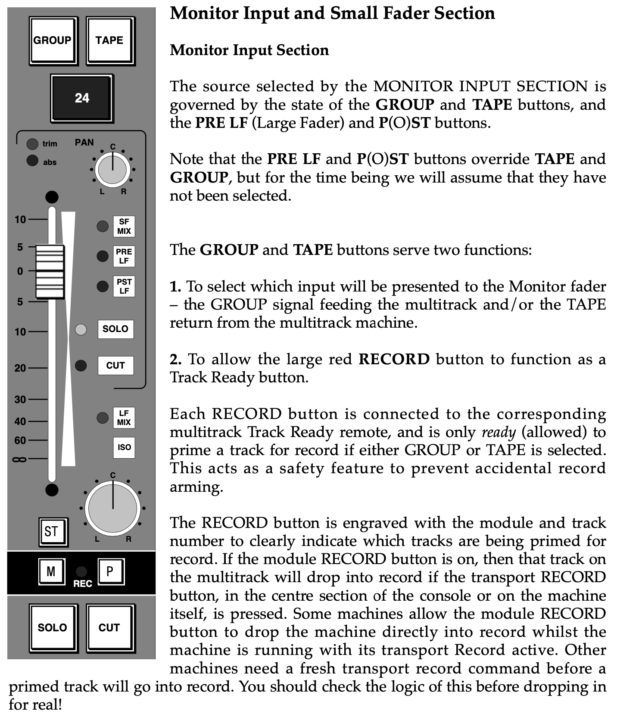

Small Fader

以下はスモールフェーダの画像になる。スモールフェーダー? なんだそれは…という人ばかりでしょう。

これはよく見るスプリット型、リハーサルスタジオとか、ライブハウスに置いてあるミキサーとは全くことなる構造を構築しており、たぶん見たことある人は本当に少ないとは思う。実際のアナログコンソールを利用する現場に出入りしてないと本当に把握出来ない。

実際には現代ではセッティングのとき以外ほぼ触らないので、商用スタジオを頻繁に出入りするけどこのフェーダーの存在を知らない人もいることだろう… 普通は知らなくていいが、ここではコンソールを深く理解するためにこれを読んでいる人は存在だけは知っておいて欲しい。

実際に Small Fader セクションは難しいボタンがたくさんある。現代ではほぼ使わないですが、信号経路を任意に色々アサインできるという点が重要だ。

実際に理解する必要はないが、信号経路を色々いじれるツマミやボタンがあることを知っておけばいい。現代では基本的に DAW にレコードされる信号はこの Small Fader を経由したあとの音だと思えばいい。もちろんすべてがそうではないが日本のどこの商用スタジオでもグループバスを通って DAW 入力だと思う。ただ途中に Insert 分岐もできるのでもちろん自分でアサインは自由だし、パッチから抜き出しもできる。実際スタジオ言ってもアシスタントさんが手伝ってくれるので各スタジオの配線なんて把握してないし、スタジオによって違う場合もあるでしょう。

ほとんどが各スタジオで大体統一の内部ルーティングがされている、もしくはアシスタントがパッチワークしてくれる場合がほとんどですので、このフェーダー後に Pro Tools というか I/O で A/D されると思えばいいです。これは日本の商業スタジオの統一概念だとは思いますが、ただ厳密には知りません。個人的にはそう思ってるだけです。もちろんパッチワークで多少変えることが出来ます。

基本はコンソールの Multi-track (Group) Bus 経由で Record 行くかな… (大体 SSL の Matrix Routing 経由で I/O 直結が商用スタジオだと主かな…) これは育ったスタジオのシステムや下働きの叩き上げ知識でかなり差が出ると思います。僕は SSL マイスターではないのでもう全然覚えてないし忘れてるしでマジで突っ込まれると困ります。

一応 Small Fader to MON とかいうステータスボタンもあって、Small Fader をモニター、つまり SSL の Mix Bus に流すことも出来るんだけど、たぶん使わないですね。Mix Bus っていうのは SSL の 2Mix 回路と思っておけばいいです。スピーカーから出力される最終的なコンソールサミングの LR 2ch の信号こと。SSL の構造と名称がわかってないと説明が難しいけど、別に深く理解する必要はないから無視で OK ですが。

最近コンソール使うとき、皆さんどうしてます…?

Large Fader

わりと結構 UI 的には理解が難しいのですが、こちらがラージフェーダー。たぶん Plugin の UI で表示されている方。

パット見、慣れてないと PAN とか分かりづらい。実際に触るとそうでもないけど。

現代では「ラージフェーダ = 実際の音量フェーダー」で実務的にはほとんど普段はこのラージフェーダーしか触らない。モニターバランスを取るためのフェーダーだと思っておけばいい。

モニターされる信号はラージフェーダーを経由してミックスバスを経由、最後にモニターに出力される。Large Fader に立ち上げた信号はつまり実際にスピーカーから聞こえる信号と思えばいい、それは From DAW、インターフェイスのマルチアウトの信号であることが主。

これもスタジオによって若干違うかもしれないけど、Mic や Line Input はパッチ直のルーティングをすることが多い気がします。Pro Tools In/Out の信号はだいたい SSL のバス直結されているか、レコーディングやモニターセクション (名称はスタジオで割とバラバラ) にパッチで割り込みする。スタジオによって運用方法は違うのであくまで一例です。

すべてのスタジオがそうだとは言えないがコンソールの Routing Matrix の機能に Pro Tools の In/Out が統合されていることがほとんど。Analog In/Out A1-16、B1-16 それぞれ 1-16、17-32、に該当する入出力と紐付けされているとか。それら厳密なチャンネル番号はスタジオによってまちまちですけど。

詳しく理解する必要はない。マトリックスの番号と物理アウトプットの番号が I/O セッティングによってコンソールと DAW と統合されているって話。もちろんパッチワークで出力は変えられる。

ま〜今は 1-2 に Pro Tools Master 出力してわざわざアナログコンソール使うことは TD とかでは殆どないす。はい。ってか僕、コンソールミックスしたことないです。あと持ち込みエンジニアさんが割と多いですし、自分も自前の I/O 出力をモニターセクションにパッチで直結して SSL をただのモニターセレクターにしてるし、同じことしてる人も多いでしょう。。。

もう実際にはリズム録り以外でコンソールの機能を限りなく利用することはほとんどないかもしれないけど、SSL のステータスとしては、Record チャンネルと Monitor チャンネルを分けて、という使い方が主で、実際にマニュアルでもそうやって利用しようって書いてある。

レコード信号とモニター信号

良くある勘違いというか、良くあるレコーディング環境の足りない説明部分というか、ミスリードというか、情報が足りないと思うことがあります。

それは「レコード信号とモニター信号」について別々で語っている人が極端に少ないことかと思います。

またはレコード信号とモニター信号の区別が出来ていないことに由来する問題というか、なかなかプロエンジニアの言っているモニターの概念が理解できない場合があり、そのことについて、プロのエンジニア方もわざと触れてないで、核心は語らず、それらが伝わっていないことが原因かとは思います。

現場を出入りする人は徐々に「レコードシグナル」と「モニターシグナル」の概念を理解出来るとは思いますが、ネット上だけでは全くと言っていいほど語られていません。

なぜ、アナログコンソール、とりわけインラインコンソールが素晴らしいのかを理解するためには、このレコードチャンネルとモニターチェンネルを別々で処理できること、に由来します。

ぶっちゃけダイヤグラムを多少理解していないと以下の画像を理解できないかもしれないですが、多数チャンネルがあると、左側のチャンネルストリップを REC 用に利用して、右側のチャンネルストリップを Monitor に利用する事ができる。

左側の信号が MIC からの信号だと思ってください。右側の信号は DAW からのマルチアウトだと思ってください。

そして、AUX もレコーディングシグナルとモニターシグナルを選択できるし、。チャンネルが余ってれば Cue の信号の調整も出来なくもない。ただ、流石にやらないけど。

これの何がすごいのか?

正直、だから何?って思う人や、何を行っているのか良く分からない人が多いと思います。

これと同じことって DAW だけで実現できますか?

DAW だけの機能でこれが出来る、という言う人はもうここで記事を読まなくていいと思います。

まぁ主要なことだけ話すと…

- レコードチャンネルでは DAW にレコーディングされる前の信号に対してチャンネルストリップを有効にできる。

- モニターチャンネルでは実際にモニターに出力される前の信号に対してチャンネルストリップを有効にできる。

- これらは同一のチャンネルモジュール上でも共存でき、それぞれのセクションでレコードチャンネルまたはモニターチャンネルの信号どちらかに機能を有効にできる (EQ とか Comp のこと)

一応、厳密には Digital I/O のレイテンシーを考慮しなくてはいけないのですが、この場合「レコードされる信号と自分が実際に聞く音、モニターする信号は違う」ということを理解してください。

現代的に言うと「コンソールの EQ や Comp を有効にしたまま信号をレコーディング」しつつ「モニターされる信号に Mixing 用または Monitor 用にコンソールの EQ や Comp を有効にできる」という処理がコンソールだけで完結します。

いや「DAW 上の Insert でプラグイン使えばいいじゃん」って思うでしょ?

CPU ベースの場合、低レイテンシーモード中はレコーディング中にモニタープラグイン有効にできないよねぇ〜って話で、だから HDX DSP があるんだけど、それはプロエンジニアのどうでもいい話で、パフォーマンス重視をする場合、アナログで処理させれば、レイテンシーは人間には知覚できません。

たしかに最近はコンピュータもプラグインも進化しているので、ぶっちゃけ低レイテンシーでもレコーディングしながらプラグインモニターを有効できるけど、まだマルチチャンネルのレコーディングでは際どい現場はあるとは思う。

ただ、セルフのボーカルレコーディングとかの場合はチャンネル少ないし、そこまでコンピュータの処理も必要ないし、最近のオーディオインターフェイスなら割と優秀だし、アナログコンソールなくてもモニター側にエフェクトかけれるんじゃね? って理解できると GOOD だぞ。

重要なのはアナログコンソールだから、とかではなくアナログコンソールで信号をフレキシブルに扱うことを覚えたり理解したりすると「DAW でも応用できるのでは?」という発想に到れるか、である。

アナログコンソールのシグナルワークフローへの理解が DAW の構造理解とルーティングというか各リアルタイムエフェクトへの応用が効くと理解してくれると嬉しいぞ。

例えば自分でレコーディングするとき

良くある DTM とかの解説では、もし自分でセルフで歌をレコーディングするとき、レコーディングされる信号と自分でヘッドフォンなどで自分の声を聞く音は異なるようにしましょう、という説明されていること自分は見たことないので、皆さんここで覚えましょう。

たぶん、意図的にモニター信号を調整している人以外、レコーディングされている音とモニターしている音は同じはずです。厳密に一緒である、というとまた変な人が湧く場合があるのですが、同一と見なせると言っておきましょうか。

基本的には安いというか、グレードが低いインターフェイスでは、ダイレクトモニタリングを利用しましょう的な解説がされているので、たぶんダイレクトモニタリングしている人が多いと思いますので、この場合はレコードされる信号とモニターしている信号はイコールになります。

また、最近のちょっとしたオーディオインターフェイスはちゃんと Near Zero Letency Digital FX を DSP とかで実装しています。UA Apollo とか Apogee とか Antelope とか全部 A から始まるな!

例えば UAD-2 Plugin をリアルタイムで使える Apollo Series のソフトウェアコンソールにはちゃんと、モニター側にエフェクトを有効にするのか、Input される信号にエフェクトを有効にするのかの設定が可能。

もちろん、専用の DAW「Luna」もあるから、モニター側にも UAD-2 Plugin をリアルタイムに利用でき、かなりのリアルタイムパフォーマンスを得られながらレコーディングできる。Luna って全然使っている人を見ないのだけど、レコーディングのエンジニアリングの観点からいうとマジで 100 点に近い設計思想の DAW なのです。

DSP でアナログコンソールのワークフローを再現できるという観点から素晴らしい設計思想の製品を出している。実際のサウンドパフォーマンスがどうかはさておき。

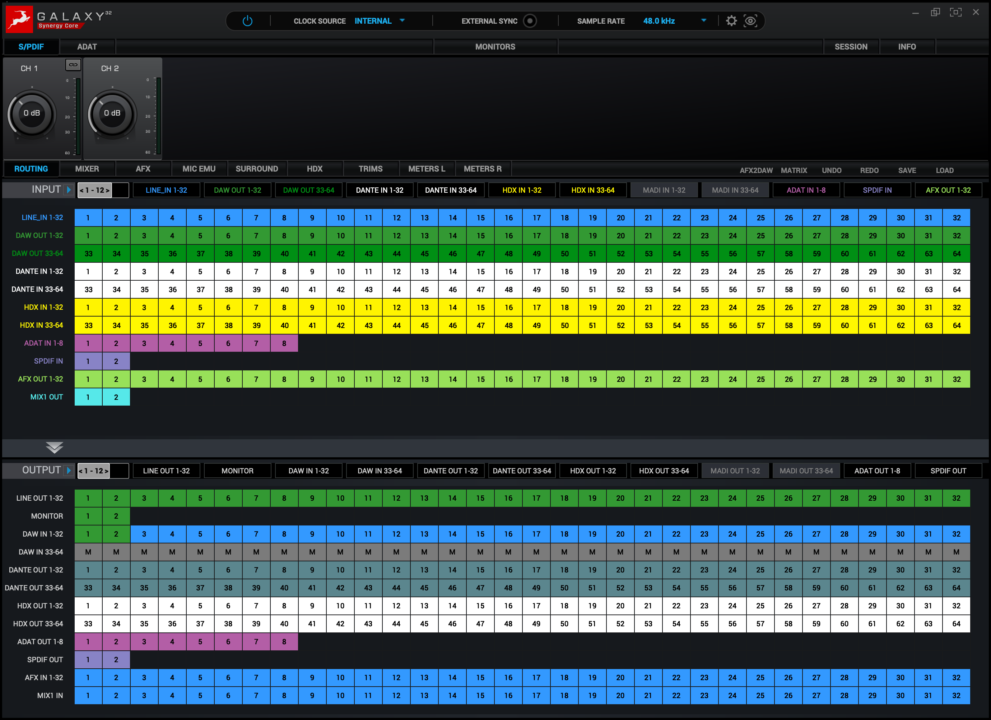

もちろん、これらのルーティングワークフローを完全にエンジニア寄りに設計しているのが、Antelope Audio の Routing Matrix 機能である。確かに自由度が高すぎるのは不便なんだけど、アナログコンソールを理解している人間からすると「超絶ありがたい機能」なのである。

これらは非常に高度にコンソールワークフローを理解していないと「利用価値」や「何故、機能として存在するのか」すら理解出来ない。また、UAD-2 の Realtime Process や Apogee FX、Antelope の AFX などは、何故リアルタイムで DSP などで計算させるかというと、すべてはアナログコンソールと同様のレコードチャンネルまたはモニターチャンネルにエフェクトをレイテンシー無しで実行させるためだ。

インターフェイスに DSP を積んでいる系のプラグインは CPU 分散とか、DAW 連携を考えてしまいがちですが、実際の利用用途としては DAW 側には存在しない、インプットセクションとモニターセクション構築のために存在していると考えると、レベルが高い人になれる。

どうしても DAW 経由では Plugin の掛取りはリアルタイムでは不可能であるし、モニター側で少し処理を増やすとレイテンシーが発生してしまう。そのため、これらはアナログコンソール上で実行していたワークフローの実現のために利用するのが、設計者の意図するところで、真の賢い使い方だ。

モニターする信号がレコードされる信号ではなくていい。

重要なのはこの部分。自分もモニター信号を作る時間がなかったり、 Cue のチャンネルの都合上「レコード信号 = モニター信号」にならざる負えない場合はある。もちろん扱えるチャンネル数が少ないインターフェイスでは難しいし、無理な場合もある。

しかし、より良いレコーディングのためには、レコードされる信号と実際に聞いている信号が違うことに意味がある。

良いテイクは良いモニターから。

エンジニア的な視点からストレートにレコーディングを考えると「録れた音が素晴らしいか」が重要であることは間違いありません。

で、言葉が悪い言い方をすると、録れ高が悪いエンジニアとか「論外」です。エンジニアは常に工学的な視点で出来る限り 100% のレコーディングをし続ける必要があります。もちろん環境によってその工学的な許容のしきい値みたいなものは変動しますが、その環境での 100% の録れ高を目指します。

いい音で録るのは当たり前で、それ以外の「いい音の基準」を満たすために努力するのです。

私が考えている一流エンジニアは「どんなに環境が悪かろうが、機材の選択肢がなかろうが、与えられたフィールドで誰よりも 100% のレコーディングをする人」です。だから、機材の優劣とか環境の優劣でレコーディングの良し悪しを語る人は私にとってはマジでどうでもいいことを語っている人という認識です。

良く「いい機材や環境がないといいレコーディングが出来ない」と言う人がいますが、これはもうストレートに言うと「自分の勝手知るそれ以外の環境ではいい録音ができないレベルの人」ということです。あっ察しってやつ。ただ単純業務としては間違いではないですよ。同じクオリティのものを提供するというサービスの面では。

もちろん私だってレコーディング現場に行ってちょっと戦慄する場合もあります。今日はここで録るのか… って思うときもあります。ただ、その環境で誰よりも 100% に近いレコーディングを行えるだけの対処が出来るか、であります。重要なのは同じ環境で機材で録音したときに、他人と差が出るエンジニアであれ、ということです。

そこで、重要になるのが「どうやって限られた環境で良いテイクを引き出すのか」です。

レコードシグナルは自由度を残す場合もある

環境が十分ではない、宅録やセルフのレコーディングで色々試行錯誤する人の中に、モニターの音作りをちゃんとするべき、と発言する人は最近は増えたとは思います。

ただし、具体的にどうするべきなのか、には触れられません。

僕は歌ってみた系を本当によく知らないので、詳細はわかりませんが、エンジニア的には自由度やある程度の余白というか、ヘッドルームと言うか、許容があると嬉しい立場です。これはプロの現場でも同じことです。

Cue モニターする場合、ボーカルはガッツリコンプ掛かっているほうが気持ちよく歌える人がいるとしましょう。その人がモニターした信号とレコードした信号が同じだった場合、歌ってみたをミックスするミックス師またはエンジニアはコンプが深くかかった音でミックスすることなります。

これが正解か不正解かは、エンジニアの腕や楽曲の方向性によりますが、調整する側の意見としては、余白というか、もう少し許容があるデータでミックスするほうが色々対処が出来る、と言うでしょう。

重要なのは、モニター信号とレコード信号を分けるべき状況であると判断できるか、です。

具体的な方法

プロの場合は先程のリズム録りの例で、アナログコンソールでレコードシグナルとモニターシグナルを別々のグループに流して、レコードされる信号と実際に Cue やモニターする信号を分けることができると言いました。

こうすることで、レコードされる信号は自由度というか、プロセスを経由しないでレコードもできるけど、ある程度処理した信号をコンソール経由で聞くことが出来るといいました。

もちろん、DAW でも Insert に Plugin を指して調整してしまえば、Playback 時には処理後の音が聞こえますし、最近はレコードしつつ、プラグインモニターしながら DAW の 2Mix 出力も聞けるレベルなので、レイテンシーの許容や処理限界等はありますが、コンソールが無くても実現可能です。

また、少し値の張るインターフェイスではリアルタイムデジタルエフェクトがほぼレイテンシー無しで実行できるため、その機能経由で、レコードシグナルのエフェクトスタックとモニターシグナルのエフェクトスタックを分けて別々に扱うことも出来る状況です。

これらは考え方で、方法論は各ご自身の環境に左右されるので、ここでは DAW のみのモニター作りだけを考えます。

オケ (inst2mix) と歌録りのみ。

この場合、限りなくバッファを小さくして、Record track にレイテンシーがほぼないプラグインを指しましょう。このような場合のレコーディングの場合、限りなく廉価なインターフェイス、そしてレコード側にコンプも EQ もない場合が多いでしょう。

このような状況下では、複数のプラグインをシリアルでインサートすると、それだけレイテンシの枷になるので、チャンネルストリップが非常に好まれます。一つのプラグインで Comp EQ 処理が出来るので省エネ? です。

インストの音量と自分の声のバランスを 2Mix 上で調整してしまえば、そのまま歌ってしまっても構わない状況だ。自分でセルフで歌うような状況下であろうから、Playback も同じバランスで上等である場合が多い。

実際は自分で試行錯誤したりして、自分のモニターしやすく、かつ歌いやすいバランスをプリセットとして保存してしまうことをオススメします。

重要なのは歌うときに自分が歌いやすいか、です。それは いい音である必要はありません。

ですから極端なモニターセッティングをしてもいいのです。歌入れモニターするときの Track と Playback するときの信号を分けてもいいのです。

例えば、Record チャンネルと AUX チャンネル 2 つ用意して、歌いながらモニターしているときは極端なエフェクト設定の AUX チャンネルを聞き、Playback するときはもう片方の Record チャンネルにオケ馴染みのいいエフェクトを設定すればいい。Playback 時に Mute の切り替えが必要であるが、そういう対処も出来るのだ。

上記の様に Record される信号と AUX に入ってくる信号は同じですが、Record 側を Mute して AUX のトラックにモニター用のレイテンシのないエフェクトを設定すれば、簡単にリアルタイムモニターする信号とレコードされる信号を分けることが出来る。つまり Playback 時は 青い方 の Track の設定が聞こえるが、歌っているときは 緑の方 の Track 処理の音が聞こえるような感じ。AUX はただのスルー回路なので、Mute する必要性もない。Playback のときだけ Record トラックの Mute 解除するだけ。

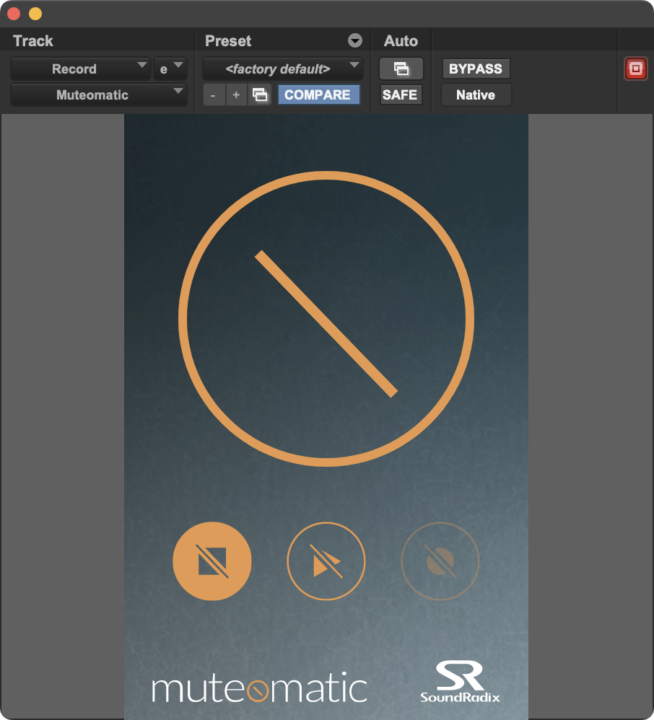

ちなみに Sound Radix の Muteomatic が超便利だぞ。再生している間だけ Mute、もしくは停止している間だけ Mute という状況を作ってくれる。

DAW は簡単に同じ信号を複数に割り当て出来るので、がっつりシグナルスプリットやパラレルを利用していこう。

自作曲である程度 Plugin がインサートされ、レイテンシがある状況での歌入れ

この場合、2Mix Cue と歌の単独を別々で返すことを考えなくてはいけない。どうしても DAW 返りの音が遅れてしまうので、まともに歌が歌える状況ではないのは、頭で想像するだけで理解出来る。

この場合、DAW 側でモニター信号を構築することは、不可能に近い。もちろん Low Latency モニタリング機能を ON にして歌録りすることも可能であるが、それではオケ側のバランスが崩れる原因になってしまう。

まぁ、回避策として一旦 2Mix に書き出して、とかあると思うけど、それやりたくないって場合は往々にしてあると思います。

だから、インターフェイス側の機能を有効活用する時が来たわけです。廉価なインターフェイスでは不可能であることを一つ、言っておかなければいけない。高いインターフェイスにはそれなりに意味のある機能が備わっているのだと、理解して欲しい。

値段 = 音の良さ、でもない。どれだけフレキシブルなレコーディングに対応できるか、も重要である。

これはあくまで一例ですが、自分の持っているインターフェイスの場合、レコード信号とモニター信号に別々のエフェクトをリアルタイムで実行が可能になります。

上記の状態は同じマイクの信号をそれぞれインターフェイス内部のソフトウェアコンソールに立ち上げ、左側のフェーダーが下がりきっている信号を DAW へ入力している。右側のフェーダー 0 dB の信号は歌い手が聞く Cue のヘッドフォンにしか出力されておらず、この信号を聞くことが出来るのは歌い手だけ。

こちらはモニターさせる側のエフェクト、コンプも EQ も結構過激な設定。こちらは演者しか聞こえない。

それぞれ、レコーディングに最適な処理とモニターに最適な処理をインターフェイス上の機能で分けて、それぞれレコーディング用の信号とモニター用の信号として利用している。

Playback 時は DAW 側でオケに合わせた Plugin 処理を施して聞けばいい。この状態はダイレクトモニタリングと同義で、歌っている最中のモニタリングと Playback 時のモニタリングが異なり、ある程度調整しているセッションに歌入れする場合は、オケ馴染みのモニターも出来るし、もちろんチャンネルが余っていれば AUX で Playback 中の単独をインターフェイス上の Cue ミキサーに立ち上げるなども可能。2、3 種の使い分けもできる。

もちろんレコーディング中は DAW 側の Record Input チャンネルは Mute する必要があり、多少フィジカルの調整が出来ない分、DAW 側の操作に注意が必要ではあるが、マクロを組むことで解消もできる。Record 中は該当 Track を Mute するマクロを組めばいい。または Stream Deck 等のフィジカルインターフェイスに割り当てをするなどなど。あと前述の Muteomatic を利用する。

ただ、何にしてもフィジカルボタンへ即座にアクセスできるという点でアナログコンソールのツマミとかボタンとかコントロールサーフェスの重要性も合わせて理解してくれると嬉しい。

すべてタッチパネルやマウス等でアクセスするのはやっぱ私は世代的に難しい。たぶん今のタッチパネル系に完全に UI を支配されてきた世代はそうでもないのだろうけど、おっさんはフィジカルボタンが好きなんだよ。だから無駄にボタンやツマミが多いアナログ機材が好きなんだ笑

即座にシステムを理解できるだけの知識は必要

音楽制作ってセンスとか自分ルールとか、遠回りしたりもアリなんですが、優秀な人ってかなりシグナルフローにかなり汎用性があってかつシンプルでかつ、スマートであることが多い。

前に配信の現場で、クライアント要望を答えてきたけど、回線やシステムの再構築や簡素化、機材の適切な選定が行われてこなかったであろう現場には何度も出くわし、別のチームの受け渡しや映像への信号受け渡しの際に、非常に不可解な場所から信号をもらったり送ることがあった。

一つのインターフェイスで統一できるのに、デジタルのシステムを完全に把握していない場合に起こる、複数アプリケーション信号を別々のコンピュータで動かしてインターフェイスを何故か 2 台運用、そしてアナログまたはデジタル卓にまとめて更に配信用のインターフェイスへ卓アウトを入力して配信など。

確かにフィジカルフェーダーがあるので、一旦アナログないしデジタル卓に渡すのはわからなくもないけど、扱えるチャンネル数が減っているじゃんっていう現場もあった。だったら卓は演者のマイクに絞ってレイテンシーのない配信用のソフトウェアミキサーに全部統合して 2Mix を配信にぶち込んだらスマートやろ〜っていう現場。

もちろん、あちらは会社やチームで動いていて色々事情があって無駄な回線や遠回りなシステムを組んでいるのでしょうが、デキる人ってサーキットアセンブリに無駄がない。一種の物理数学的な思考が必要であります。

DAW も一緒でスマートなシグナルフローを考える

実際には、DAW 自体には Out の構造しかイジれないので、行って戻って、をしてしまうとフィードバックしてしまうのでほとんどがパラレルやスプリット回線が主になる。

もちろん、普段はスピーカーからの出力、2Mix ないし、マスターアウトの信号しか聞かないのは重々承知です。ただ、重要なのは Send Out や Multitrack Out を駆使して、複数のモニター出力系統を構築できるだけの機能を把握しておくことだとは思う。

もちろんオーディオインターフェイスが複数のモニター出力を有していてかつ、それぞれ別々の物理出力を備えている場合に限られるけど、ヘッドフォンで聞く音、スピーカーに流れる音、例えば配信に流れる音、ぞれぞれ DAW ないし配信系のソフトを利用して複数のモニターを作れる、その手順を理解していることが非常に大事です。

レコーディングされる信号 = ミックスでそのまま使える音ではない

中堅者に多いのが「レコーディングされる信号がほぼミックスで後処理なく使える音でなければならない」という思考。

わかる。よくわかる。

これに固執し過ぎてレコーディング時の無駄なアナログシグナルフローを築いてしまう。

もちろん、アナログ機材をふんだんに利用したレコーディングシグナルがほぼ、そのままミックスで使えることに越したことはないです。ただ、現代のポストプロダクションのレベルから言って、それはそういう音を狙ったときしかありえない、です。

我々、と言っても自分だけかもしれませんが、商業エンジニアは如何なる対応にも答えていかなくてはいけないという、ちょっと音楽制作において非常に曖昧な位置に属しています。

当たり前ですが、完成予想を想定して録音していた楽曲が急遽方向転換して、元々の完成予想とは異なってしまう案件はあります。これは、思った以上によくあることです。その場合エンジニアは「対応できません」ではないのです。「やります」なのです。

もちろん、完全に真逆な方向転換で真夏の曲を冬ソングに変更、みたいな話があったとしたら、そりゃ、エンジニアどうこうの前にプロジェクト自体を再出発する必要がありますが、エンジニア対応できるよね、レベルに思われたら、やるのです。

流石に予算問題とか無茶振りは相談したり、最悪撤退とかあると思いますけど、我々はそういうときのためにもレコーディングされる信号にある程度の余白、許容、変化の幅をもたせられるような、そういうレコーディングが求められる場合もあるのです。

だから、モニターする信号が完成予想に近い場合でも、レコーディングされている音がそのモニターしている音ではない、という部分に価値や意味が生まれてきます。

もちろん、完全に方向性がガチガチで決まっている場合もあるので、その場合は、レコーディング前に予習しまくって、セッティングとかも念入りに確認してレコーディングに望みます。たぶん普通の人はこちらの思考に至ることが多いでしょうね。

ただ、あくまで僕のような職業エンジニアは、モニターは演者や D や P を満足させるための音で、自分が完成品予想のためにレコーディングしたい音とは異なるということを理解してください。モニターとレコードシグナルは一緒ではなくていい、というのはかなり精神的にもアドバンテージを得やすいです。

最後に

動画等の解説を挟まないと、要領を得ない方も多いかと思いますが、それでいいと思います。

最初は全く理解に苦しむでしょうし、なんでそんな面倒くさい事をしなくてはいけないのか、って思うでしょう。数年後、あなたがこの解説を理解出来ることを願ってソソクサと逃げることにします。

バイチャ。

おまけ。

なぜ、Channel Strip が有能なのか、について Dynamic Section の話をしようと思う。

実はコンプレッサーについて熱く語る人は多いのは明白だろうが、私は結構 Expander について熱く語ってきた方だと思う。ただ、割合としてはコンプのほうが重要であることが多いので Expander を多く語れることが少ないのも事実。

実は Expander は Compressor と違って、もっと積極的に ADSR に干渉できるんだ。

大体 Gate のような使い方しか皆さんしてこなかったと思うけど、特にリズム録りでは Expander のスローアタックは非常に役に立ちます。

そして、後段の Compressor でダイナミクスを復元するのです。最近はかなり有能な Gate や Expander プラグインが出ているので Channel Strip の Expander を利用する人はかなり減ったとは思います。

ただ、リアルなリズム録りではまだ、有効的に利用できます。

上記はマイク直の音で無処理な状態。これを混ぜても問題はないんだけど、もっと分離良くモニターさせたいなって思った場合、Expander を利用して被りの音を少し減衰してあげる。

Expander のみだと、立ち上がりが弱くなりもちろんレベルも全体的に下がってしまう。Expander は単体で利用することは私個人としては稀で、その後の Compressor や EQ で原音のディティールを復元する。

若干シンバルが強いところで Expander が戻って入るものの、モニターする場合では十分な抑制が出来ている。これに Overhead や Room など複数の音が混ざってくるので、スネアの抜け、自体はモニターで良くなるはずだ。このように簡易的にモニター音を作る場合、レイテンシーのない Channel Strip は短い時間である程度の当たり調整ができる。画面に必要最低限のエフェクトがあるので、これで調整出来ない人はもっと頑張ってください! としか言えないかな。

実際のレコーディング時ではこの設定は少し Expander が強いですが、ある程度 Channel Strip で当たりをつけて、Record もしくは Monitor 側で調整することによって、各リズム楽器のモニターもしやすくなり、リズム録りのモニター作りの最良となる。

Expander は Attack の調整がシビアで (この CHST は FAST、MED、SLOW の三択だが…) 大体リリースの挙動的に Attack が早すぎるとディディールが崩れる傾向にある。

だから、少しアタックがなくなっても リリース を上手に調整して、目標の音像のために減衰を調整する。その後の Comp と EQ で原音の Attack もとい Transient を復元すればいい。

追加の Envelope デザインは後の細かいエフェクトで調整すればいいが、アナログコンソールのチャンネルストリップで当たりを付けることができれば、レコーディング時のモニターや後のミックスプロセスで如何に良い影響を生むか理解してくれると本項では嬉しい限り。